收稿日期:2023-09-08

DOI:10.19850/j.cnki.2096-4706.2024.05.027

摘" 要:血细胞分割结果是医生诊断病情的一项重要依据。医学检测血细胞方法容易受外界干扰且效率低下,传统图像分割模型精确度低,对背景杂乱的血细胞图像分割效果差。为提高血细胞分割效率与准确性,提出一种基于Swin-UNet改进的血细胞分割算法,首先通过迁移学习引入Swin-UNet在ImageNet上预训练模型参数作为特征提取前端,提高模型的泛化能力;其次根据Swin-UNet算法改进下采样模块归一化函数,提高模型训练速度。实验结果表明,所提方法在精确率、召回率和F1指标上有较大提升,其值分别是97%、98%和97%,相较于传统的UNet分割方法提高3%。

关键词:血细胞分割;图像分割;深度学习

中图分类号:TP391.4" 文献标识码:A" 文章编号:2096-4706(2024)05-0124-05

Research on Blood Cell Segmentation Method Based on Swin-UNet

WU Yunxi, YANG Fuzhou, YANG Yao, LIU Chengqian

(Yangtze University, Jingzhou" 434023, China)

Abstract: The result of blood cell segmentation is an important basis for doctors to diagnose patients condition. Medical blood cell detection methods are susceptible to external interference and have low efficiency. Traditional image segmentation models have low accuracy and poor segmentation performance for blood cell images with cluttered backgrounds. To improve the efficiency and accuracy of blood cell segmentation, an improved blood cell segmentation algorithm based on Swin-UNet is proposed. Firstly, Swin-UNe is introduced through transfer learning to pre train model parameters on ImageNet as the feature extraction front-end, improving the models generalization ability. Secondly, based on the Swin-UNet algorithm, the normalization function of the down-sampling module is improved to improve the training speed of the model. The experimental results show that the proposed method has significant improvements in accuracy, recall, and F1 index, with values of 97%, 98%, and 97%, respectively, which is 3% higher than the traditional UNet segmentation method.

Keywords: blood cell segmentation; image segmentation; Deep Learning

0" 引" 言

血常规检查是反映人体健康状态的一项重要手段,目前检测血细胞的方法主要是使用全自动血细胞分析仪器和血涂片细胞检查,其结果是帮助医生做出诊断结果的一项重要依据。对于现态学[1],血细胞分析仪器主要运用化学、物理和生物学的技术,识别效率虽然较高,但是细胞形态展现不完整。血涂片工作量大、效率低,同时容易受到外界因素的干扰,对执行检验操作的医师要求高。随着数字图像处理技术不断进步,利用图像处理技术代替人工进行血细胞分割逐渐成为主流[2]。

早期传统图像分割方法主要利用图像单一特征,例如纹理、灰度、形状等。常用传统方法主要包括基于阈值[3]、基于分水岭[4]、基于模糊理论的分割方法等。基于阈值的分割方法是根据图像中灰度特征信息计算分割细胞和背景所需要的灰度阈值,并与每个像素灰度值相比较,将所得标签一一分配。基于分水岭的分割方法以拓扑理论为基础,可用来处理因细胞粘连或者图像灰度值分布不均匀导致细胞分割困难的情况。其优点算法快速高效,缺点则是容易造成图像的过度分割,在噪声信息较多的图像中分割效果较差。目前,针对以上缺点,研究人员根据任务需求对其做出提前去噪、强制标记等改进。基于模糊理论的分割方法研究事物本身模糊性,通过对现实对象分析和数据处理构建数学模型,应用模糊理论是解决细胞分割中的过度分割问题。除以上传统细胞图像分割算法,还有基于区域、图论等。每种方法由于应用场景不同各有优缺点。因此,许多学者将多种细胞分割算法联合使用,通过新算法显著提高细胞分割效果。

随着人工智能迅速发展,深度学习算法在计算机视觉中表现出优越的效果和性能。许多学者将深度学习算法应用到医学分割问题上。2015年,Ronneberge[5]等人提出具有编码解码结构和跳跃连接的U-Net神经网络,该网络提高了医学图像分割准确率,成为目前医学图像分割基础网络。2020年,Huang [6]等人提出具有全尺度跳跃连接的UNet3+,此连接将来自不同尺度特征图的低级语义与高级语义相结合,提高分割精度。Qin等人提出的U2Net [7]作为一个两层嵌套的U型结构,可以更好提取深层次的语义特征,达到更好的分割效果。2021年,Swin-UNet [8]由慕尼黑工业大学、复旦和华为提出,延用U-Net中U型结构,利用Transformer [9]在特征图中捕获长距离特征的优势,弥补CNN不能把握全局信息的缺点,通过Swin Transformer [10]块更好地获取局部和全局的语义特征,所以Swin-UNet在医学图像方面有更好的分割效果。

为解决图像分割领域数据集匮乏的通病并提高对不同大小、背景杂乱细胞图像分割精度及模型训练速度。本文首先通过迁移学习引入Swin-UNet在ImageNet上的预训练权重作为特征提取的前端,提高模型的泛化能力以及分割精度。其次,本文将Swin-UNet作为基础网络,更改其中下采样和上采样模块归一化函数,保证分割精度的同时,加快网络训练速度。

1" 迁移学习

迁移学习能够在机器学习中解决训练数据不足的问题,增强模型的泛化性。它通过放宽训练数据和测试数据必须符合同一分布的假设,使训练数据可以与测试数据分布不同,扩大训练数据的数量,这对许多训练数据匮乏的领域有着积极影响。迁移学习可以分为4大类,分别是基于实例、基于映射、基于神经网络、基于对抗的迁移学习。1)基于实例的迁移学习是指使用特定的权重参数调整策略,通过为选中的实例分配适当的权重,从源域中选择部分实例作为目标域训练集的补充。Yao [11]等人提出的TaskTrBoost是一种快速算法,可以促进对新目标域的快速再训练。

2)基于映射的迁移学习是将实例从源域和目标域映射到一个新数据空间,在这个新数据空间,映射后的所有实例均可以作为神经网络的训练集。Long [12]等人提出联合最大均值差异(JMMD)来衡量联合分布的关系以适应不同领域的数据分布,从而提升预测效果。3)基于神经网络的迁移学习是指复用在源域中预训练的部分网络,包括网络结构和连接参数,对于神经网络而言,预加载其他相似任务上的网络参数能够提升模型预测效果。例如Yosinski等人指出网络结构和可迁移性之间的关系,证明某些模块可能不会影响域内准确定,但会影响可迁移性。4)基于对抗的深度迁移学习受生成对抗网络(GAN)启发,通过对抗找到适用于源域和目标域的可迁移特征。基于对抗的深度迁移学习有着良好的实用性,近些年得到快速发展,文献[13]中作者提出了一种对抗训练方法,通过增加几个标准层和一个简单的新梯度翻转层,使其适用于大多数前馈神经网络。

上述提到的迁移学习算法,都需要在其适用的场景才能发挥最大作用,且4种方法可以交叉结合使用提升效果。随着深度学习不断发展,各式各样的任务出现,结合神经网络的迁移学习方法将会得到广泛应用。由于血细胞图像数据集的匮乏,根据迁移学习各自的特点,本文选择基于神经网络的迁移学习,使用Swin-UNet在ImageNet数据集上的预训练模型参数作为特征提取前端,优化模型参数,提高预测精度。

2" 网络模型

2.1" 整体网络架构

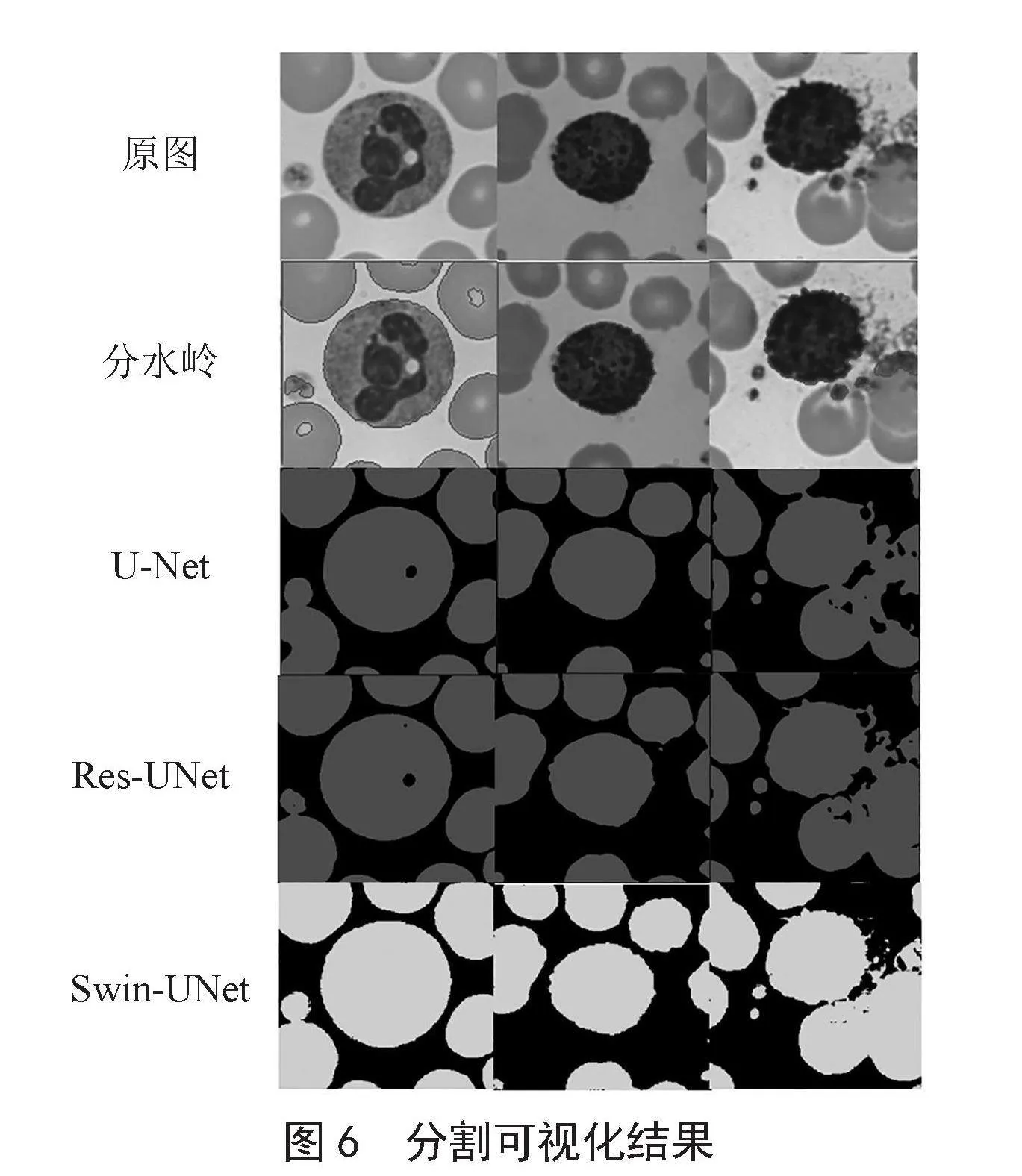

本文提出基于Swin-UNet改进的算法实现了血细胞的分割,网络架构如图1所示。Swin Transformer作为主体网络,基于SwinUnet的补丁扩展层,提出效率更高的Down-Sampling模块、Up-Sampling模块,使网络在获取更多有效信息的基础上,能更快速地实现精确的细胞分割。

图1" Swin-UNet网络架构

2.2" 骨干网络Swin Transformer

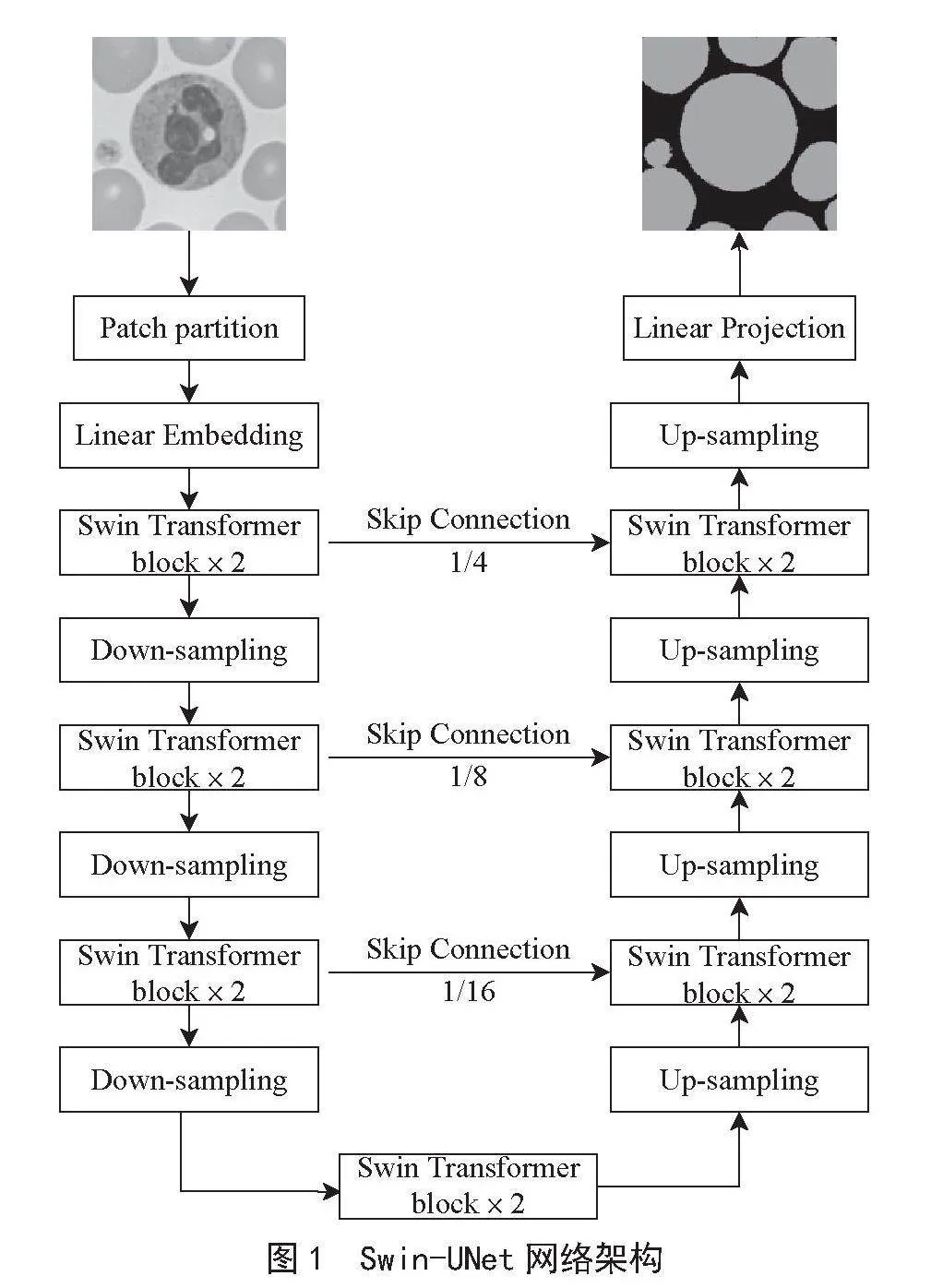

Swin Transformer是网络中的基础模块,与传统的多头自注意结构不同的是,Swin Transformer是由滑动窗口构建的。Swin Transformer由归一化层、多头自注意力模块、残差链接和具有GELU非线性的多层感知机构成。如图2所示,在两个连续的Swin Transformer模块中,分别采用不同的多头自注意力模块。第一个模块采用基于窗口的多头自注意力模块(W-MAS),第二个模块采用基于滑动窗口的多头自注意力模块(SW-MSA)。

图2" Swin Transformer Block

图2中MLP为多层感知机,W-MSA为基于窗口的多头注意力,SW-MSA为基于滑动窗口的多头注意力,LN为归一化层。

W-MSA相较于传统的MSA,对计算范围进行限制,从而降低计算复杂度,提高训练速度。由于窗口互不重叠,导致窗口之间的信息没有被计算在内,且各个窗口之间没有信息交流,SW-MSA就完美的解决以上问题。SW-MSA不仅能加强全局信息的提取能力,还能降低计算复杂度。MSA与W-MSA复杂度的计算式见如(1)(2)所示。假设H、W为56,C为96,M为7。带入式(1)和式(2),可以发现式(1)得到的计算复杂度是式(2)的64倍,从而证明W-MSA可以降低计算复杂度。

Ω(MSA) = 4HWC 2 + 2(HW)2C" " " " " " (1)

Ω(W-MSA) = 4HWC 2 + 2M 2HWC" " " " "(2)

式中,W为图片的宽度,H为图片的高度,C为图片的维度,Ω为复杂度,M为图像块数量。

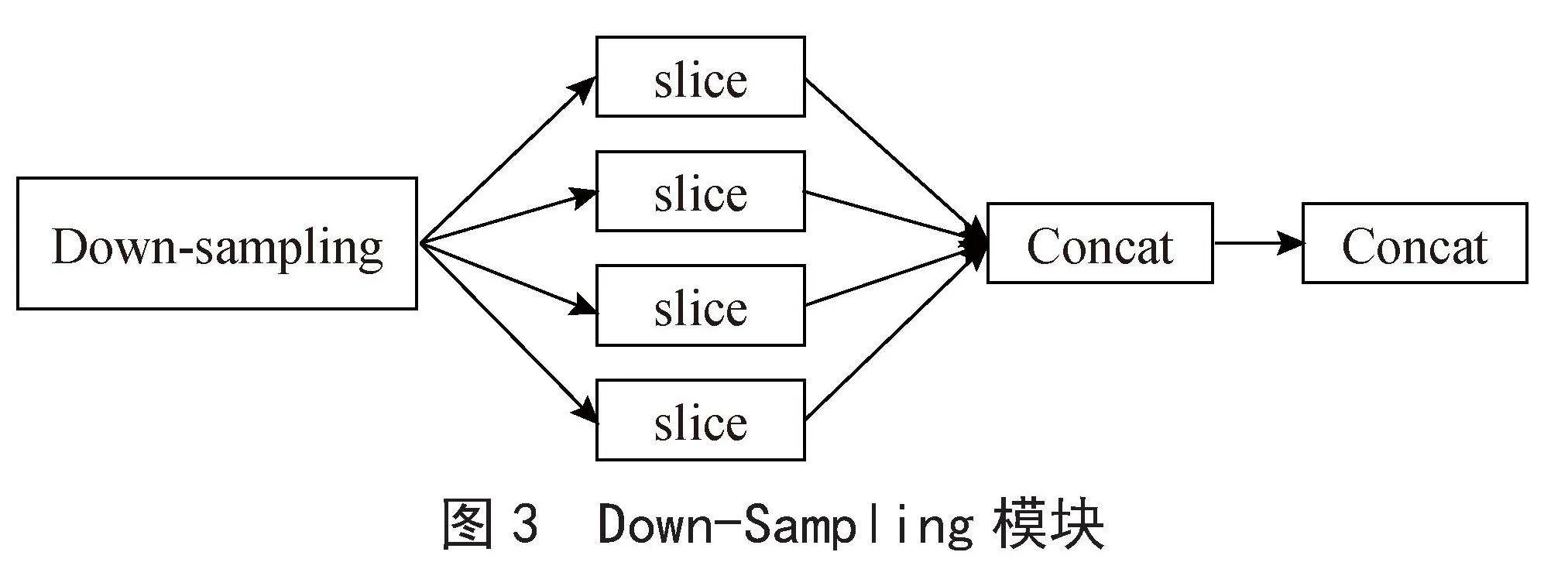

2.3" Down-Sampling模块

一直以来,Swin-UNet使用补丁扩展层进行下采样,提取图像的深层信息。在补丁扩展层中,将图像的高和宽减半,维度升为原先两倍,输入从而被分成四个部分,所以特征分辨率会下采样两倍。但是在补丁扩展层中由于使用层归一化(LN),减缓下采样的计算的速度。因此,如图3所示,本文将补丁扩展层中的层归一化(LN)换成批量归一化(BN),在保证预测精度的同时,最大程度加速训练的计算速度。

图3" Down-Sampling模块

2.4" Up-Sampling模块

Swin-UNet解码器主要由补丁合并层进行上采样,上采样将图像的高和宽缩小至原先尺寸的一半,作为一个完全对称的网络结构,解码器也是每次扩大两倍进行上采样。与Down-Sampling模块相同,本文将补丁合并层中的归一化函数更改为批量归一化(BN),从而加快上采样的计算速度。

3" 实验过程

3.1" 数据集制作

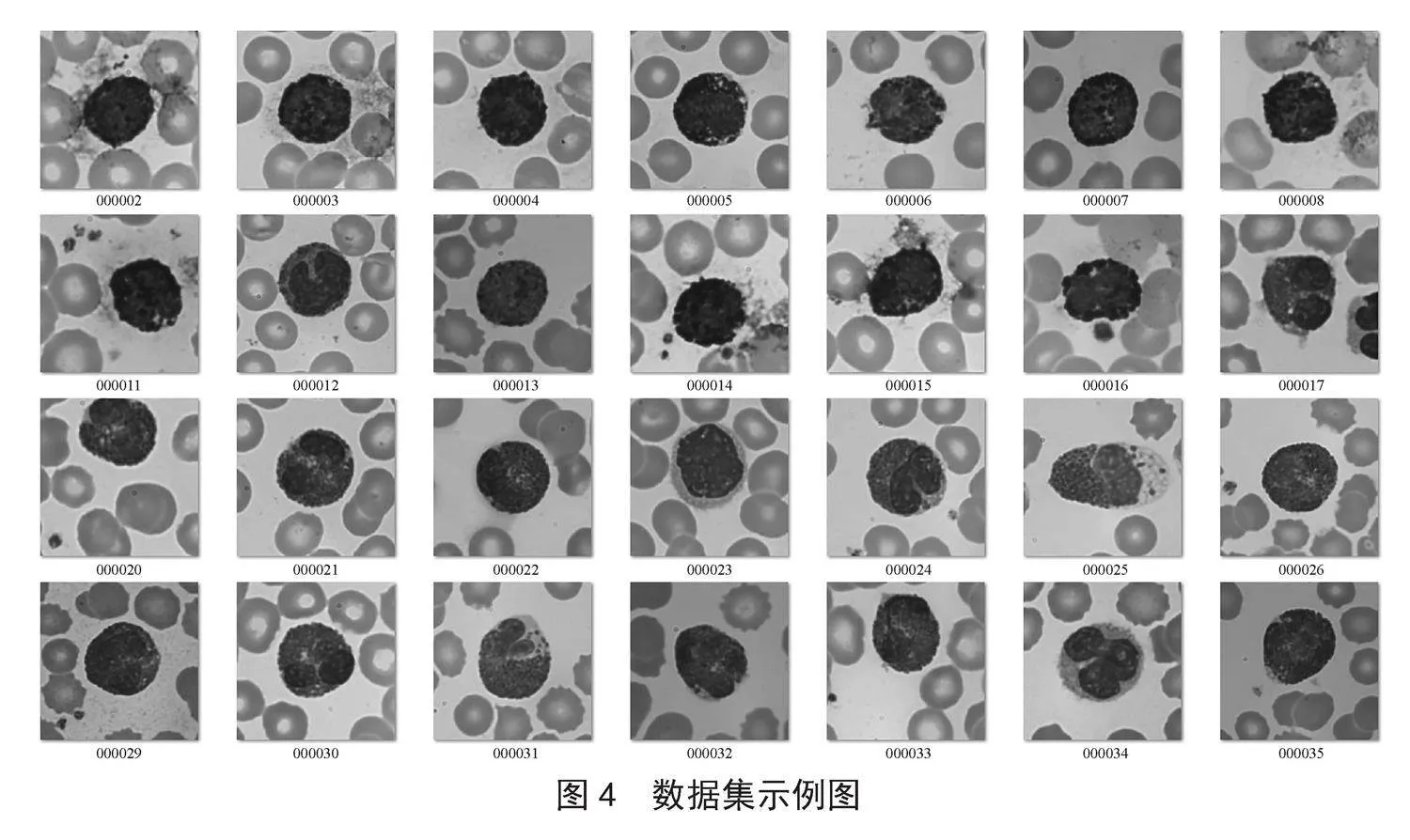

实验中用到血细胞数据集由OLYMPUS CX43双目显微镜观测获得。该数据包含183张血细胞图片,训练集、验证集、测试集按照约为8:1:1比例进行划分,即147张图片作为训练集,18张图片作为验证集,18张图片作为测试集,如图4所示。

数据集标注采用标注工具Labelme 3.16.7,标注形式不再是传统的矩形框形式,而是选择多边形的框选方式,以提高细胞边缘的分割精度。

3.2" 实验训练

本文的实验基于Python 3.8和PyTorch 1.13.1实现的。对于所有训练案例,使用翻转和旋转等数据增强来增加数据多样性。输入图像大小和补丁大小设置为224×224和4。使用具有4 GB内存的NIVIDIA GeForce RTX 3050。在ImageNet上预训练的权重用于初始化模型参数。训练期间,学习率设置为0.001,训练批量设置为4,并且使用动量为0.9、权重衰减为1×10-4的流行SGD优化器进行反向传播,训练执行100个轮次。

在损失函数方面,本文采用联合损失LDice和交叉熵损失LCE进行监督。LDice优点是偏向于正样本,有较低的FN,但是训练损失不稳定,容易出现过饱和现象。因此,本文联合交叉熵损失函数LCE使模型训练效果较差时,学习速度加快;效果较好时,降低学习速度。联合损失L表示如下:

L = LCE + LDice" " " " " " " " " " " " " (3)

3.3" 评价指标

本文使用精确率(Pecision, P)、召回率(Recall, R)、F1三个指标对图像分割效果进行评估。

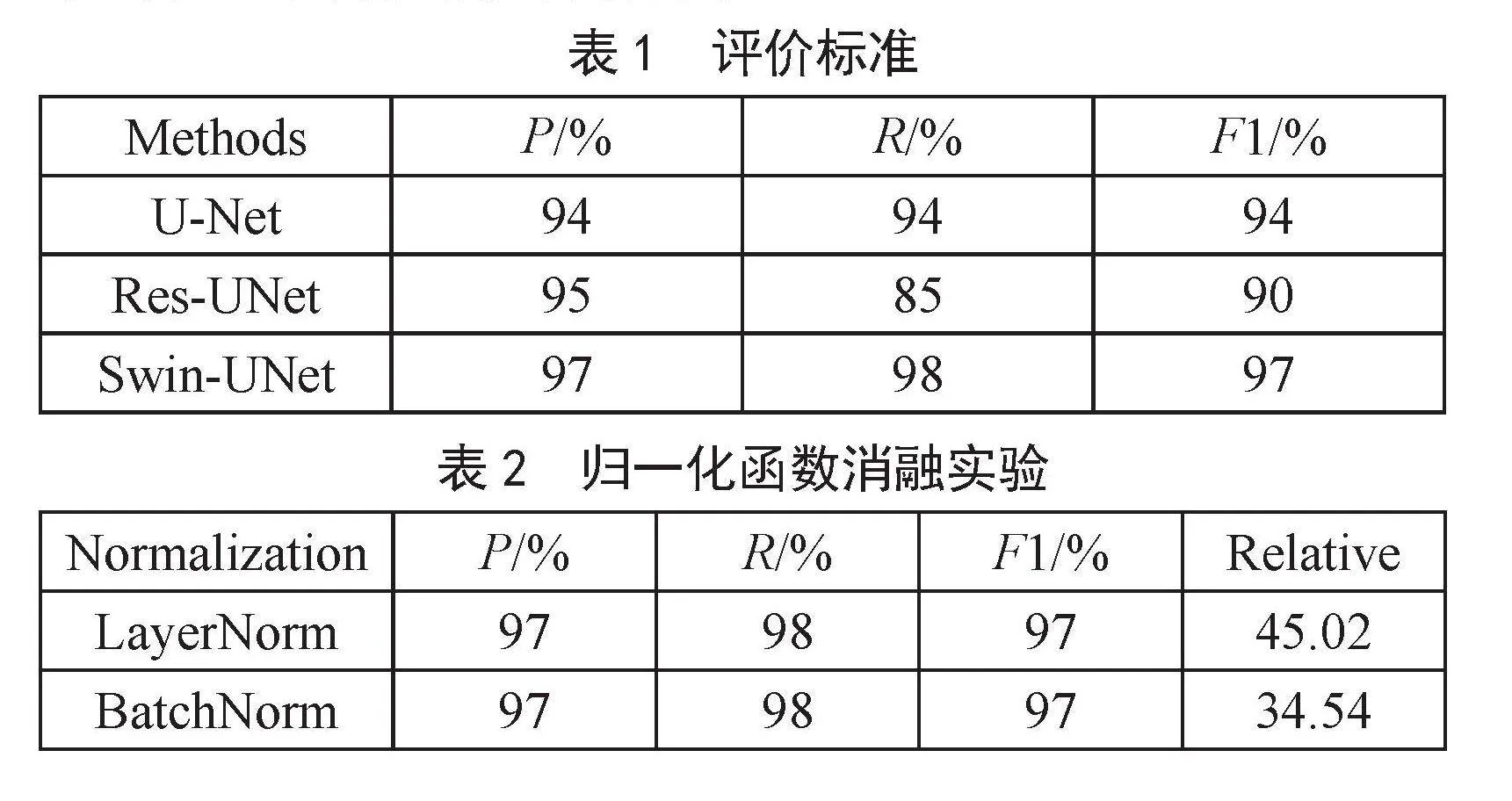

3.4" 实验对比

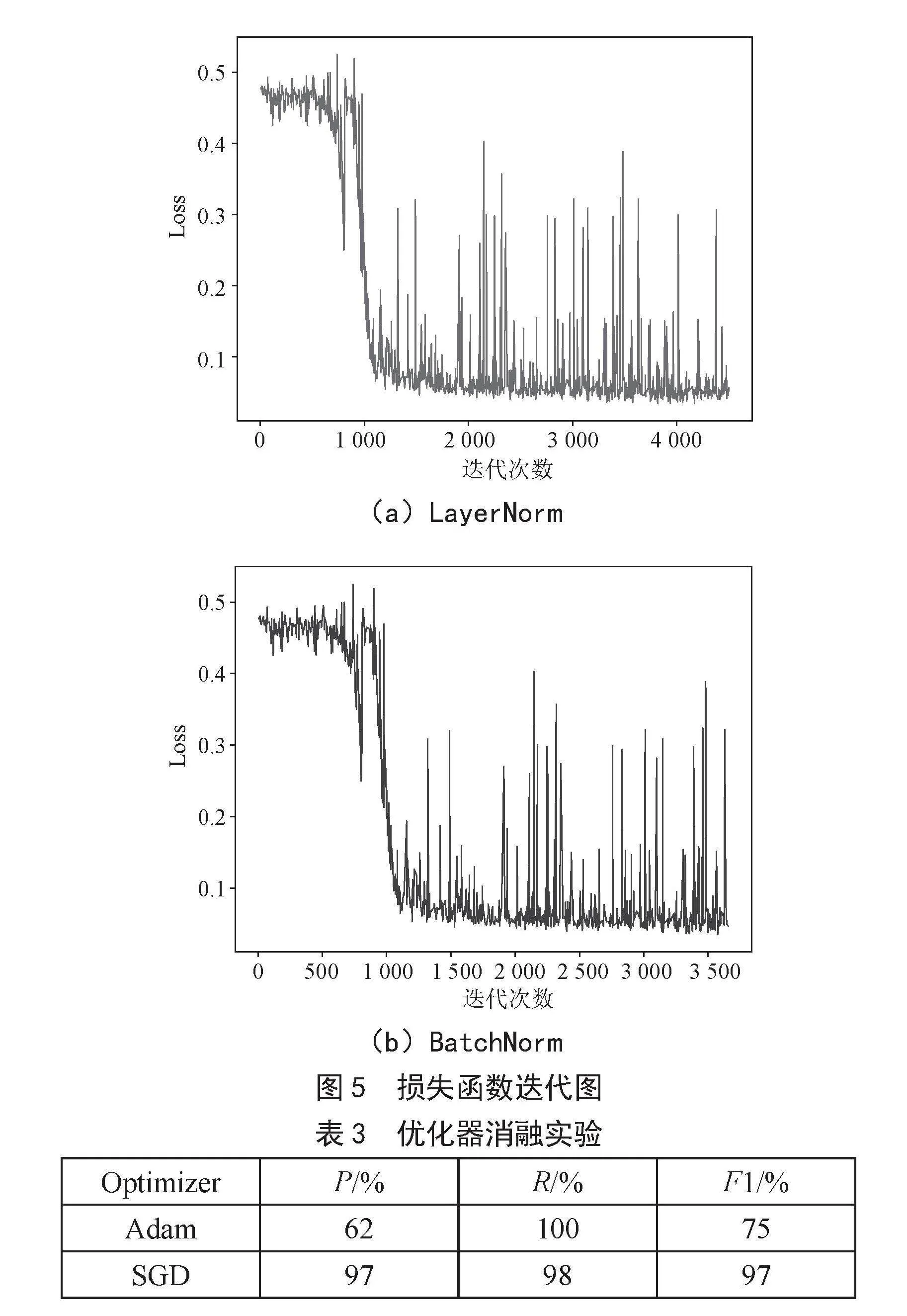

为验证模型的分割性能,将U-Net、Res-UNet、Swin-UNet通过对比3种评价指标来验证模型分割效果,如表1所示。实验结果表明,本文方法实现性能最佳,分割精确率为97%,召回率为98%,相较于传统的医学分割网络U-Net分别提高2%和3%。通过将Swin-UNet上采样和下采样归一化函数更换为批量归一化,模型精确度不变且训练速度提高24%,如表2所示。基于层归一化、批量归一化的损失函数迭代图如图5所示。本文通过更改反向传播过程优化器,探讨不同优化器对模型分割性能的影响,通过表3我们可以看到采用随机梯度下降(SGD)的模型分割效果更好,出现该问题的原因是Adam考虑历史梯度的平均值,出现过拟合现象。

表1" 评价标准

Methods P/% R/% F1/%

U-Net 94 94 94

Res-UNet 95 85 90

Swin-UNet 97 98 97

表2" 归一化函数消融实验

Normalization P/% R/% F1/% Relative

LayerNorm 97 98 97 45.02

BatchNorm 97 98 97 34.54

(a)LayerNorm

(b)BatchNorm

图5" 损失函数迭代图

表3" 优化器消融实验

Optimizer P/% R/% F1/%

Adam 62 100 75

SGD 97 98 97

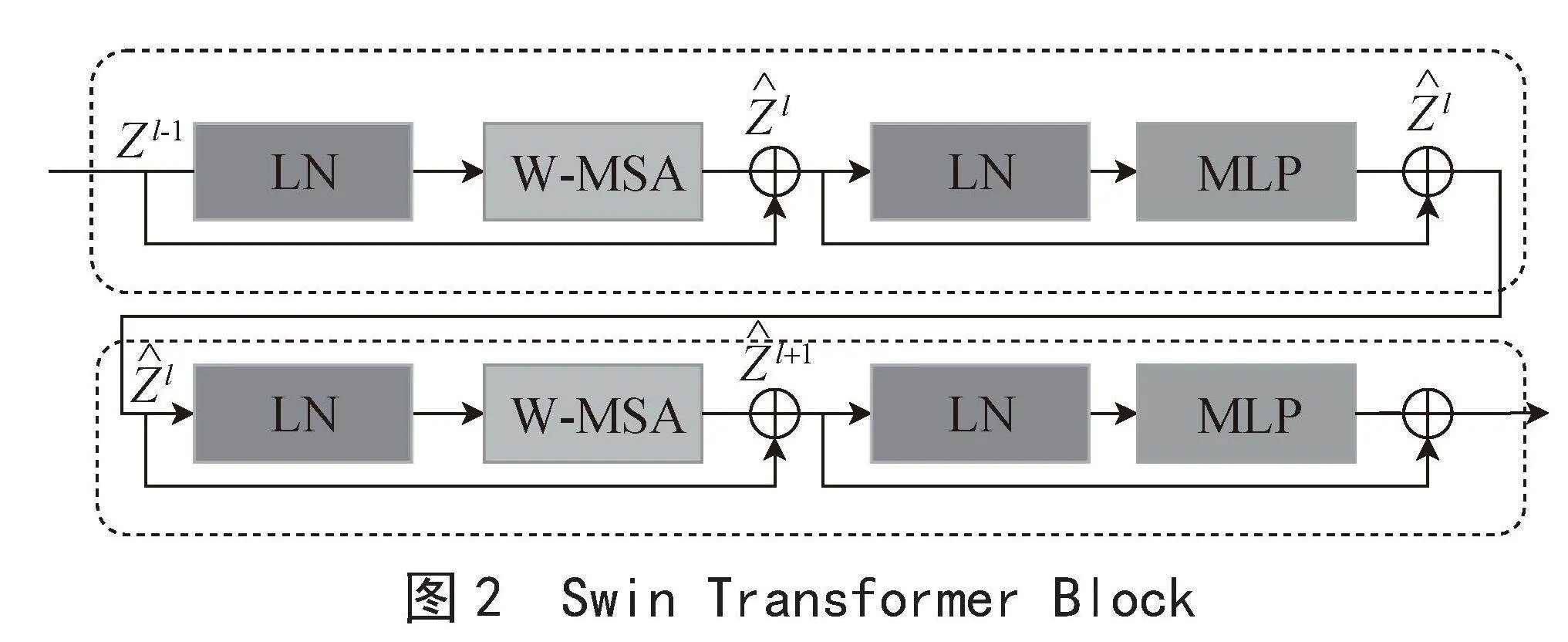

在测试集中随机抽取3张图片进行预测,各模型的分割可视化结果如图6所示。

图6" 分割可视化结果

对比效果可以发现,背景干净的图片分割效果没有太大差别,但针对背景模糊、含有杂质的测试集图片,传统分割方法与基于CNN的方法受杂质影响大,Swin-UNet边缘分割效果最佳。

4" 结" 论

本文提出一种基于改进Swin-UNet的血细胞分割算法,该算法会在提高细胞分割精度的基础上,加快模型训练速度。通过对实验结果进行分析,从评价指标和分割效果两方面进行比较,基于改进Swin-UNet的算法在数据集、学习率、Batchsize都相同的前提下,分割效果相较于传统Net精确度提高了3%,训练速度相较于传统Swin-UNet提高了24%。我们将在接下来的研究中继续探讨Swin-UNet在细胞分割方面的应用。

参考文献:

[1] 颜玉松,尹芳洁,王彩玲.融合Xception特征提取和坐标注意力机制的血细胞分割 [J].计算机系统应用,2023,32(1):275-280.

[2] 袁甜,张海燕.全自动血细胞分析仪与血涂片细胞形态学在血常规检验中的联合应用效果 [J].世界最新医学信息文摘,2019,19(90):167-168.

[3] BERGMEIR C,SILVENTE M G,BENÍTEZ J M. Segmentation of cervical cell nuclei in high-resolution microscopic images: A new algorithm and a web-based software framework [J].Computer Methods and Programs in Biomedicine,2012,107(3):497-512.

[4] LI H,SUN G X,SUN H Q,et al. Watershed algorithm based on morphology for dental X-ray images segmentation [C]//2012 IEEE 11th International Conference on Signal Processing.Beijing:IEEE,2012:877-880.

[5] RONNEBERGER O,FISCHER P,BROX T. U-Net: Convolutional Networks for Biomedical Image Segmentation [C]//Medical Image Computing and Computer-Assisted Intervention – MICCAI 2015.Munich:Springer,2015:234-241.

[6] HUANG H M,LIN L F,TONG R F,et aL. UNet 3+: A Full-Scale Connected UNet for Medical Image Segmentation [C]//ICASSP 2020 - 2020 IEEE International Conference on Acoustics,Speech and Signal Processing (ICASSP).Barcelona:IEEE,2020:1055-1059.

[7] QIN X B,ZHANG Z C,HUANG C Y,et al. U2-Net: Going deeper with nested U-structure for salient object detection [J/OL].Pattern Recognition,2020,106:107404[2023-08-10].https://doi.org/10.1016/j.patcog.2020.107404.

[8] VASWANI A,SHAZEER N,PARMAR N,et al. Attention is all you need [C]//Proceedings of the 31st International Conference on Neural Information Processing Systems.Red Hook:Curran Associates Inc,2017:6000-6010.

[9] LIU Z,LIN Y T,CAO Y,et al. Swin Transformer: Hierarchical Vision Transformer using Shifted Windows [C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV).Montreal:IEEE,2021:9992-10002.

[10] OQUAB M,BOTTOU L,LAPTEV I,et al. Learning and Transferring Mid-level Image Representations Using Convolutional Neural Networks [C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:1717-1724.

[11] YAO Y,DORETTO G. Boosting for transfer learning with multiple sources [C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.San Francisco:IEEE,2010:1855-1862.

[12] LONG M S,ZHU H,WANG J M,et al. Deep transfer learning with joint adaptation networks [C]//Proceedings of the 34th International Conference on Machine Learning. Sydney:JMLR.org,2016,70:2208-2217.

[13] GANIN Y,LEMPITSKY V. Unsupervised domain adaptation by backpropagation [C]//Proceedings of the 32nd International Conference on International Conference on Machine Learning.Lille:JMLR.org,2015,37:1180-1189.

作者简介:邬云熙(1999—),男,汉族,山东临沂人,硕士在读,研究方向:人工智能;杨尧(2001—),男,汉族,湖北潜江人,本科在读,研究方向:人工智能;刘承前(2002—)男,汉族,山东枣庄人,本科在读,研究方向:人工智能;通讯作者:杨伏洲(1984—),男,汉族,湖北荆州人,讲师,博士,研究方向:人工智能。