摘" 要:针对结肠息肉图像中病灶区域尺度多变,传统方法难以捕捉其内部复杂关系导致的分割精度不高的问题,文章提出一种特征交互融合分割网络FIFNet。在该网络中,利用金字塔式Transformer和ResNet18并行提取息肉图像的局部与全局特征并通过语义协调单元SH融合两者之间的语义信息;此外,设计了层间注意力聚合模块IA,自适应加权融合不同层级特征,从而突出息肉图像的形态和纹理信息;最后,反向残差注意力模块IRA充分挖掘息肉区域与边界的联系,提高了分割结果的准确性。在公共数据集Kvasir、CVC-ClinicDB、CVC-ColonDB、ETIS、Endosece上进行实验测试,其中mDice系数分别为0.929、0.941、0.821、0.794、0.900。实验结果表明FIFNet网络在息肉图像分割上具有一定的应用价值。

关键词:结肠息肉分割;特征交互融合;语义协调单元;层间注意力;反向残差注意力

中图分类号:TP391.4" 文献标识码:A" 文章编号:2096-4706(2024)24-0031-05

Research on Colon Polyp Image Segmentation Algorithm Based on Feature Interactive Fusion

LU Peng

(School of Computer Science and Engineering, Anhui University of Science and Technology, Huainan" 232001, China)

Abstract: A feature interactive fusion segmentation network called FIFNet is proposed in this paper to address the issue of low segmentation accuracy caused by the variable scale of the lesion area in colon polyp images and the difficulty of capturing its internal complex relationships of traditional methods. In the network, it utilizes Pyramid Vision Transformer (PVT) and ResNet18 to extract local and global features of polyp images in parallel, and fuses the semantic information between the two by the Semantic Harmonization (SH) unit. Then, it designs the Inter-layer Attention (IA) aggregation module to highlight the morphological and texture information of polyp images through adaptive weighted fusion of different layer features. Finally, the Inverse Residual Attention (IRA) module fully explores the connection between the polyp area and boundary to improve the accuracy of segmentation results. Experimental tests are conducted on the public datasets Kvasir, CVC-ClinicDB, CVC-ColonDB, ETIS and Endosece where the mDice coefficients are 0.929, 0.941, 0.821, 0.794, and 0.900, respectively. Experimental results show that the FIFNet network has a certain application value in polyp image segmentation.

Keywords: colon polyp segmentation; feature interactive fusion; Semantic Harmonization unit; Inter-layer Attention; Inverse Residual Attention

0" 引" 言

结直肠癌是世界三大高发癌症之一,早期发现并切除息肉能够极大地降低结直肠癌的发病率[1]。目前,使用深度学习相关技术分割息肉图像已成为研究热点内容之一。其中,基于卷积神经网络的方法中,Ronneberge等[2]提出的U-Net网络取得了代表性的成功,其采用跳跃连接实现了低级与高级语义信息的有效融合;Zhou等[3]提出的U-Net++采用密集连接缓解了高低级语义信息在连接时存在的语义差距。基于Transformer的方法中,Dong[4]等提出Polyp-PVT使用PVT作为主干网络,提取不同级别的息肉特征,提高了分割精度;Wang等[5]提出SSFormer,使用卷积算子等方法强调关键局部特征,限制模型注意力分散。

然而,仅仅以卷积神经网络为基础的U型结构不能很好地捕捉全局语义信息,难以对特征信息进行长期交互;单纯利用Transformer结构在图像的局部信息处理中因为缺乏空间归纳偏差,使其捕获细节能力受到限制。受上述工作的启发,提出一种融合卷积神经网络和Transformer的特征交互融合网络(Feature Interaction Fusion Network, FIFNet),首先使用PVT(Pyramid Vision Transformer)与ResNet18同时作为编码器并行提取息肉图像特征并且通过语义协调单元SH(Semantic Harmonization)对两分支提取的特征进行融合,缓解语义差距,其次设计了层间注意力聚合模块Inter-layer attention aggregation, IA),有效整合跨级别特征之间的内部联系,最后引入反向残差注意力模块(Inverse Residual Attention, IRA),构建息肉区域与边界的关系,解决边界模糊的问题。

1" 方法介绍

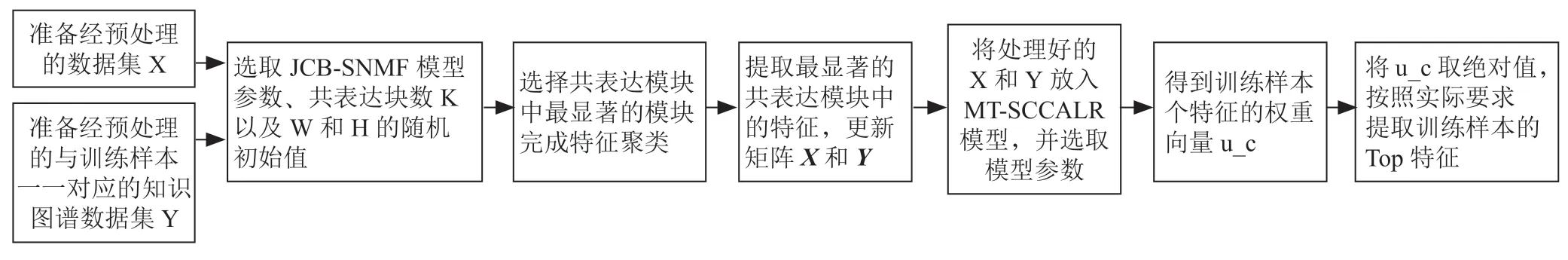

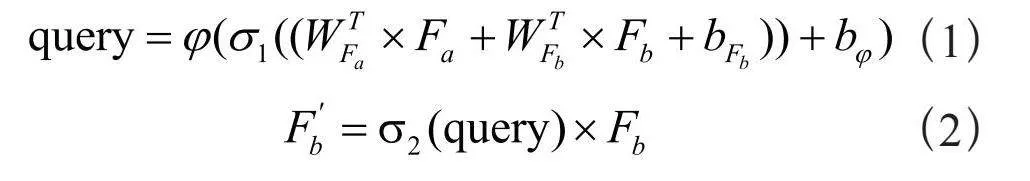

FIFNet结构如图1所示,首先,由PVT与ResNet18对输入图像进行四次下采样得到四组编码特征,这些特征成对进入语义协调单元SH,旨在实现编码特征的有效融合,缓解语义差距;其次,将处理好的特征输入到层间注意力聚合IA模块,IA模块由多个层间注意力单元构成,融合不同层级特征,从而突出息肉图像的形态和纹理信息;最后,IA输出的特征输入到反向残差注意力模块IRA,进行取反和点积运算来获得反向注意力特征的输出,从而顺序地融合和细化互补区域和细节。FIFNet使用双分支编码器,特征之间进行迭代交互,能够有效捕捉息肉图像的内部复杂关系,校正预测结果中如边界等矛盾冲突的区域从而提高分割精度。

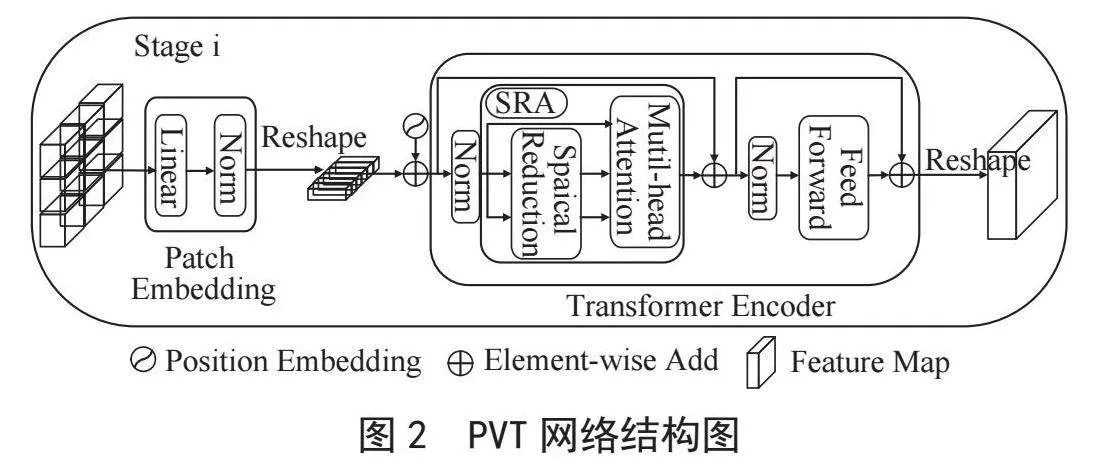

1.1" PVT与ResNet18分支

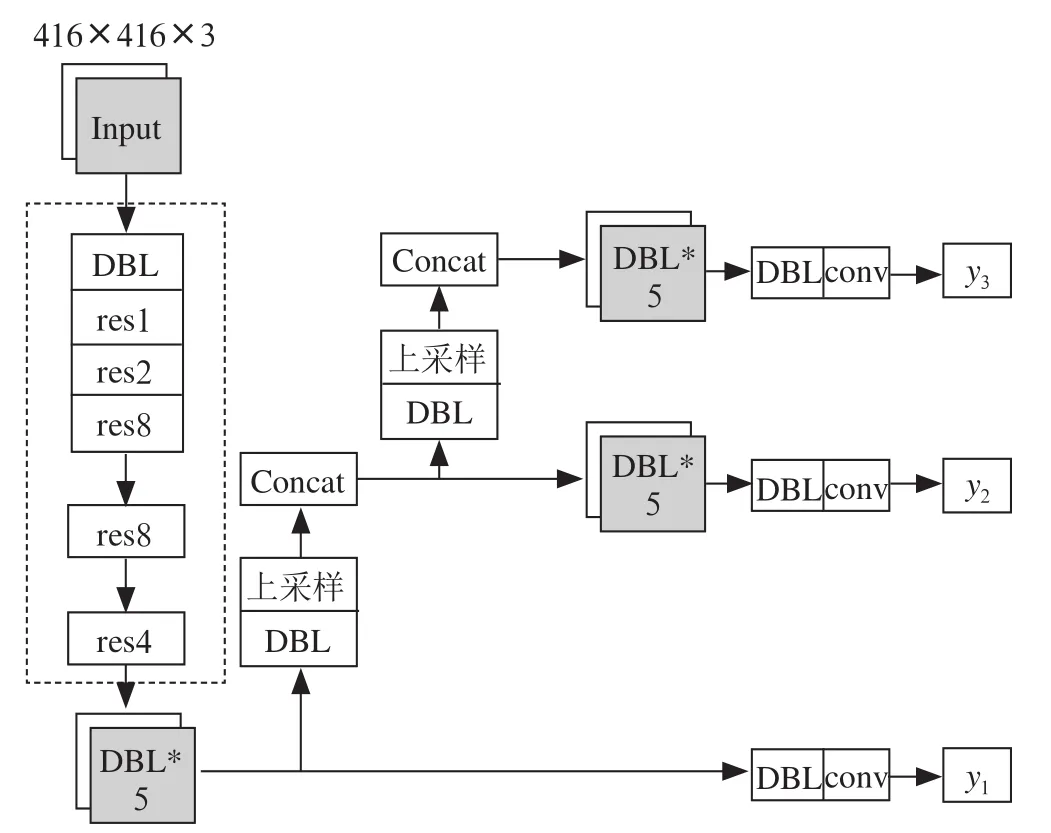

Transformer通过其自注意力机制计算特征图中任意两个位置之间的关系来直接捕获远程依赖,实现对特征图的全局建模,能够提供丰富的上下文信息,由此引入PVT作为网络的编码器之一。PVT每一个阶段结构如图2所示。初始阶段,输入图像将被分为4×4的图像块送入模型,随后将展平的图像块进入全连接层并获取通道维度上的嵌入特征块,然后特征嵌入块和位置嵌入一同送入L1层的Transformer编码器中,经过多头自注意力机制(Spatial Reduction Attention, SRA)和一个前向传播,输出特征图FP1,其尺寸为原来的四分之一。通过相同的处理,在前一阶段得到的特征图被送入后续阶段,得到四个阶段且尺寸比为2的特征图,最终形成四个层级特征的特征金字塔FP1、FP2、FP3、FP4。

残差神经网络ResNet18通过其深度残差连接的特性以及卷积神经网络特有的归纳偏置可以有效地提取息肉像的局部特征,结合PVT编码器,二者相辅相成,可以充分提取息肉图像的局部特征和全局特征。由图1可知,ResNet18同样输出4个阶段的不同尺度特征FR1、FR2、FR3、FR4与PVT输出特征一一对应。

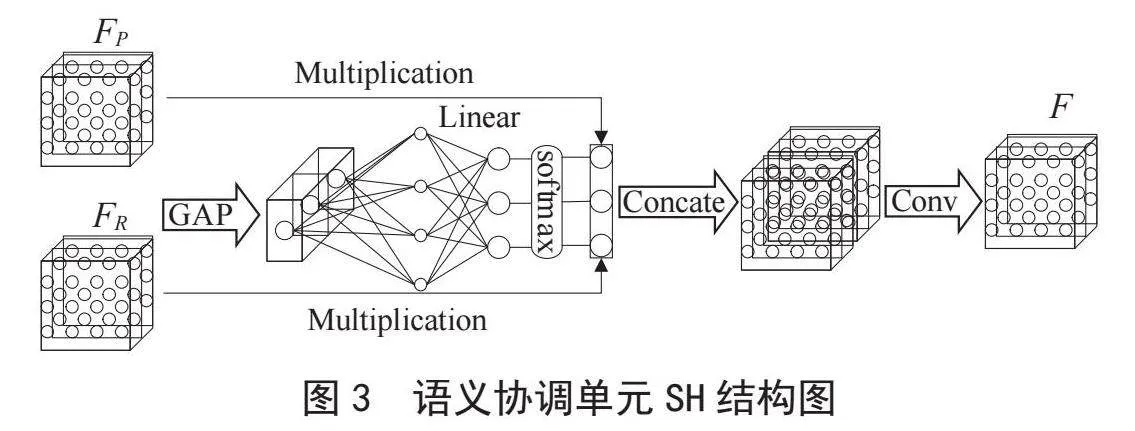

1.2" 语义协调单元SH

为了使两编码器提取的特征能够有效融合,设计了语义协调单元SH。该协调单元通过学习权重和特征映射的调整使得ResNet18和PVT之间的特征表达更为一致和有效。SH结构如图3所示。首先,SH单元接收两编码器提取的四组特征FP与FR,对其进行全局平均池化(Global Average Pooling, GAPool)获得两个特征的全局上下文信息;其次,通过全连接层Linear与Softmax激活函数得到注意力权重参数,进而对原始特征图进行加权,最后,加权后的两个特征在通道维度上进行拼接,经过1×1的卷积调整为原始通道数,得到具有一致语义信息的特征。

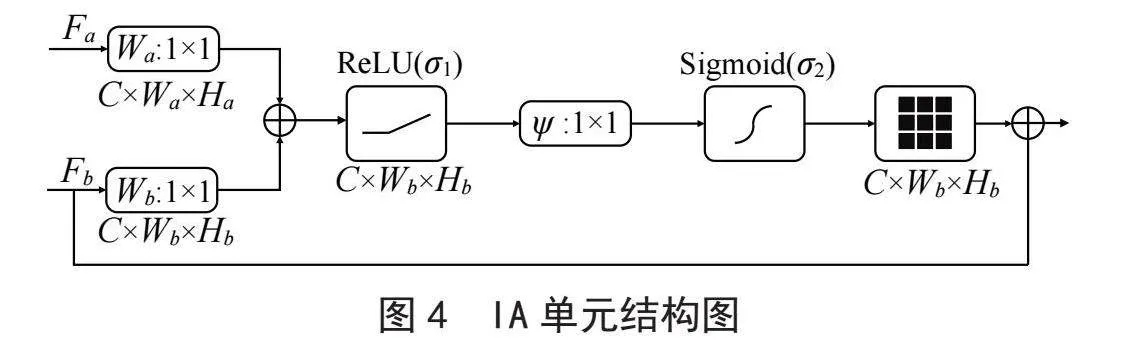

1.3" 层间注意力聚合模块IA

层间注意力聚合模块IA,主要由多个门控注意力(Attention Gate, AG)[6]交互构成。此模块接收SH输出的四个特征,自底向上使相邻级别特征之间进行信息交互,实现信息的跨层传递,结合局部和全局信息,使得模型能够同时关注息肉的局部细节和周围的全局上下文,有助于提高分割结果的一致性和完整性。IA单元结构如图4所示。

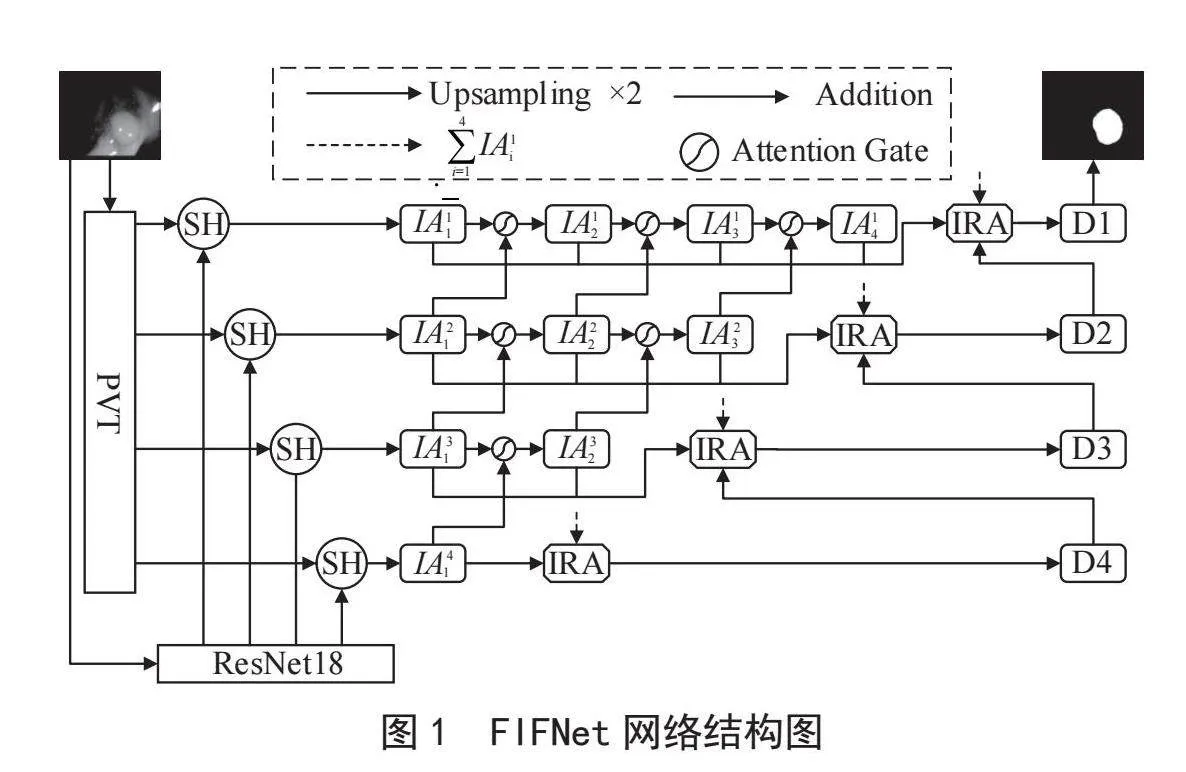

IA单元具体过程为:该模块接收相邻级别的特征输入,首先,通过1×1卷积之后进行逐元素相加,经过ReLU函数引入非线性提高网络泛化能力;其次,使用1×1卷积调整通道数;最后,使用Softmax函数获得注意力权重与原始特征图进行点积操作获得加权后的特征图并输出。定义一个基本层间注意力单元IA,公式计算如式(1)与(2)所示:

(1)

(2)

其中,W表示1×1卷积的卷积核权重参数,σ1表示ReLU激活函数,φ表示1×1卷积,b表示归纳偏执,σ2表示Softmax函数,query表示注意力权重。

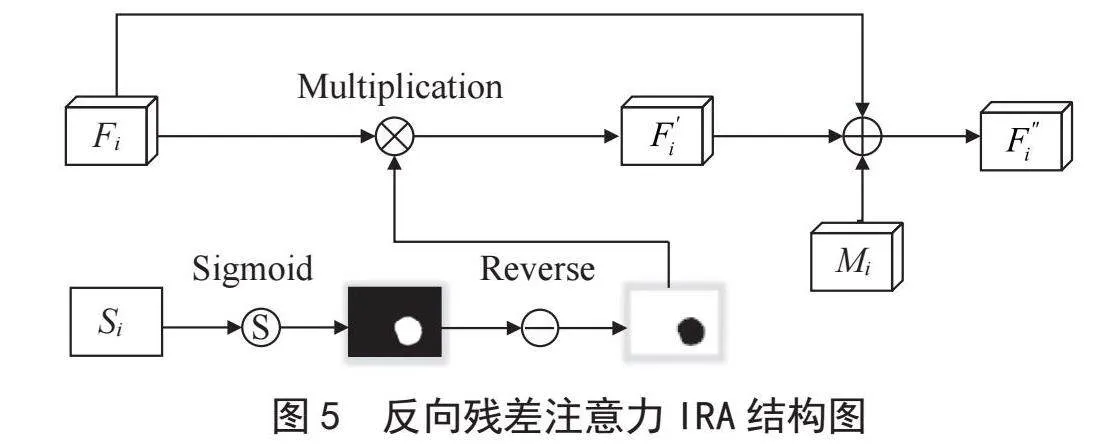

1.4" 反向残差注意力模块IRA

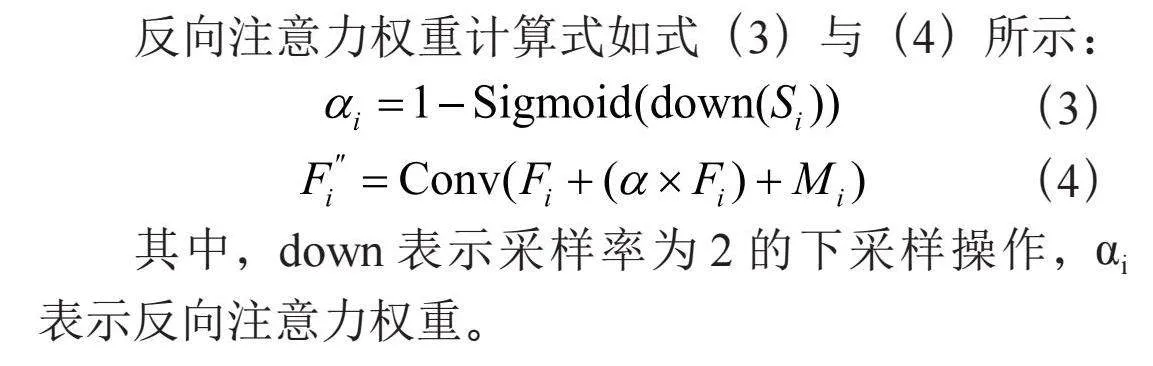

结肠息肉图像病灶区域与周围组织具有高度一致性,容易导致边缘分割效果不理想。为了挖掘息肉边缘信息,实现更高的分割精度,在网络中构建了反向残差注意力模块IRA。图5为IRA的实现过程,在该模块中接收三个输入,其中Fi由解码层上采样得到,Si由第一层四个IA单元的输出相加并进行下采样得到,Mi由每一层IA的输出相加得到。IRA具体过程为:先对引导图Si进行Sigmoid和Reverse取反操作获得边界注意力权重,再以此对Fi进行加权得到具有准确边界信息的特征图,随后引入原始Fi、Mi与相加构成残差结构,加快网络的收敛速度和防止梯度消失的问题,最后通过3×3卷积输出。

反向注意力权重计算式如式(3)与(4)所示:

(3)

(4)

其中,down表示采样率为2的下采样操作,αi表示反向注意力权重。

1.5" 损失函数

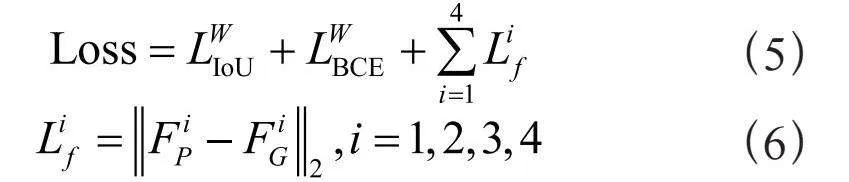

在网络中所使用的损失函数可以定义为式(5)与(6)所示:

(5)

(6)

其中,与是在分类任务中广泛使用的两种损失函数,分别为加权IoU损失和二元交叉熵损失。受M2SNet[7]的启发,引入了多层特征差异损失,其使用在ImageNet预训练分类网络VGG-16分别提取预测值和真实值的多尺度特征,并计算他们之间的欧几里得距离,从而实现像素级别的精确监督。

2" 实验设置与结果分析

2.1" 实验环境及模型超参数

实验环境基于Python 3.8,PyTorch 1.9.0,Cuda1 1.6,使用NVIDIA 2080TI 12 GB显卡对网络模型进行训练。使用随机梯度下降(Stochastic Gradient Descent, SGD)作为模型的优化器,在进行100轮epoch的训练过程中,设定批次大小为16,初始学习率为0.02,衰减率为0.000 5。

2.2" 实验数据集

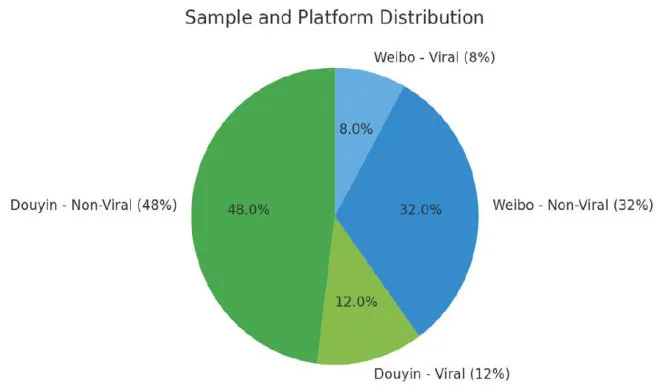

在5个息肉数据集上进行了实验,分别为CVC-ClinicDB[8]、Kvasir[9]、CVC-ColonDB[10]、ETIS[11]和Endosece[12],其中,选取CVC-ClinicDB中的550张结肠息肉图像和Kvasir中的900张结肠息肉图像作为训练集。测试集则是由CVC-ColonDB中的380张图像、CVC-ClinicDB中的62张图像、Kvasir中的100张图像、ETIS中的196张图像和Endosece中的60张图像构成。由于CVC-ColonDB、ETIS和Endosece三个数据集并未参与训练,因此使用这三个数据集来评估模型的泛化能力。

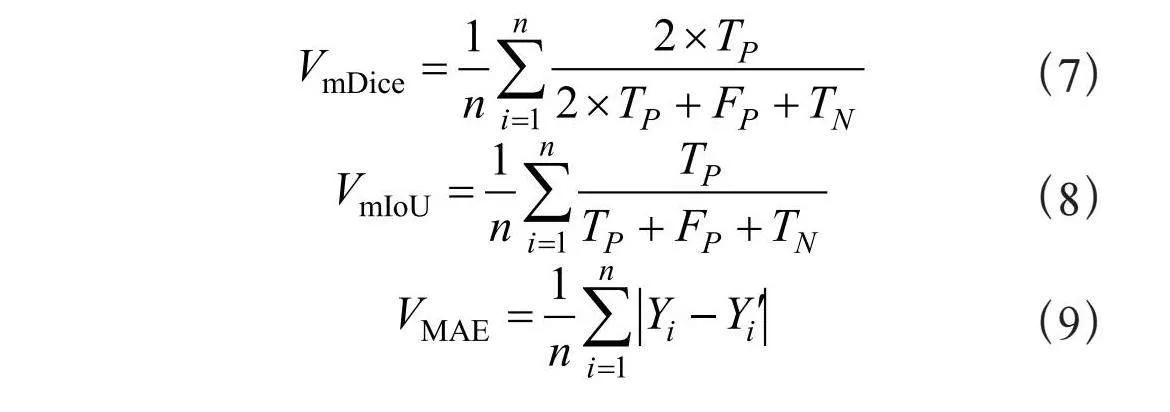

2.3" 评价指标

在此实验中,使用三个评估指标来度量分割性能,分别为平均交并比(mIoU)、平均相似系数(mDice)和平均绝对误差(MAE)。其中,mDice和mIoU为图形相似度度量函数,是图像分割领域常用的评价指标。MAE可以计算预测结果和真实结果之间的像素差异。这些指标的计算公式如式(7)(8)(9)所示:

(7)

(8)

(9)

其中,TP和TN分别表示正确分类为前景和背景像素的样本数,FP和FN分别表示错误分类为前景和背景像素的样本数,Yi表示原始样本的标签值,而表示模型的输出结果。

2.4" 实验结果与分析

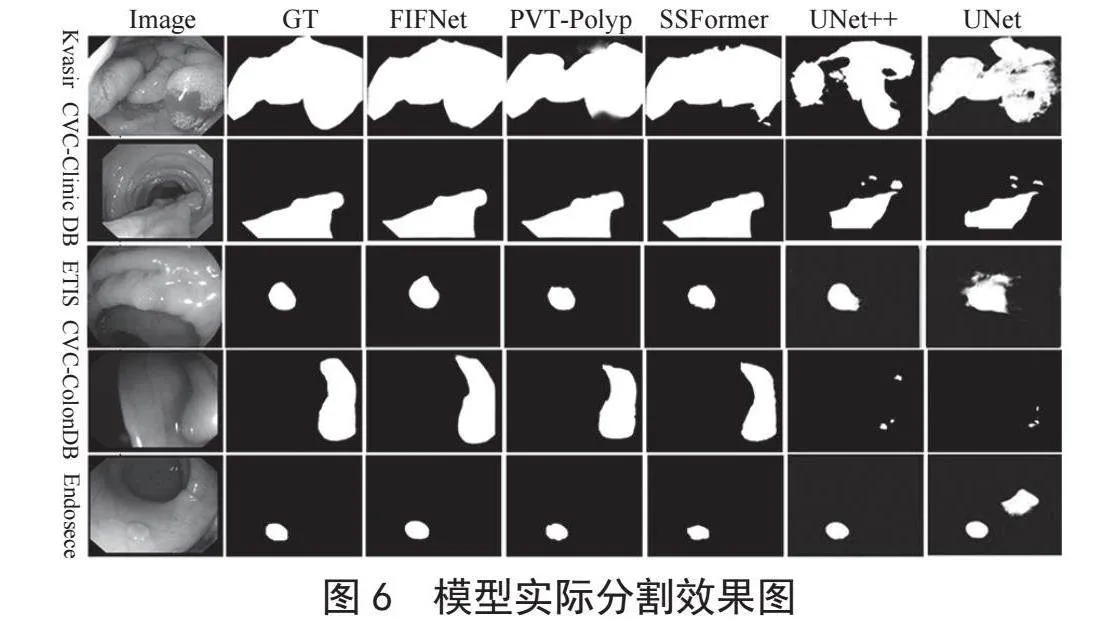

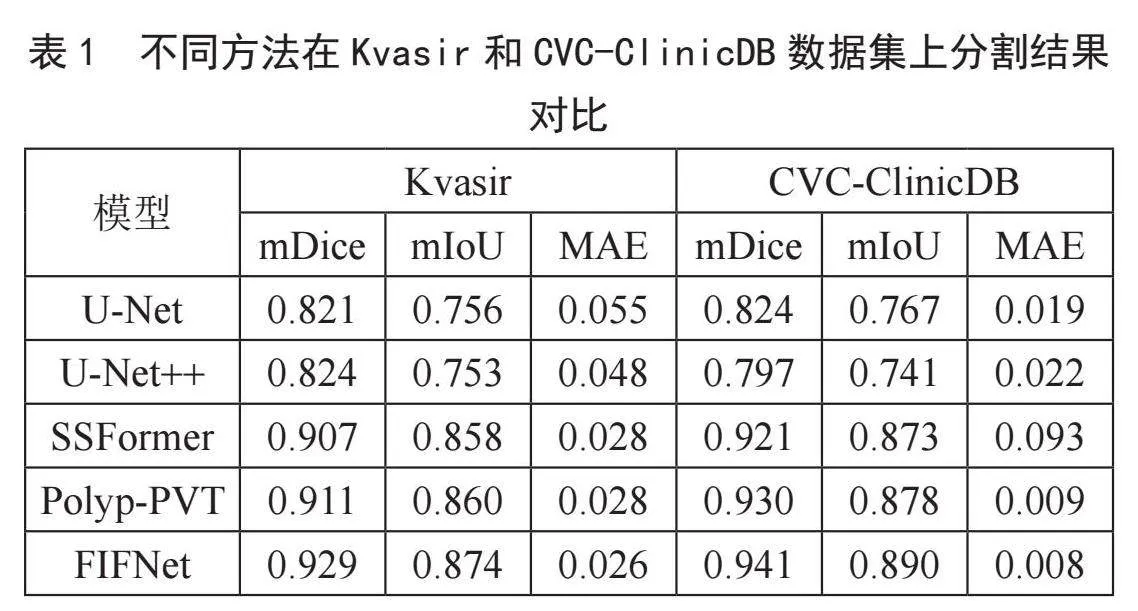

2.4.1" 分割效果对比

为了验证FIFNet网络模型的分割性能,分别与U-Net、U-Net++、SSFormer和Polyp-PVT等网络在CVC-ClinicDB和Kvasir息肉图像数据集上进行了测试对比,各网络模型的分割结果如表1所示,FIFNet的数据皆为最优值。从表中数据可以看出,FIFNet在两个数据集上都实现了较好的分割效果。在Kvasir数据集中mDice为0.929,mIoU为0.874,MAE为0.026,相比Polyp-PVT,其mDice、mIoU和MAE分别提升2.0%、1.6%和7.1%。在CVC-ClinicDB数据集中mDice为0.941,mIoU为0.890,MAE为0.008,相比Polyp-PVT,其mDice、mIoU和MAE分别提升1.2%、1.3%和11.1%。

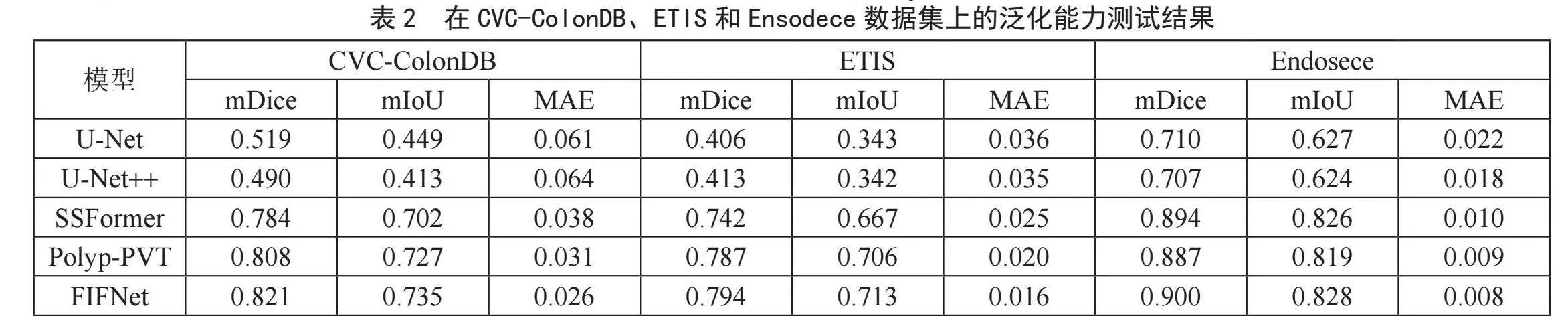

2.4.2" 泛化能力效果对比

为了验证FIFNet网络的泛化能力,在CVC-ColonDB、ETIS和Endosece数据集上进行了泛化能力的测试,结果如表2所示,FIFNet的数据均为最优值。从表中数据可以看出FIFNet在3个测试的数据集上的表现较其他4种方法来说,较为优秀。尤其在CVC-ColonDB数据集上mDice达到0.821,mIoU达到0.735,MAE达到0.026,相较Polyp-PVT模型,mDice提高1.6%,mIoU提高1.1%,MAE提高16.1%。

图6展示了各网络模型的实际分割效果图,从图中可以看出FIFNet的实际分割效果更接近真实标签图。综合对模型的分割效果与泛化能力的测试结果来看,FIFNet模型相较其他模型具有更出色的能力。

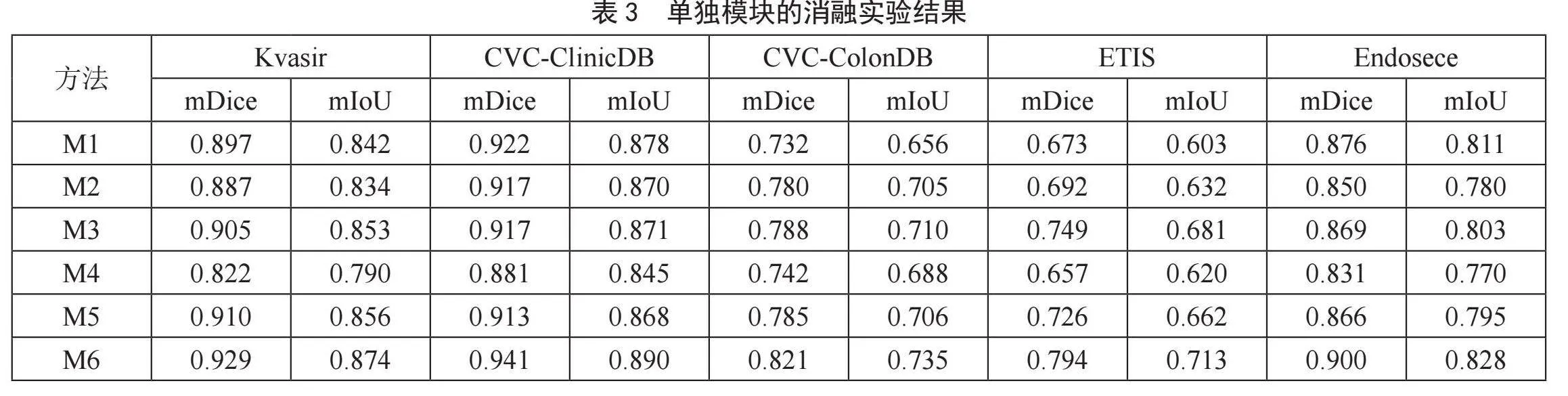

2.5" 消融实验

为了验证在FIFNet中各模块的有效性与必要性,在5个数据集上进行了单独模块的消融实验,评价指标选取mDice和mIoU。表3列出了所提出模型在5个数据集上做的单独模块的消融实验结果,加粗数据代表最优值。其中M1代表去除PVT主干,M2代表去除ResNet18主干,M3代表去除语义协调单元模块SH,M4代表去除层间注意力聚合模块IA,M5代表去除反向残差注意力模块IRA,M6代表FIFNet。

从表中数据来看,当去除单独某个模块后,模型在五个数据集上的分割精度均有所下降。具体来说,当去除PVT主干以后,特别是在ETIS数据集上,mDice、mIoU分别下降17.0%和15.4%;当去除ResNet18主干以后,同样在ETIS数据集上精度下降尤为明显,mDice、mIoU分别下降17.0%和15.4%;当去除SH模块以后,以直接在通道维度拼接代替SH,在Endosece数据集上mDice、mIoU分别下降3.4%和3.1%;当去除IA模块以后,在5个数据集上都出现了精度急剧下降的现象;当去除IRA模块以后,在CVC-ColonDB数据集上,mDice、mIoU分别下降4.4%和3.9%。

3" 结" 论

文章提出一种特征交互融合的分割网络FIFNet用来改善因息肉图像中病灶区域尺度变化大、传统方法难以捕捉其内部复杂关系导致的分割精度不高的问题。首先,由PVT和ResNet18对息肉特征进行多尺度特征提取,经过语义协调单元缓解主干网络之间的语义差距,充分融合二者之间的语义信息;其次,融合后的特征输入到层间注意力模块,使模型自适应地对息肉区域进行加权,突出息肉关键特征,去除冗余信息;最后,通过反向残差注意力模块,挖掘息肉边界信息,引导网络更好地分割。在5个公开的数据集上取得了相较其他4个模型更优异的结果,表明该方法在息肉图像分割上具有一定的应用价值。

参考文献:

[1] 撖子奇,刘巧红,凌晨,等.结合HarDNet和反向注意力的息肉分割方法 [J].激光与光电子学进展,2023,60(2):300-307.

[2] RONNEBERGER O,FISCHER P,BROX T. U-Net: Convolutional Networks for Biomedical Image Segmentation [C]//Medical Image Computing and Computer-assisted Intervention-MICCAI 2015.Munich:Springer,2015:234-241.

[3] ZHOU Z W,SIDDIQUEE M M R,TAJBAKHSH N,et al. UNet++: A Nested U-Net Architecture for Medical Image Segmentation [C]//Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support.Heidelberg:Springer,2018:3-11.

[4] DONG B,WANG W H,FAN D-P,et al. Polyp-PVT: Polyp Segmentation with Pyramid Vision Transformers [J/OL].arXiv:2108.06932 [eess.IV].(2021-08-16).https://arxiv.org/abs/2108.06932?context=eess.

[5] WANG J F,HUANG Q M,TANG F L,et al. Stepwise Feature Fusion: Local Guides Global [J/OL].arXiv:2203.03635 [eess.IV].(2022-03-07).https://arxiv.org/abs/2203.03635?context=cs.CV.

[6] DAS N,DAS S. Attention-UNet Architectures with Pretrained Backbones for Multi-class Cardiac MR Image Segmentation [J].Current Problems in Cardiology,2024,49(1):102129.

[7] ZHAO X Q,ZHANG L H,LU H C. Automatic Polyp Segmentation Via Multi-scale Subtraction Network [C]//Medical Image Computing and Computer Assisted Intervention-MICCAI 2021.Strasbourg:Springer,2021:120-130.

[8] 杨颖,韩金仓,张杨洁.基于UT-Former的结直肠息肉分割模型 [J].现代信息科技,2022,6(22):78-80+85.

[9] ZHANG Y D,LIU H Y,HU Q. TransFuse: Fusing Transformers and CNNs for Medical Image Segmentation [C]//Medical Image Computing and Computer-assisted Intervention.Strasbourg:Springer,2021,1(24):14-24.

[10] LOU A G,GUAN S Y,KO H. CaraNet: Context Axial Reverse Attention Network for Segmentation of Small Medical Objects [J/OL].arXiv:2108.07368 [eess.IV].(2021-08-16).https://arxiv.org/abs/2108.07368?context=cs.CV.

[11] SILVA J,HISTACE A,ROMAIN O,et al. Toward Embedded Detection of Polyps in WCE Images for Early Diagnosis of Colorectal Cancer [J].International Journal of Computer Assisted Radiology and Surgery,2014,9(2):283-293.

[12] SANDERSON E,MATUSZEWSKI B J. FCN-Transformer Feature Fusion for Polyp Segmentation [C]//Medical Image Understanding and Analysis.Cham:Springer,2022:892-907.

作者简介:陆鹏(1999—),男,汉族,安徽亳州人,硕士在读,研究方向:图像分割。