摘" 要:针对目前多数基于孪生网络的单目标跟踪算法模型参数大,难以在嵌入式平台等移动端设备部署的问题,设计了一种基于SiamRPN改进的轻量化孪生网络单目标跟踪算法。算法使用裁剪过的MobileNetV3替换AlexNet作为特征提取网络,降低算法的参数量;融合了MobileNetV3的高低层特征,整合不同尺度的特征信息,增强算法对目标多尺度变化的适应能力;使用GhostConv替换原网络模型头部的普通卷积,使用深度可分离卷积进行相关运算,在保证特征提取能力的同时进一步减少了参数量。在OTB数据集上进行测试的结果表明:改进后的算法在准确率上提高了1.6%,成功率提高了3.8%,模型参数量为2.9 MB,减少了98.3%,证明改进后的目标跟踪算法模型具有显著的性能优势。

关键词:SiamRPN;单目标跟踪;轻量化网络;特征融合

中图分类号:TP301.6;TP183 文献标识码:A 文章编号:2096-4706(2025)03-0084-06

Research on Lightweight Single Object Tracking Algorithm Based on Siamese Network

LI Qinghua, ZHANG Xueqiu, ZHANG Yushan

(College of Mechanical Engineering, Chongqing University of Technology, Chongqing, 400054,China)

Abstract: Aiming at the problem that most of the Single Object Tracking algorithms based on Siamese Network have large model parameters and are difficult to deploy on mobile devices such as embedded platforms, a Single Object Tracking algorithm of improved lightweight Siamese Network based on SiamRPN is designed. The algorithm uses the clipped MobileNetV3 to replace AlexNet as the feature extraction network to reduce the number of parameters of the algorithm. It integrates the high-level and low-level features of MobileNetV3, integrates the feature information of different scales, and enhances the adaptability of the algorithm to the multi-scale changes of the object. GhostConv is used to replace the ordinary convolution of the head of the original network model, and the Depthwise Separable Convolution is used with for correlation operation, which further reduces the number of parameters while ensuring the feature extraction ability. The test results on the OTB dataset show that the improved algorithm improves the accuracy by 1.6%, and the success rate by 3.8 %. The number of model parameters is 2.9 MB, which is reduced by 98.3 %. It is proved that the improved object tracking algorithm model has significant performance advantages.

Keywords: SiamRPN; Single Object Tracking; lightweight network; feature fusion

0" 引" 言

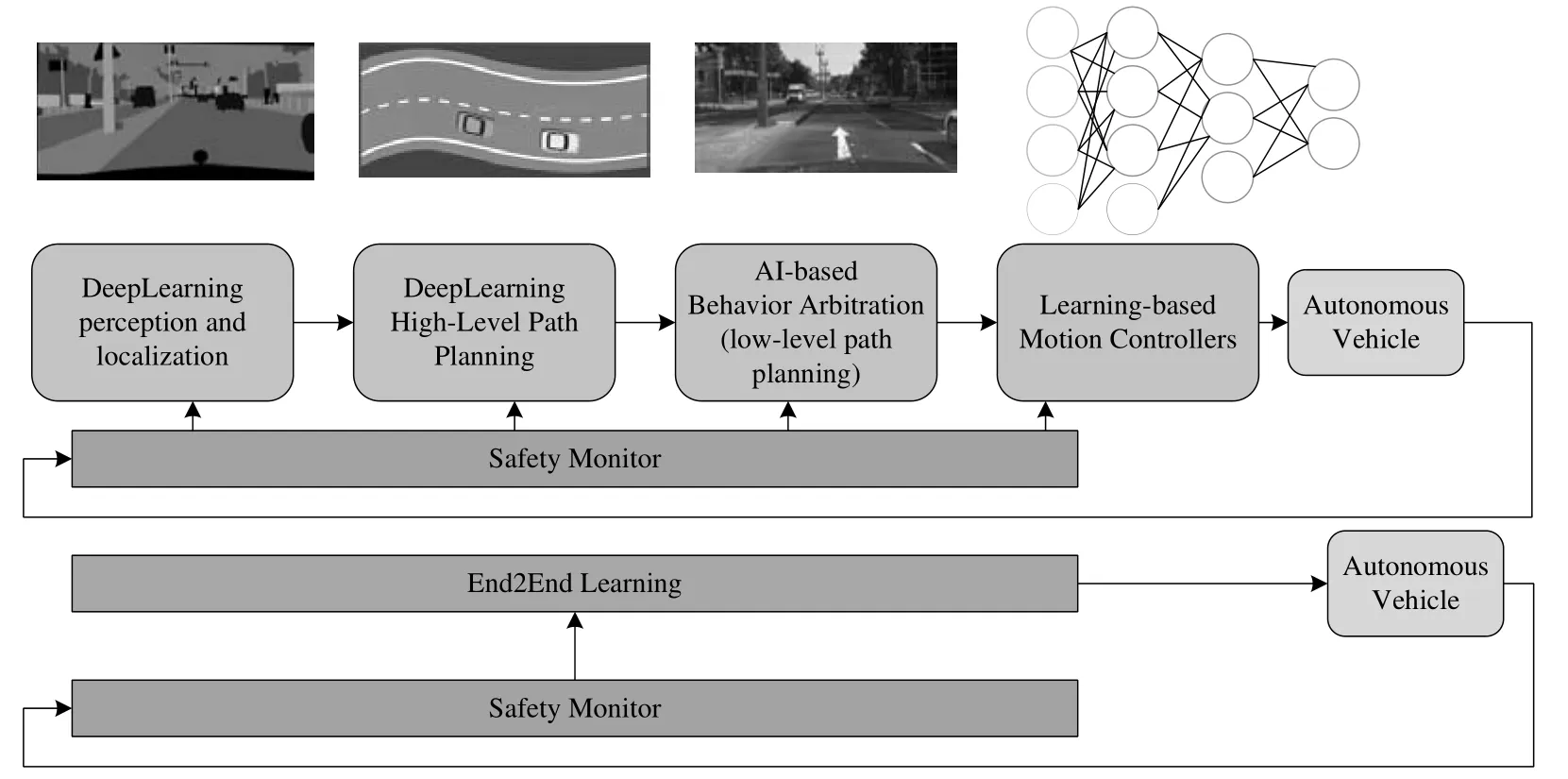

目标跟踪源于计算机视觉,以图像、视频数据为基础,融合了图像处理、模式识别、人工智能、自动控制等多个领域。近年来,人工智能快速发展,计算机视觉研究也屡获突破,目标跟踪的相关研究也进展显著,并广泛应用于安防监控、智能交通、人机交互、自动驾驶以及军事侦察等诸多领域[1-2]。

单目标跟踪的任务是给定第一帧用边界框标记的感兴趣目标后,在视频的后续帧中自动给出目标的位置和形状[3]。2010年以前,目标跟踪算法主要构建于生成式模型之上,如卡尔曼滤波、MeanShift算法等。2010年开始,基于相关滤波的目标跟踪算法快速发展,出现了KCF、MOSSE等算法,传统相关滤波的检测速度快,但是不会显示保存训练样本,非最近几帧样本信息逐渐失效,会导致目标定位误差增大[4],随后的相关滤波研究加入深度学习特征提取网络,虽然精度提升了,但是检测速度也大幅下降了。随着时间推移,2016年以后,得益于计算机算力的显著提高以及大规模深度学习数据集的涌现,基于孪生网络的目标跟踪算法开始备受关注。SiamFC使用全卷积孪生网络进行相似性学习,来解决跟踪任意对象的问题,实现了精度和速度间的平衡,在单目标跟踪领域取得较好成绩[5]。SiamRPN引入了区域建议网络,通过预设锚框来解决目标尺度变化的问题,得到了更加精准的跟踪框[6]。最近,基于Transformer的目标跟踪算法在检测精度上有了很大的提升,如SwinTrack和SeqTrack等算法。但它们的模型较大且计算复杂,SwinTrack的参数量和浮点运算量分别为22.7M和6.4GFLOPs。而SeqTrack-B256的参数量和浮点运算量则高达89M和66GFLOPs。这使得这些算法不适合在嵌入式平台或移动设备上部署[7]。

随着基于孪生网络的目标跟踪算法的不断发展,这些算法在鲁棒性和准确性方面表现出了显著的优势。然而,现有的单目标跟踪算法通常存在模型参数庞大、计算复杂度高的问题,这使得它们在嵌入式平台和移动设备上的应用受到限制。为了解决这一挑战,提出了一种轻量化且高效的单目标跟踪算法,旨在提升在资源受限环境下的应用性能。算法基于SiamRPN目标跟踪算法,选用高效的MobileNetV3[8]作为特征提取网络,以降低计算和参数负担,同时保持良好的性能。此外,通过融合MobileNetV3的高低层特征,增强算法对目标多尺度变化的适应能力。为了进一步优化算法效率,将检测头部的普通卷积替换为GhostNet[9]中的GhostConv,并采用深度可分离卷积来减少冗余计算。

1" 算法结构设计

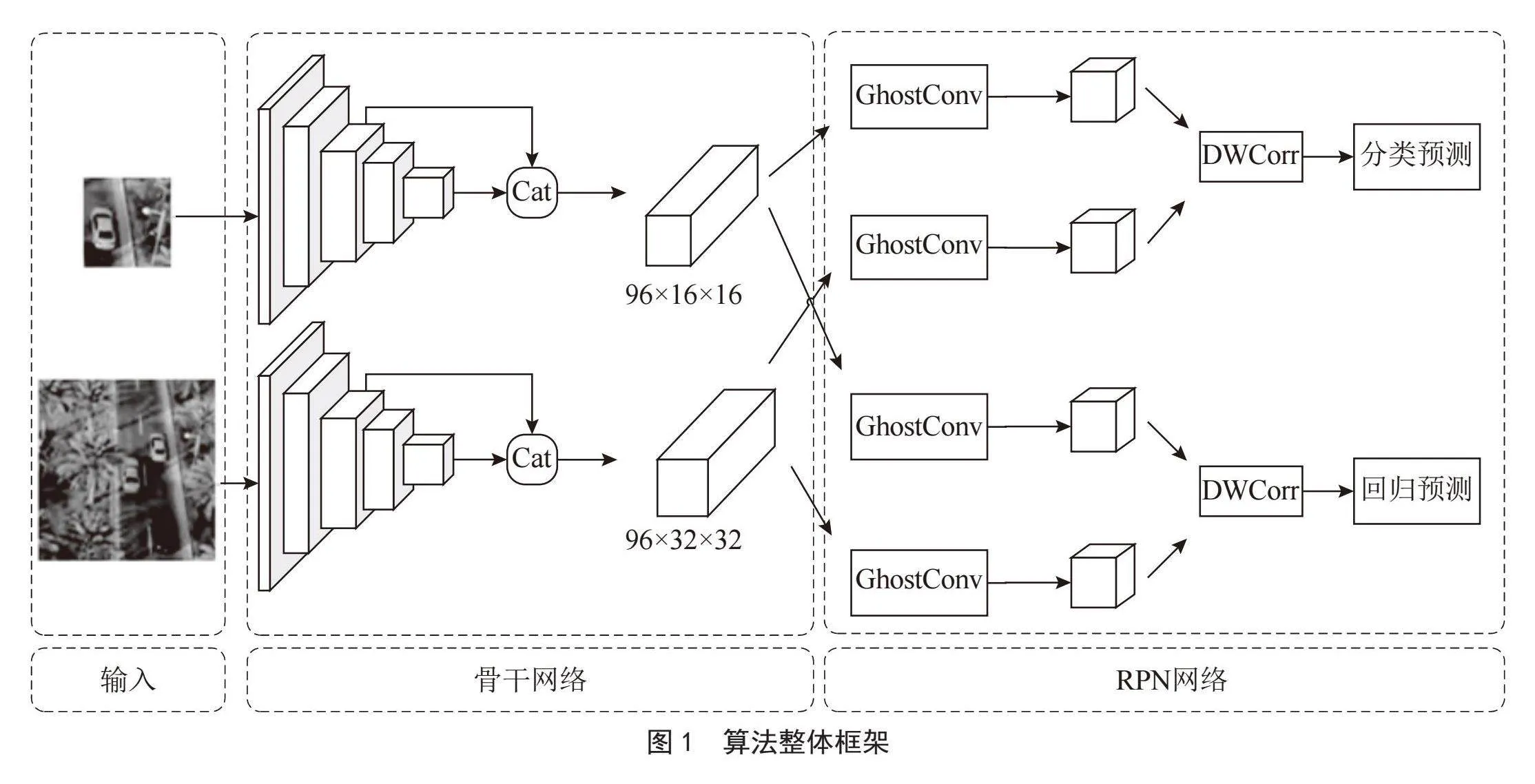

1.1" 算法整体架构

基于孪生网络的轻量化单目标跟踪算法结构如图1所示。为实现这一算法,以SiamRPN为基准框架做了3点设计与研究:一是修改特征提取骨干网络AlexNet为裁剪过的MobileNetV3;二是拼接融合MobileNetV3的深层特征和浅层特征;三是将头部RPN网络的普通卷积改为GhostConv模块,并且将相关运算的普通卷积修改成了深度可分离卷积。

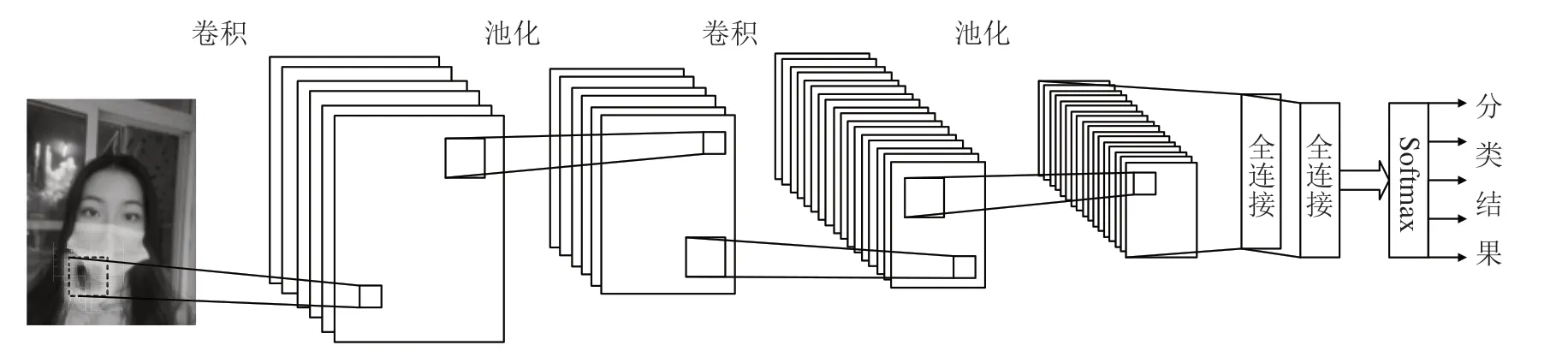

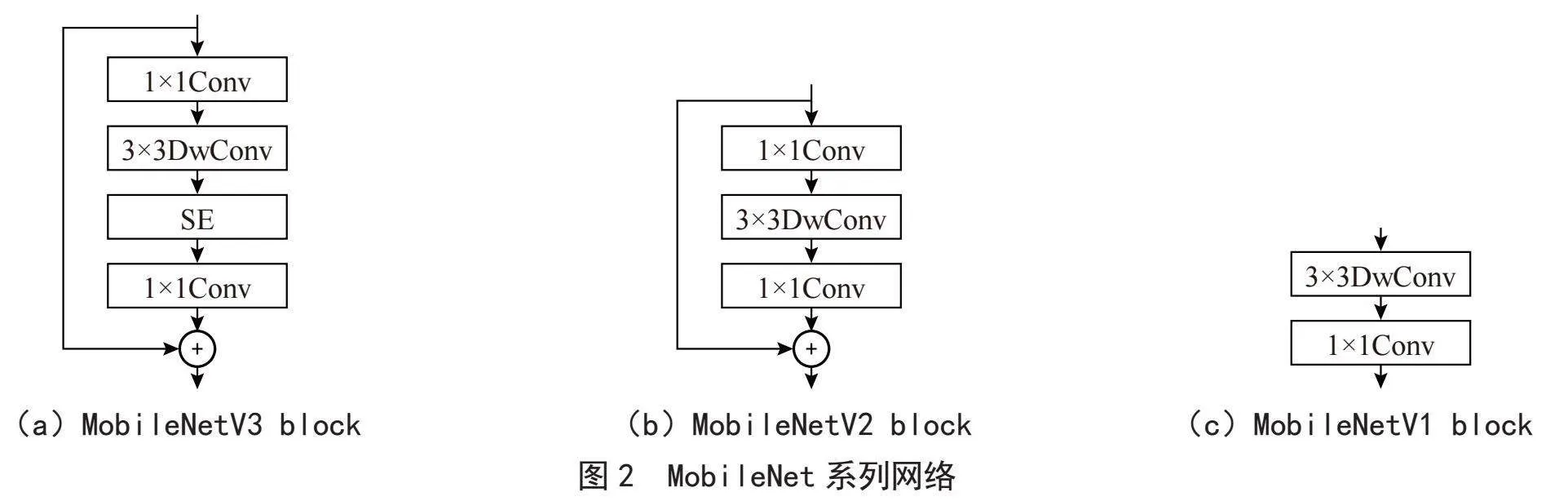

1.2" 特征提取网络

在特征提取网络部分,摒弃了原始SiamRPN中使用的AlexNet,转而采用轻量化的MobileNetV3网络,其模块结构如图2(a)所示。如图2(c)所示,MobileNet系列首先由MobileNetV1引入了深度可分离卷积,将标准卷积操作拆分为深度卷积和逐点卷积两个步骤,深度卷积负责对每个通道单独进行特征提取,逐点卷积则用来融合通道间信息,如此一来,在大幅减少计算量的同时,还能保证模型的特征提取能力,而MobileNetV2在此基础上增加了残差结构,如图2(b)所示,当网络堆叠层数增多时,能够有效缓解梯度消失问题,让模型训练更加顺畅,同时允许网络学习到更复杂的特征。随后,MobileNetV3在MobileNetV2的基础上引入了SENet(Squeeze-and-Excitation Networks)通道注意力机制,让模型可以更加关注信息量最大的通道特征,而抑制不重要的通道特征。得益于深度可分离卷积等先进设计,MobileNetV3能够以较少的参数和较低的计算量,高效地从输入图像中提取出具有代表性的特征,为后续的目标跟踪流程奠定了坚实的基础。

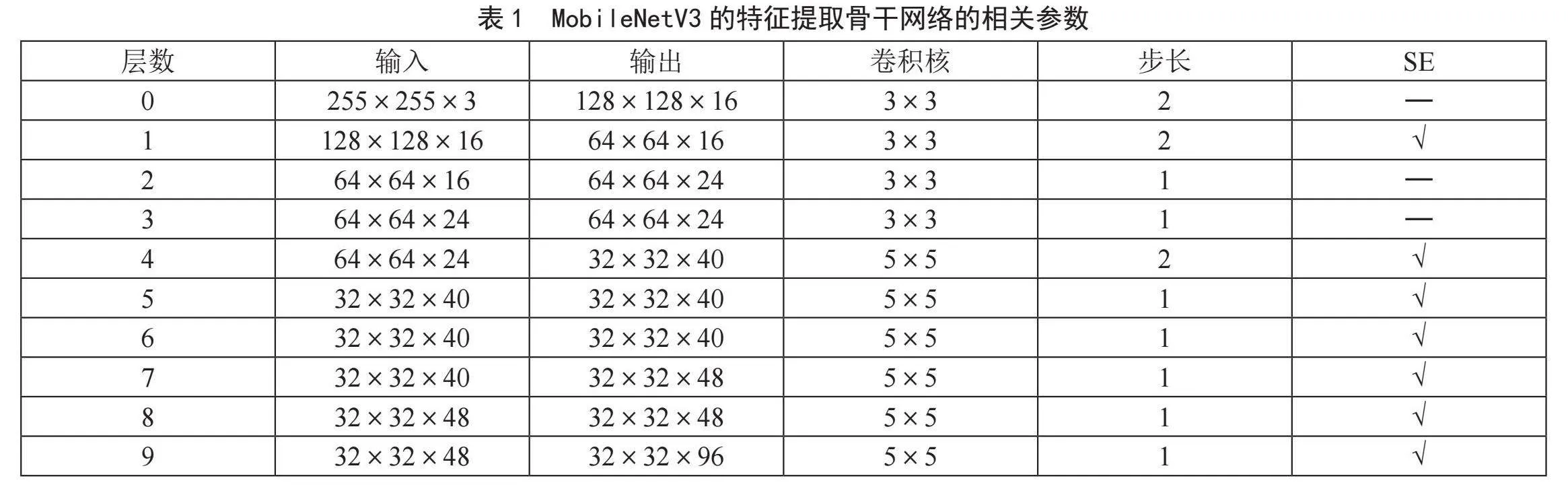

为了将MobileNetV3嵌入到孪生网络的特征提取部分,并实现轻量化的特征提取网络,对其堆叠的网络结构进行了部分调整。去掉了网络最后用于分类的部分,并且其特征提取部分仅选用前10层,修改了部分层的卷积步长,具体的相关参数如表1所示,以输入图像特征为255×255×3为例,最后通过卷积的输出图像特征为32×32×96。

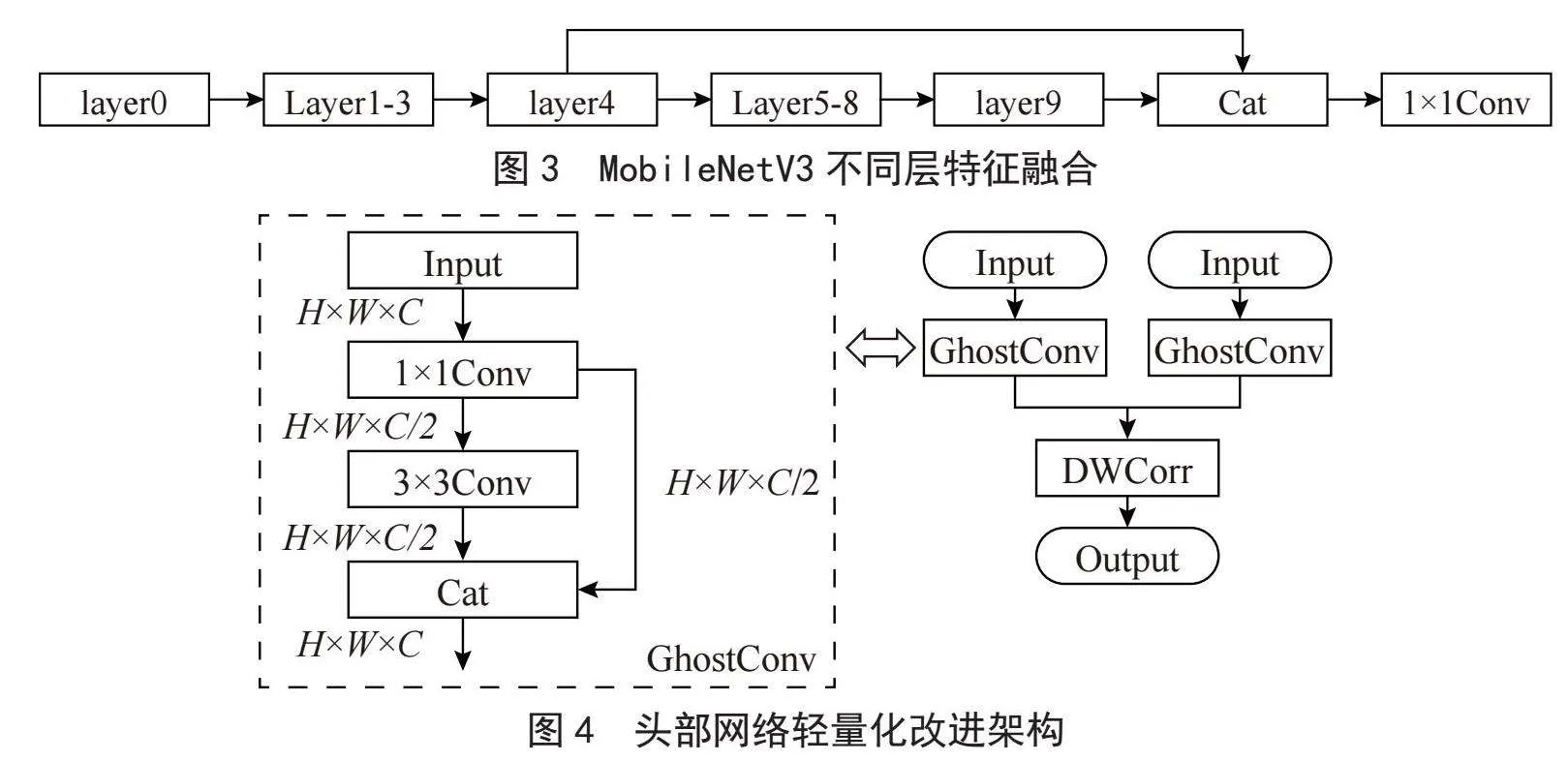

1.3" 特征融合处理

由于MobileNetV3高低层特征所蕴含的不同尺度信息,因此,在采用MobileNetV3作为特征提取网络的基础上,设计了高低网络层特征融合机制,将高层语义丰富但分辨率较低的特征与低层分辨率高但语义相对较弱的特征进行拼接融合,使得融合后的特征既能捕捉到目标的细节信息,又具备较强的语义理解能力,从而更好地应对目标在跟踪过程中出现的多尺度变化情况。

在实际的处理流程中,采用了一种通道拼接的融合策略,具体方案如图3所示。在上一小节改进的MobileNetV3网络基础上,选取其第4层的输出特征图,并提取出该网络最后一层的输出特征图。随后,将这两个来源于不同层级的特征输出,按照通道维度进行拼接融合操作。完成拼接后,考虑到后续计算成本、模型复杂度以及特征表达的精准度需求,进一步运用1×1的卷积核来对融合后的高维输出进行降维处理,将输出通道数量从136降低至96,在保留核心特征信息的同时,精简了数据规模,为后续高效的模型运算创造了有利条件。

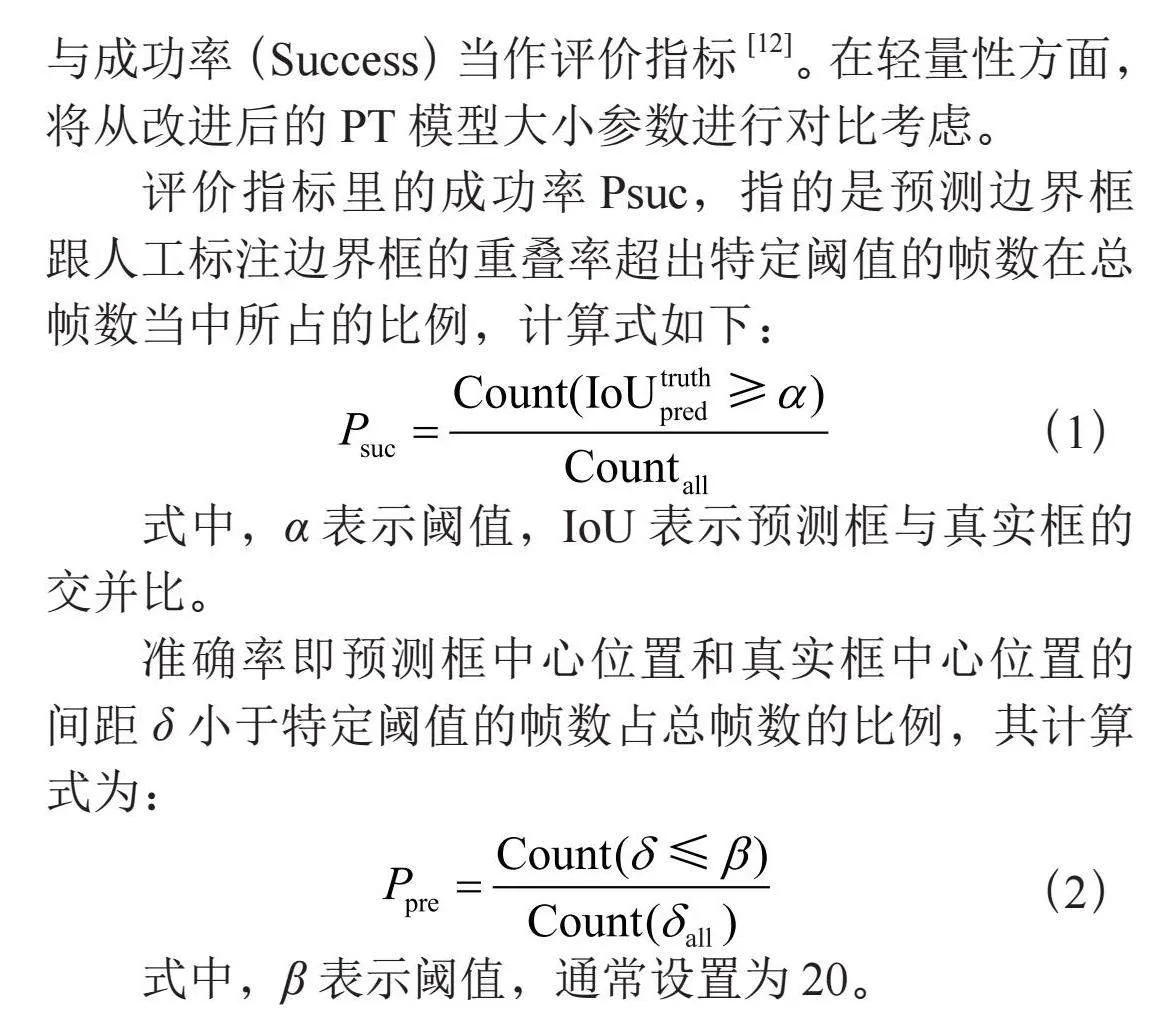

1.4" 轻量化头部网络

在目标跟踪算法中,头部网络对于最终准确检测和定位目标起着关键作用。为了进一步优化算法性能,同时降低计算资源的消耗,对原有的头部网络进行了轻量化改进,将其中的普通卷积替换为GhostNet中的GhostConv,并在相关部分采用深度可分离卷积减少相关计算量,实现方式如图4所示。

GhostConv是一种高效的卷积方式,传统卷积操作生成的特征图中存在冗余信息,而GhostConv通过巧妙的设计旨在减少这种冗余,同时保留关键的特征表达能力。GhostConv处理输入先进行1×1的卷积将输出通道减半,并保留这次的卷积特征信息,然后进行卷积核为3×3大小的卷积,最后将输出与之前的1×1卷积输出进行拼接融合,每次的卷积操作默认添加了批量归一化和激活函数。

2" 实验方法与结果分析

2.1" 实验平台与数据集介绍

实验使用的硬件平台配置为AMD R5 5600G CPU,机身内存16 GB,英伟达GeForce RTX2080Ti GPU。软件环境为Ubuntu 20,CUDA 10.2,Python 3.8,PyTorch 1.10.1。

模型验证基于开源框架PySot修改,在模型训练阶段,为了确保训练过程的有效性和结果的可重复性,batch-size设置为32,总的迭代次数(epoch)设置为20次,每次迭代训练时,冻结前10个epoch中的骨干网络参数,学习率在前5个epoch从0.001线性增加到0.005,在后续epoch中按对数下降到0.000 5,每个epoch的训练批量设置为32,设置VIDEOS_PER_EPOCH为400 000,CLS_WEIGHT和LOC_WEIGHT的设置都为1.0。使用公开工具包PySOT-Toolkit对模型性能进行评估。

训练使用的数据集是GOT-10K[10],它依据WordNet50结构构建,涵盖了87种不同的运动模型和560种常见目标。数据集包含了大约10 000个视频片段和150万个目标标注框。GOT-10K数据集首次将单样本协议的训练测试方法(One Shot Protocol)应用在目标跟踪数据集,避免测试集和训练数据集之间的重复,利于完成非特定目标的跟踪任务,实验设置GOT-10K的NUM_USE参数为100 000。

测试数据集使用OTB100[11],它一共有100段视频序列,对于每个视频序列,都有一个文件,其中记录了每一帧中目标位置的矩形边界框信息,该数据集由10种不同类型的目标组成,依据在跟踪过程中所遇到的挑战,划分为11类标签,包括遮挡、变换、视野消失、尺度变换、面内旋转、背景扰动、面外旋转、快速移动、低分辨率、光照变化和移动模糊。OTB以这些标签标记每个视频,单个视频可能有多个标签,便于识别其属性。

2.2" 评估数据集和评估指标

在OTB数据集评价指标中,遵循一次性评估协议(One-Pass Evaluation, OPE),选取准确率(Precision)与成功率(Success)当作评价指标[12]。在轻量性方面,将从改进后的PT模型大小参数进行对比考虑。

评价指标里的成功率Psuc,指的是预测边界框跟人工标注边界框的重叠率超出特定阈值的帧数在总帧数当中所占的比例,计算式如下:

(1)

式中,α表示阈值,IoU表示预测框与真实框的交并比。

准确率即预测框中心位置和真实框中心位置的间距δ小于特定阈值的帧数占总帧数的比例,其计算式为:

(2)

式中,β表示阈值,通常设置为20。

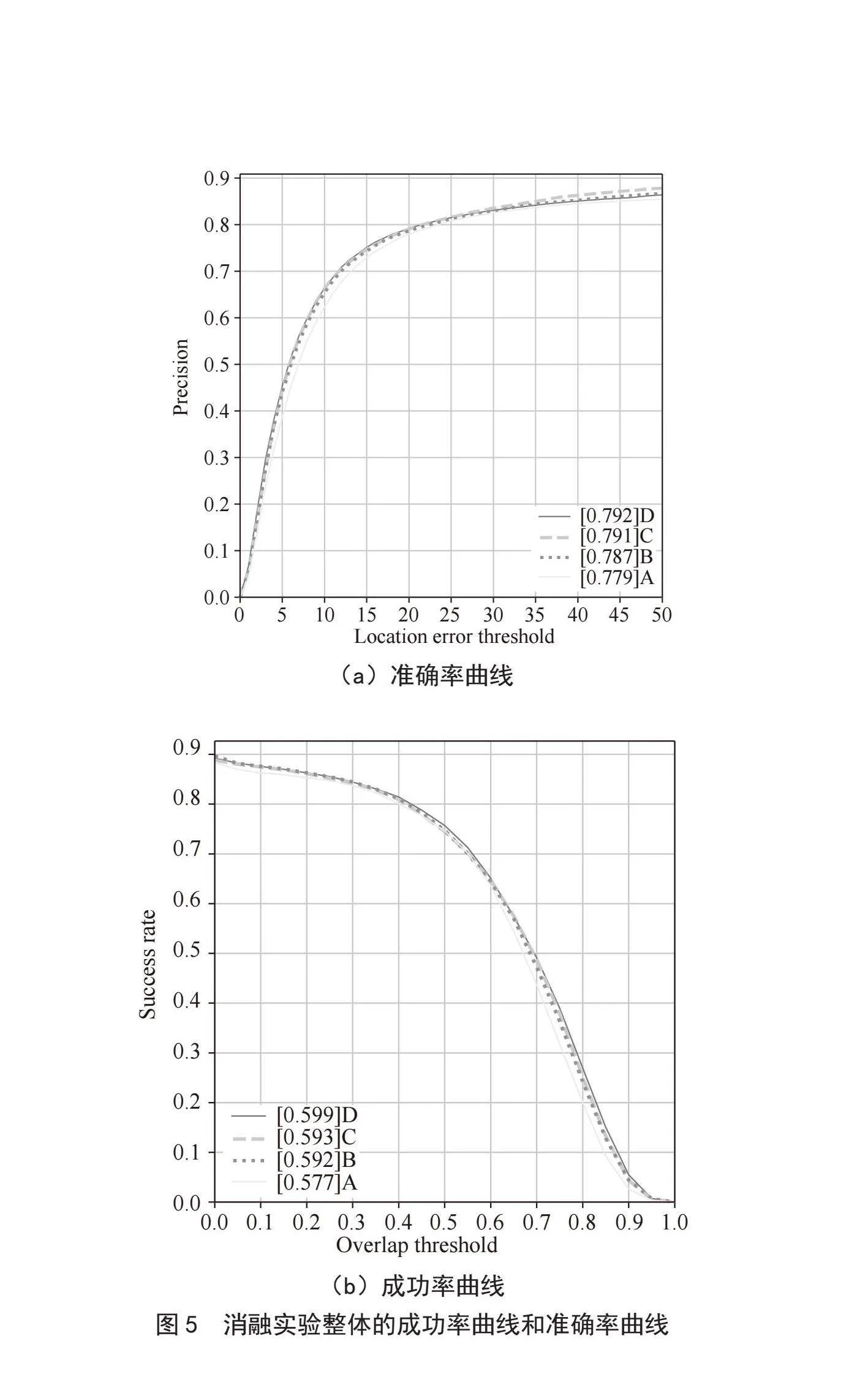

2.3" 消融实验

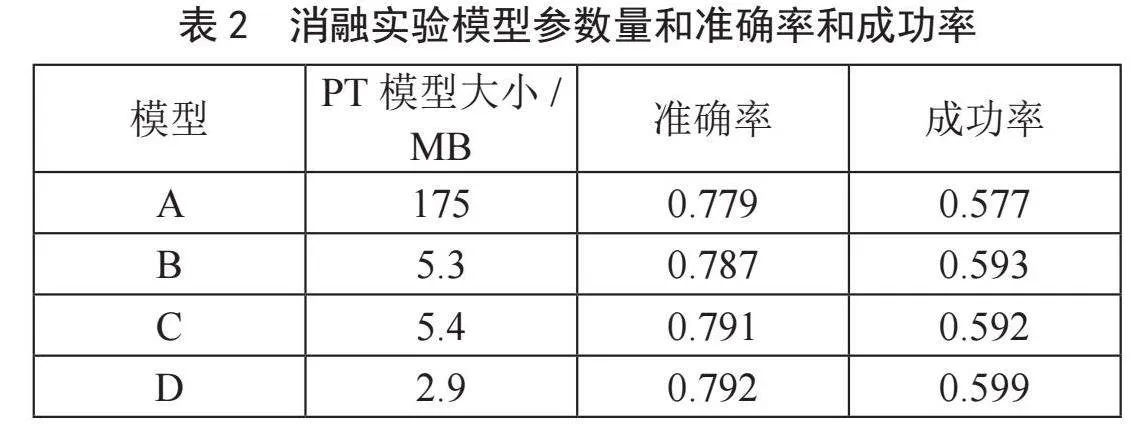

为了评估不同改进策略对模型性能的作用效果,设计了一系列消融实验。以经典的SiamRPN模型为基准,构建了如下几种不同配置的改进模型:

1)模型A。作为对照,使用未经改动的原始SiamRPN架构,以此为后续改进效果评估提供基线参考。

2)模型B。在SiamRPN的基础上,修改骨干网络为MobileNetv3,并将头部相关卷积部分使用深度可分离卷积。

3)模型C。在模型B的基础上,加入MobileNetV3的高低特征融合机制。

4)模型D。在模型C的基础上,将头部的普通卷积改成GhostConv。

通过上述逐步递增改进模块的方式,精准测试各模块单独及协同作用下对整体网络性能的提升贡献,并将具体的模型消融实验数据结果以直观的曲线图形式呈现,如图5所示。

将训练好的模型数据导出,查看模型参数量,结果如表2所示,根据实验结果可知,改进后的算法相当于原模型准确率提升1.6%,成功率提升3.8%,PT模型大小减少了172.1 MB,仅有2.9 MB,改进后的单目标跟踪算法模型能够在准确率和成功率提升的同时,大幅降低模型参数量。

2.4" 对比实验

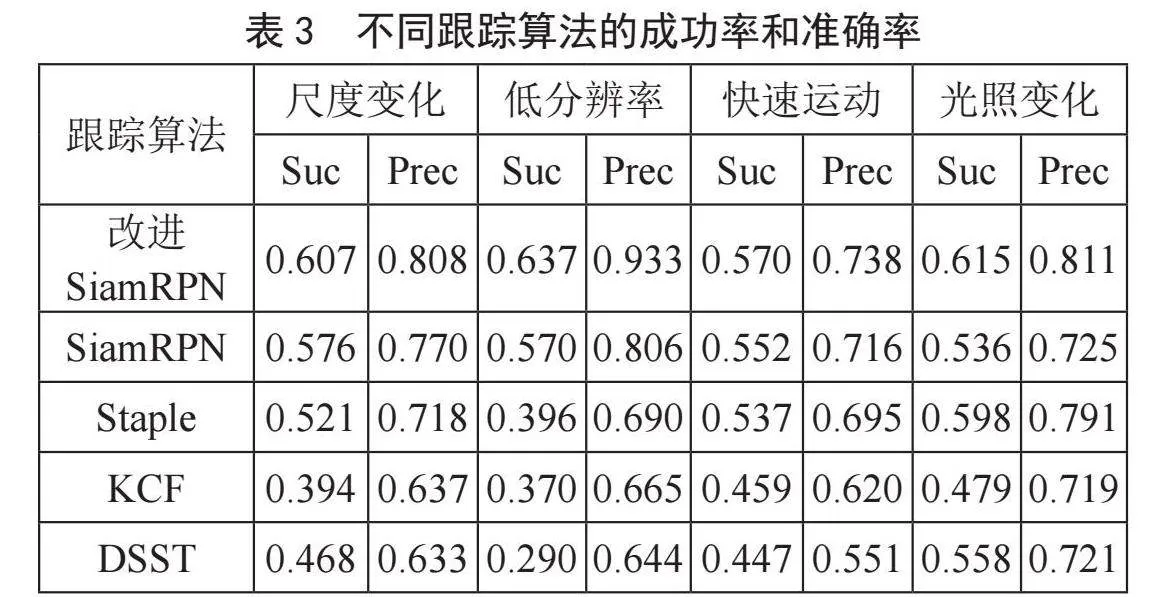

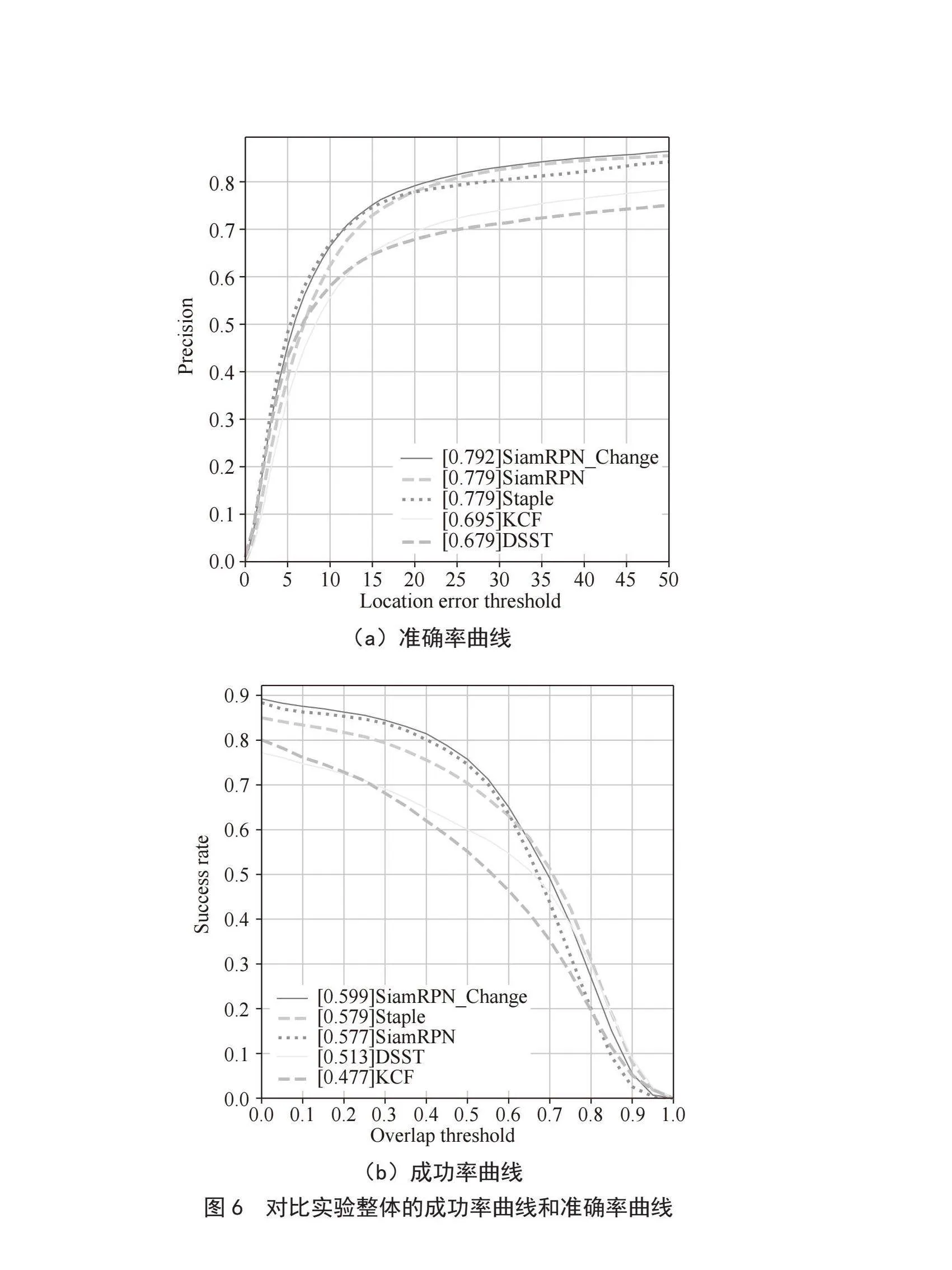

通过将改进后的算法与传统目标跟踪算法进行对比,评估了其在单目标跟踪任务中的性能,具体实验结果如图6所示。

为了更好地评估改良后的算法在复杂环境中的跟踪性能,在实验结果中导出了在OTB数据集上带有四种不同场景标签下的实验测试结果,包括尺度变化、低分辨率、快速运动和光照变化,如表3所示。实验结果展示了不同跟踪算法在测试数据集OTB不同场景下的成功率和准确率。

详细分析表3中的各项数据能够清晰地发现,经过优化改进之后的SiamRPN算法展现了较好的性能表现。无论是在光照复杂多变的场景之中,还是面对目标快速运动、尺度变化等极具挑战性的诸多场景下,该算法都始终能够维持着相对较高的成功率以及准确率。进一步彰显出改进后的SiamRPN算法在实际应用中的巨大优势与潜力。

3" 结" 论

针对基于孪生网络的单目标跟踪算法大部分计算资源消耗较大的挑战,提出了一种基于SiamRPN算法改良的单目标跟踪算法。该算法通过修改特征提取网络,改进卷积和相关的方式,更有效地提取与利用目标特征,提升了目标跟踪的整体性能以及对复杂场景的适应能力。对实验结果进行分析,得出以下结论:

1)改进后的算法相较于原SiamRPN算法,在公开的目标跟踪数据集OTB上测试成功率提高了3.8%,准确率提高了1.6%,且模型的参数量减少了98.3%,显著优化了算法对资源的利用效率,使其更适用于资源受限的应用平台。

2)在与其他传统目标跟踪模型的对比实验中,改进后的算法在不同场景下的成功率和准确率等关键性能指标上均展现出明显优势。未来,将着重聚焦于进一步优化特征融合策略,增强算法对复杂环境干扰因素的鲁棒性,并持续探索更高效的轻量化方法,致力于实现算法在更多类型边缘设备上的流畅部署以及实时性能的深度优化,以更好地满足不同应用场景下的目标跟踪需求。

参考文献:

[1] 马玉民,钱育蓉,周伟航,等.基于孪生网络的目标跟踪算法综述 [J].计算机工程与科学,2023,45(9):1578-1592.

[2] 王梦亭,杨文忠,武雍智.基于孪生网络的单目标跟踪算法综述 [J].计算机应用,2023,43(3):661-673.

[3] FU C H,LU K H,ZHENG G Z,et al. Siamese Object Tracking for Unmanned Aerial Vehicle: A Review and Comprehensive Analysis [J].Artificial Intelligence Review,2023,56(Suppl 1):1417-1477.

[4] 侯艳丽,魏义仑,王鑫涛,等.复杂场景下一种改进的单目标跟踪算法研究 [J].计算机仿真,2024,41(2):300-305.

[5] BERTINETTO L,VALMADRE J,HENRIQUES J F,et al. Fully-convolutional Siamese Networks for Object Tracking [C]//Computer Vision-ECCV 2016 Workshops.Amsterdam:Springer International Publishing,2016:850-865.

[6] LI B,YAN J J,WU W,et al. High Performance Visual Tracking with Siamese Region Proposal Network [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Salt Lake City:IEEE,2018:8971-8980.

[7] 丁奇帅,雷帮军,吴正平.基于孪生网络的轻量型无人机单目标跟踪算法 [J/OL].航空学报,2024:1-16(2024-09-03).http://kns.cnki.net/kcms/detail/11.1929.v.20240902.1443.018.html.

[8] HOWARD A,SANDLER M,CHEN B,et al. Searching for MobileNetV3 [C]//2019 IEEE/CVF International Conference on Computer Vision(ICCV).Seoul:IEEE,2019:1314-1324.

[9] TANG Y H,HAN K,GUO J Y,et al. GhostNetV2: Enhance Cheap Operation with Long-range Attention [J/OL].arXiv:2211.12905 [cs.CV].(2022-11-23).https://arxiv.org/abs/2211.12905.

[10] HUANG L H,ZHAO X,HUANG K Q. GOT-10K: A Large High-diversity Benchmark for Generic Object Tracking in the Wild [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2021,43(5):1562-1577.

[11] WU Y,LIM J,YANG M-H. Object Tracking Benchmark [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1834-1848.

[12] 钟晓伟,王志胜,丛玉华.基于轻量孪生网络的无人机目标跟踪算法 [J].弹箭与制导学报,2023,43(5):25-33.

作者简介:黎清华(2000—),男,汉族,重庆开州人,硕士在读,研究方向:嵌入式和图像处理;张雪秋(1995—),男,汉族,四川渠县人,硕士在读,研究方向:计算机软件和自然语言处理;张雨珊(2000—),女,汉族,重庆人,硕士在读,研究方向:计算机软件。