中图分类号:TP391.4;TP18 文献标识码:A 文章编号:2096-4706(2025)08-0061-05

Abstract: The image conversion of clothing sketches has enormous application value in fields such as visual editing, clothingdesign,ndhuman-computerinteraction.Atpresent,mostofthejectsconvertedfromsetchesarerelatielysimple shaps,suchasfaces,humanpostures,animalpostures,shoes,andbags.Theworkbasedosketchconversionisdifultto handle images withcomplex texturestructures,makingitchallnging tosolve thetask ofimageconversionforclothing sketches. To solve this problem,anapplicationresearchonsketch toclothing image conversion is proposed basedontheabove work. Through the reverse generation of clothing simulation sketches using the  -Net network model, theconstructionof the clothing sketch datasetiscompleted.Then,theimprovedBicycleGANnetwork isusedfortrainingtoachieve sketchconversion.Finally theexperimentaleffectsbeforeandaftertheimprovementarecompared.Theexperimentshowsthat theimprovedBicycleGAN network modelhassignificantimprovementcomparedtobefore,andwiththeimprovednetwork proposed inthis paper,thetask ofconverting clothing sketches to real clothing images can be effectively completed.

-Net network model, theconstructionof the clothing sketch datasetiscompleted.Then,theimprovedBicycleGANnetwork isusedfortrainingtoachieve sketchconversion.Finally theexperimentaleffectsbeforeandaftertheimprovementarecompared.Theexperimentshowsthat theimprovedBicycleGAN network modelhassignificantimprovementcomparedtobefore,andwiththeimprovednetwork proposed inthis paper,thetask ofconverting clothing sketches to real clothing images can be effectively completed.

Keywords: image conversion; clothing sketch; Generative Adversarial Networks

0 引言

目前草图图像转换的对象为人脸、人体姿态、动物姿态等较为简单的线条,但以线条较为复杂的服装图像作为图像转换对象的应用比较罕见。因此,本文就这个问题展开实验研究。简而言之,通过手绘服装草图,利用计算机图像处理生成与之对应的真实服装图像,该方法在视觉编辑、服装设计、人机交互等领域极具应用价值。

早期的关于草图图像的研究主要在草图检索和草图识别领域上[1-2]。草图检索是指通过草图找到对应的图像。草图识别是指输入草图,识别其类别或检测其中的特定对象。而Isola等人基于条件生成的对抗网络(ConditionalGANs)则提出了一个统一的框架pix2pix,该框架将能将一种类型的图片转换成另一种类型[3]。在他们的实验中,实现了将鞋子和皮包等草图转换成对应真实图像的功能。然而pix2pix网络模型最大的缺点就是输入一张草图只能输出一张对应的图像,生成的结果十分单一,为了增加多样性,Zhu等人提出BicycleGAN,它可以实现一对多映射的图像转换任务,但其图像转换任务的对象仍是鞋子和皮包[4]。基于BicycleGAN的思路,本文提出一种研究方案:首先将原BicycleGAN中的训练图片替换成线条更加错综复杂的服装真实图片和其对应的草图来作为训练目标,然后对BicycleGAN的生成器进行改进,利用改进后的BicycleGAN训练模型进行测试,最后通过实验结果的对比来说明两个结论,1)改进后的BicycleGAN比原模型有较大的提升。2)以服装草图为对象的图像转换任务能达到比较好的应用效果。

基于生成对抗网络的图像转换应用需要提供大量的训练样本[5],而现有的图像数据集不能满足要求。因此,在现阶段数据集缺乏的情况下,本文提出利用边缘检测算法[来构建数据集的方法:利用边缘检测算法对服装图像进行处理,生成对应的服装模拟草图,这样就形成了一一对应的服装草图和服装图像,可用于配对进行训练。

1构建服装数据集

生成对抗网络需要大量的数据集用于训练模型,本文提出通过  -Net将真实的服装图像逆向生成其对应的服装模拟草图,从而构建数据集。

-Net将真实的服装图像逆向生成其对应的服装模拟草图,从而构建数据集。

1.1服装图像的标准与筛选

标准:1)服装图像不能有其他的干扰物,如人物、动物、杂物等,不能与图像中的服装一起出现。2)图像展示的服装应整洁居中平整,无褶皱。3)图像背景除服饰外,应为全白色。

筛选:在网络上通过上述标准搜索在服装网页上通过网络爬虫的方式抓取数据信息得到2万多张上衣服装图像。

1.2  网络模型逆向生成服装模拟草图

网络模型逆向生成服装模拟草图

本文采用  -Net边缘检测算法来逆向生成一一对应关系的服装模拟草图。Qin等人提出的

-Net边缘检测算法来逆向生成一一对应关系的服装模拟草图。Qin等人提出的  是一种嵌套的双层U-Net结构,其特殊的结构使得在检测图像边缘有着很好的识别效果,他可以将一张图像精准的剥离出其边缘。因此本文的数据集工作使用

是一种嵌套的双层U-Net结构,其特殊的结构使得在检测图像边缘有着很好的识别效果,他可以将一张图像精准的剥离出其边缘。因此本文的数据集工作使用 -Net边缘检测算法来逆向生成服装模拟草图。用之前得到的2万余张图像,通过

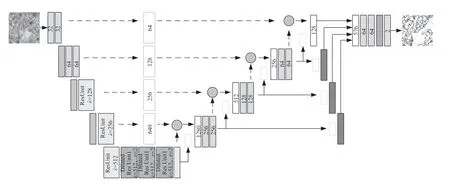

-Net边缘检测算法来逆向生成服装模拟草图。用之前得到的2万余张图像,通过  -Net边缘检测算法得到服装模拟草图,经过三轮筛选剔除效果不好的,最后得到5000张一一对应的服装模拟草图,其生成效果效果如图1所示,最后将得到的草图与原图像进行一一配对,又因BicycleGAN网络模型的训练要求,将图像全部调整为 2 5 6 × 2 5 6 的尺寸,将其中的4500张作为本次实验的训练集,500张作为本次实验的测试集,至此本文的服装草图数据集构建完成。

-Net边缘检测算法得到服装模拟草图,经过三轮筛选剔除效果不好的,最后得到5000张一一对应的服装模拟草图,其生成效果效果如图1所示,最后将得到的草图与原图像进行一一配对,又因BicycleGAN网络模型的训练要求,将图像全部调整为 2 5 6 × 2 5 6 的尺寸,将其中的4500张作为本次实验的训练集,500张作为本次实验的测试集,至此本文的服装草图数据集构建完成。

"图1U2-Net对服装图像逆向生成服装模拟草图

"图1U2-Net对服装图像逆向生成服装模拟草图2 实验模型的介绍

本文的实验是以BicycleGAN网络模型为基础,在其生成器上做了改进,在其原本的生成器U-Net网络结构上添加了自注意力机制的模块,使其生成的图像比原模型更加清晰。

2.1 BicycleGAN模型

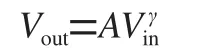

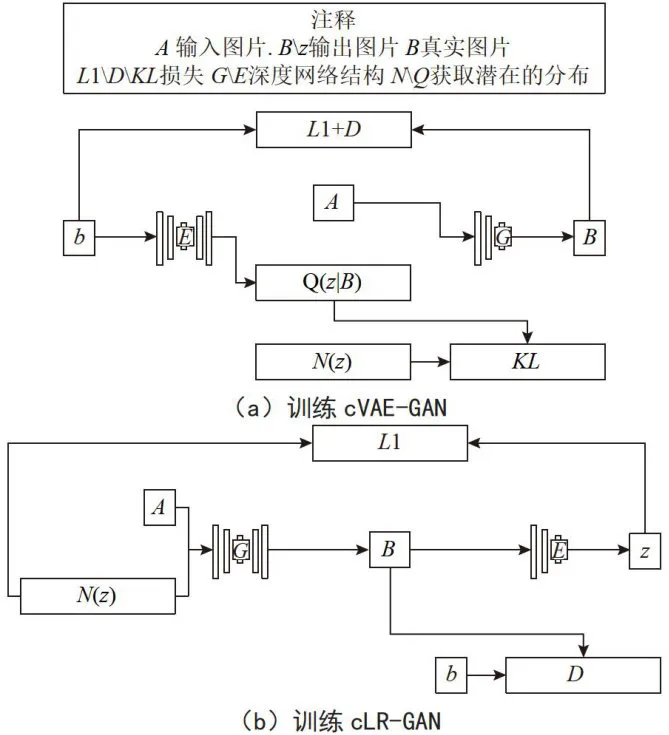

以草图生成真实图像为例,图像转换任务大多都是一对一的映射,这样缺乏多样性的图像转换显然无法满足实际应用的需求。在这样的背景下,Zhu等人提出BicycleGAN网络模型,其网络结构如图2所示。

图2BicycleGAN网络结构图

图2BicycleGAN网络结构图图(a)表示cVAE-GAN模型,它从前一个真实图像b开始,它将编码到潜层空间。生成器随后将输入图像A和采样的 z (这个 z 是从编码结果中采样的,而不是噪声正态分布中采样的)映射回原始图像 b 。图(b)表示cLR-GAN模型,它随机地从一个已知分布中采样潜层编码 z ,并将它和输入图像 A 一起映射到输出图像 B ,随后从输出中采样潜层编码。

在图像转换领域中,BicycleGAN最大的特点就是实现了图像转换之间的多映射任务,输入一张草图,可以输出基于输入的多张结果图像。

2.2自注意力机制模块

注意力机制模块在生成对抗网络中的应用日益广泛[8],其主要的作用在于可以增强局部图像的处理能力,通过特殊的结构,使图像在被处理时,可以聚焦于人们想关注的信息,而忽略人们不想关注的信息,在提高图像处理效率的同时,也极大地提升了图像处理重点信息的能力。而自注意力机制模块则是在注意力机制模块的基础上发展而来[],相比注意力机制模块,自注意力机制模块可以加强内部的联系,忽略更多的外部信息,同时加强对重点内部信息的处理。

AttentionU-Net[网络结构就是采用了自注意力机制模块,其核心部分的自注意力机制模块被嵌入到作为生成器的U-Net网络结构中,从而大大提升生成器的图像处理能力。以本文实验为例,它可以提升处理服装线条和纹理的效率和能力,忽略不重要的信息例如图像的噪声和图像的空白区域。

2.3改进后的生成器结构

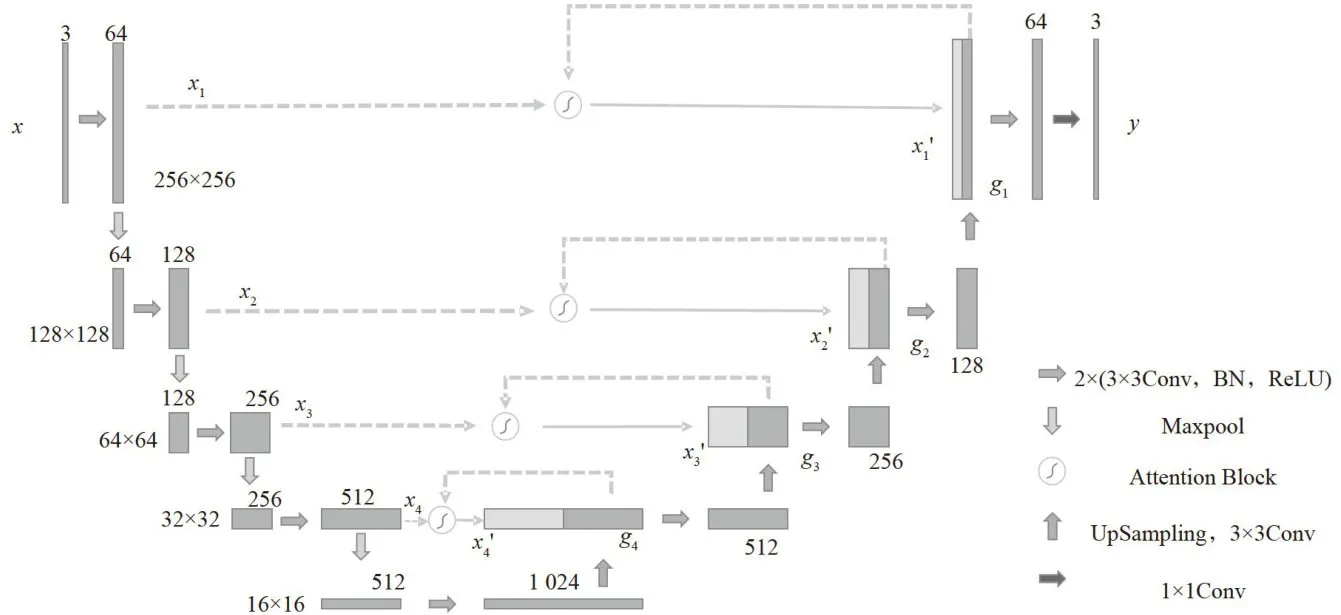

BicycleGAN的生成器是U-Net网络结构,本文对BicycleGAN的生成器进行改进,其方案是对原来的U-Net网络结构插入自注意力机制模块,使其生成器改进为AttentionU-Net网络结构。生成器的主要结构如图3所示。

图3改进后的BicycleGAN网络结构图

图3改进后的BicycleGAN网络结构图( 3 × 3 C o n v ,BN,ReLU)表示用 3 × 3 卷积核对图像进行处理,再进行批量归一化的处理,最后使用ReLU激活函数以得到处理后的图像特征图。此过程中,步长 s 为1,图像的填充padding为1。Maxpool表示对图像进行一次下采样,使图像的长和宽都减少一半,大小变成原图的1/4。AttentionBlock表示自注意力机制模块。UpSampling, 3 × 3 C o n v 表示对图像进行反卷积的上采样,使图像的长和宽都放大一倍,大小变成原图像的4倍。 1 × 1 C o n v 表示图像经过一个 1 × 1 的卷积核,这里的目的主要是改变图像的通道数,使图像恢复3个通道以达到输入图像保持一致。

3 实验及结果分析

3.1 实验设置

本文的实验条件和环境是依据BicycleGAN网络模型给出的要求来设置的,在单GPU的服务器上训

练测试。

本文将服装上衣作为实验对象,依据之前的方法构建了服装上衣数据集,最终获得了5000对有效的配对图像。将所有图像调整为 2 5 6 × 2 5 6 的尺寸,然后选取4500对作为本次实验的训练数据集,500对作为测试数据集。

3.2 评价指标

本文主要使用MAE(MeanAbsoluteErrorLoss-平均绝对误差)、MSE(Mean Squared ErrorLoss-平均均方误差)和VGG_loss(perceptual loss-感知损失)三种损失函数来评估实验结果的损失,用SSIM(structuralsimilarity-结构相似性)和PSNR(PeakSignaltoNoiseRatio-峰值信噪比)来评估实验结果的图像质量。用FID (Frechet InceptionDistance score)和LPIPS值来评估生成图片的质量和多样性,其中较低的FID值意味着图像生成质量更好,较高的LPIPS值意味着图像生成的多样性更高。

3.3实验结果及对比分析

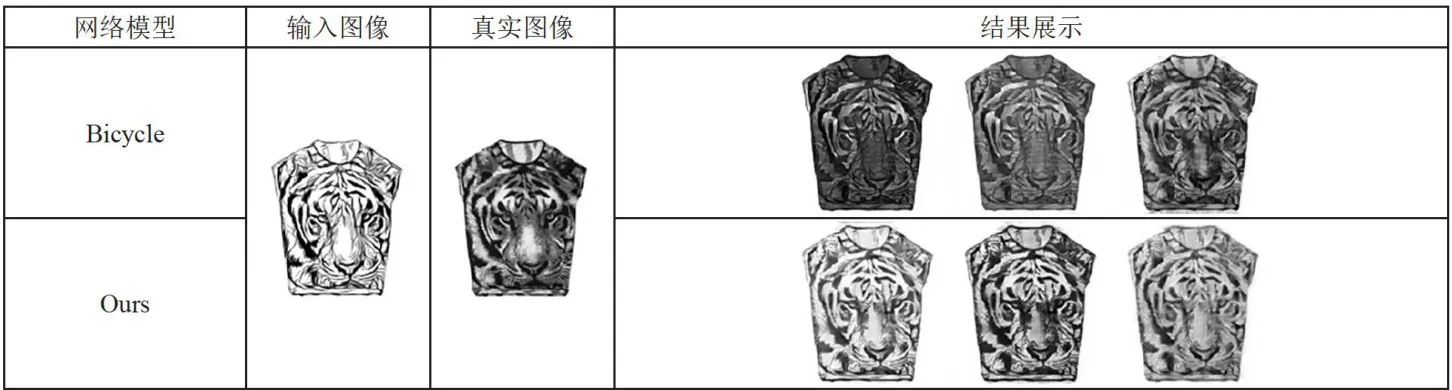

两个模型各会随机生成十张样式各异的图像,这里各取三张来说明效果。实验结果如表1所示。

表1图像转换效果对比

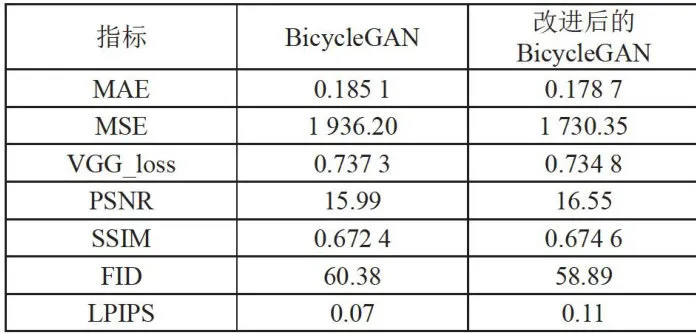

表1图像转换效果对比为了更加客观的对比BicycleGAN与改进后BicycleGAN的差异,本文通过500张测试集对其结果进行上述指标的检测,而对于LPIPS值来说,因测试集500张的图像的数据过大,本文随机选取了50张进行计算其LPIPS值。实验结果如表2所示,可以看出改进后BicycleGAN的三项损失结果总体要低于未改进的BicycleGAN,而SSIM和PSNR的指标总体要高于未改进的BicycleGAN。这在一定程度上表明改进后BicycleGAN的转换图像丢失的损失更少且生成效果与质量更佳。而在FID值和LPIPS值上,改进后BicycleGAN的FID值要低于未改进的BicycleGAN,改进后BicycleGAN的LPIPS值要高于未改进的BicycleGAN,这在一定程度上表明BicycleGAN转换图像的质量更佳且多样性更丰富。

表2实验评价指标对比

表2实验评价指标对比4结论

目前已有的基于边缘线条转换真实图像的研究中大多是以人脸、动物的脸、人体姿态、动物姿态、包包和鞋子等比较简单线条的图案作为对象,因为服装特性有着巨大的应用价值,本文提出用较为复杂的上衣服装作为对象进行图像转换的任务,并且提出通过边缘检测算法  -Net对服装图像逆向生成模拟草图的方法来构建数据集,模拟草图具有线条清晰、拟合原图、清晰度高的特点。实验表明:1)改进后的BicycleGAN网络模型比原模型在图像清晰度、多样性上都有比较大的提升;2)对服装数据集进行训练测试可达到可视性比较好的效果,虽然服装草图线条较简单的草图更复杂一些,但是服装草图到真实服装图像转换仍有可实现性,并且有比较好的清晰度和多样性,可达到应用水平。3)采用

-Net对服装图像逆向生成模拟草图的方法来构建数据集,模拟草图具有线条清晰、拟合原图、清晰度高的特点。实验表明:1)改进后的BicycleGAN网络模型比原模型在图像清晰度、多样性上都有比较大的提升;2)对服装数据集进行训练测试可达到可视性比较好的效果,虽然服装草图线条较简单的草图更复杂一些,但是服装草图到真实服装图像转换仍有可实现性,并且有比较好的清晰度和多样性,可达到应用水平。3)采用 -Net边缘检测算法生成模拟草图数据的方法有望在数据集扩充、幼儿教育、服装设计、艺术创造等方面产生更多的应用。

-Net边缘检测算法生成模拟草图数据的方法有望在数据集扩充、幼儿教育、服装设计、艺术创造等方面产生更多的应用。

参考文献:

[1]陈健.基于手绘草图的图像检索研究[D].杭州:浙江工业大学,2020.

[2]杨金凯,王国中,范涛.基于神经网络的手绘草图的识别与匹配[J].智能计算机与应用,2021,11(6):148-152.

[3] ISOLAP,ZHUJY,ZHOU T,et al. Image-to-ImageTranslation with Conditional Adversarial Networks[C]//2017IEEEConference on Computer Vision and Pattern Recognition(CVPR).Honolulu:IEEE,2017:1125-1134.

[4]ZHUJY,ZHANGR,PATHAKD,etal.TowardMultimodal Image-to-Image Translation[J].Advancesin NeuralInformation Processing Systems,2017,30:465-476.

[5]李林,王家华,周晨阳,等.标检测数据集研究综述[J].数据与计算发展前沿:中英文,2024,6(2):177-193.

[6]李翠锦,瞿中.基于深度学习的图像边缘检测算法综述[J].计算机应用,2020,40(11):3280-3288.

[7] QIN X,ZHANG Z,HUANG C,et al. U2-Net: GoingDeeperwith Nested U-Structure for Salient ObjectDetection [J/OL].Pattern Recognition,2020,106:107404[2024-09-03].https://doi.org/10.1016/j.patcog.2020.107404.

[8]任欢,王旭光.注意力机制综述[J].计算机应用,2021,41(S1):1-6.