摘 要:基于现有深度神经网络模型无法根据使用权限进行分级授权的问题,设计提出了一种新型的DNN模型分级授权方法,其可以根据模型权限不同分发不同模型精度。该方法依据模型剪枝技术实现了模型性能的分级,利用特定的剪枝速率或剪枝阈值对模型进行剪枝和微调,通过在剪枝和微调阶段对模型进行调整从而使模型输出不同等级的准确率,最后将不同的用户权限与对应等级的准确率相匹配。在多个数据集和DNN模型上进行了实验,并利用CIFAR-10和CIFAR-100数据集进行验证。实验结果表明,该方法能够有效地将模型的性能分级,在多个DNN模型上都有良好的效果。

中图分类号:TP391.4 文献标识码:A 文章编号:2096-4706(2024)08-0128-06

DOI:10.19850/j.cnki.2096-4706.2024.08.028

0 引 言

如今,深度学习已经逐渐发展成熟,在图像[1-3]、视频[4]和自然语言处理[5-7]等方面的需求也日益增加。越来越多的互联网公司利用CPU、TPU等强大的计算能力,以及专业的知识和大量的数据对深度神经网络(Deep Neural Networks, DNN)模型进行训练。DNN模型在不断发展的同时也蕴含着十分巨大的经济价值和商业价值,所以对DNN模型的保护尤其重要。主动授权作为具有预防策略的DNN模型版权保护方案,存在着改变模型内部结构和加密解密需要消耗大量资源的缺点,针对该问题我们在之前的一篇文章中提出了基于信道剪枝的防止非法使用DNN的方法[8]。不过,由于用户对模型的预算不同,所获得的模型权限也不同。模型拥有者希望对模型性能进行划分,以便对用户授权不同的模型性能使用权限。如果无法根据不同的权限对用户提供对应准确率的模型,很容易造成DNN模型的模型资源的浪费。针对上述的DNN模型版权保护和DNN模型的分级授权问题,本文提出了一种基于模型结构化剪枝的神经网络分级授权的方法。

本文的主要贡献包括以下三点:

1)本文提出了一种基于模型剪枝的分级授权DNN模型的新方法。该方法可以有效地对模型实现性能分级,为不同权限的用户提供多种性能的模型。

2)剪枝阶段采用了结构化剪枝的机制,在模型性能分级过程中有效降低了计算量。

3)经过多种实验结果表明,本文提出的方法极大地保留了原模型性能,也有效地保护了模型的所有权。

1 相关工作

1.1 模型剪枝

DNN模型通常是过拟合的,具有很大的冗余。针对该问题人们提出了许多消除冗余的方法,其中最常用的方法为模型剪枝[9]。Han等人[10]提出了三步修剪冗余连接的方法,根据训练确定网络连接的重要程度,对不重要的连接置0并修剪,最后通过微调剩余连接权重回复模型性能;He等人[11]提出了迭代的两步算法,采用基于LASSO的回归信道选择并利用最小二乘重构修剪,该方法有效地减少了剪枝积累的错误。

1.2 分级授权

由于DNN模型逐渐进入商业化阶段,模型拥有者根据需求对用户权限进行划分,所以模型分级授权开始被提出。Tian等人[12]在提出一种选择性加密算法时提到了分级授权,他们用概率选择策略选择重要的模型参数,然后对重要的小部分参数进行加密,设计了一组访问权限,通过解密不同的参数,可以为用户提供不同等级的性能的模型;Luo等人[13]提出了利用拉普拉斯机制对输出扰动实现分级授权,该方法考虑到了权限来自不同的用户,通过不同程度的扰动输入,模型会产生不同精度的输出效果。

2 方法论

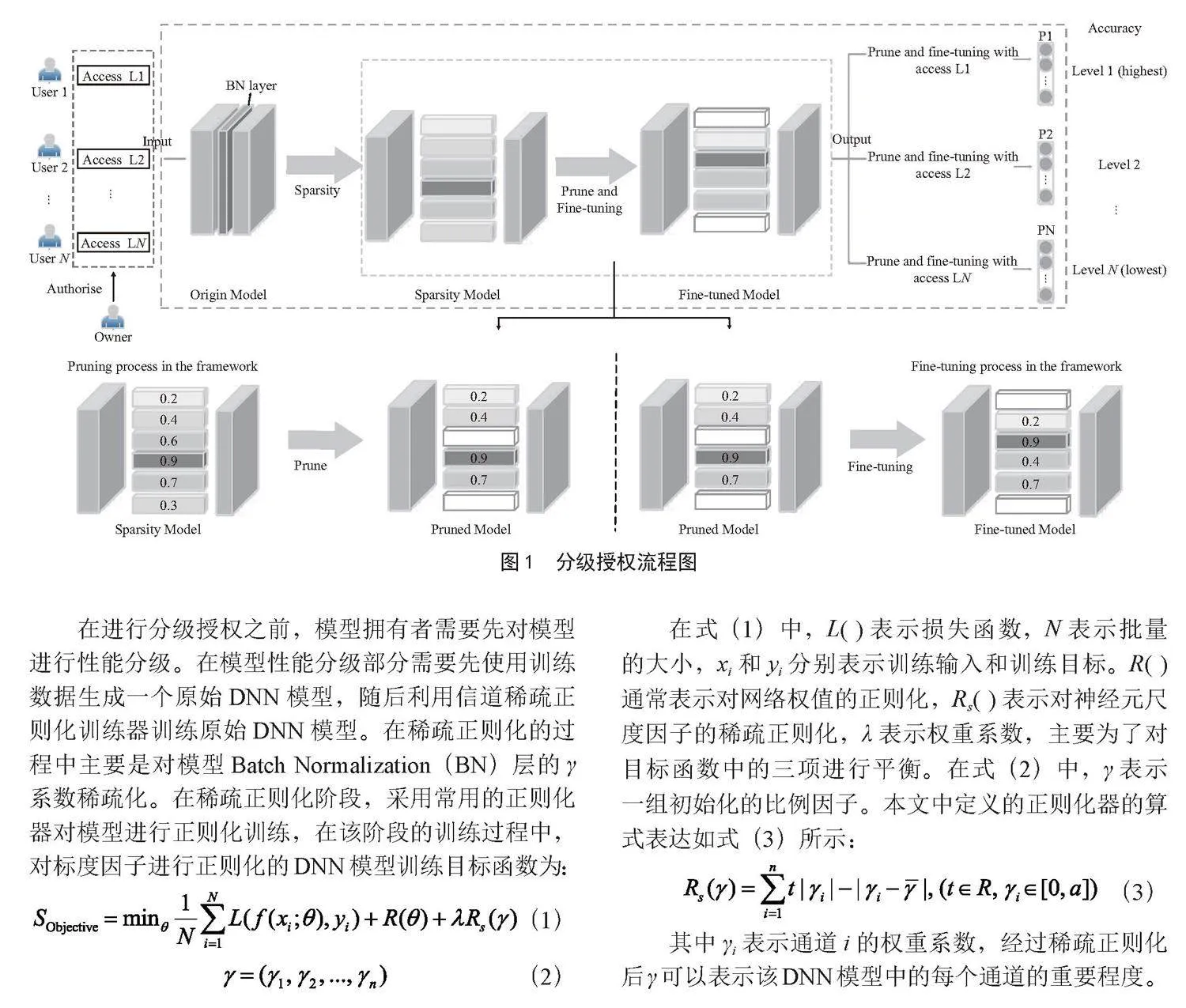

在本节中将对本文提出的分级授权方法做详细的介绍。在2.1节主要对图1中的分级授权流程图的具体过程作详细介绍,具体过程包括从授权、剪枝到分发的全过程;在2.2节将对图2中展示的两种分级方法分别做详细的介绍。

2.1 分级授权的实现过程

分级授权方法的流程图如图1所示,其中包括了分级授权部分和模型性能分级部分。

在进行分级授权之前,模型拥有者需要先对模型进行性能分级。在模型性能分级部分需要先使用训练数据生成一个原始DNN模型,随后利用信道稀疏正则化训练器训练原始DNN模型。在稀疏正则化的过程中主要是对模型Batch Normalization(BN)层的γ系数稀疏化。在稀疏正则化阶段,采用常用的正则化器对模型进行正则化训练,在该阶段的训练过程中,对标度因子进行正则化的DNN模型训练目标函数为:

(1)

(2)

在式(1)中,L( )表示损失函数,N表示批量的大小,xi和yi分别表示训练输入和训练目标。R( )通常表示对网络权值的正则化,Rs( )表示对神经元尺度因子的稀疏正则化,λ表示权重系数,主要为了对目标函数中的三项进行平衡。在式(2)中,γ表示一组初始化的比例因子。本文中定义的正则化器的算式表达如式(3)所示:

(3)

其中γi表示通道i的权重系数,经过稀疏正则化后γ可以表示该DNN模型中的每个通道的重要程度。在稀疏训练阶段的正则器将每个比例因子限制到一个合理的范围内,即γi ∈ [0,a],其中a>0。

(4)

其中" 表示γ1,γ2,…,γn的均值。

原始DNN模型经过稀疏正则化训练后每个信道都被标上了对应的尺度因子,并将尺度因子从小到大进行排列。其中尺度因子较小的表示对DNN模型的影响较小,而较大的尺度因子表示该信道为该DNN模型的主要信道,代表了该模型的主要功能部分。

完成稀疏训练阶段之后,就可以对DNN模型进行剪枝。在模型剪枝阶段需要对模型采用特定的剪枝率或剪枝阈值,选择的特定剪枝率或剪枝阈值需要保证通过剪枝和微调后的模型性能需要符合用户权限所对应的性能。在剪枝阶段,我们对信道尺度因子较大的进行剪枝,剪枝后的模型精确度急速降低,甚至达到了一种不可使用的程度。将剪枝率或者剪枝阈值作为密钥,这时候通过密钥就可以对剪枝后的模型进行微调。剪枝后的模型通过微调恢复到与用户权限对应的性能。对于非授权用户,由于没有正确的密钥所以无法将模型损失的信道进行微调恢复,模型将始终处于较低的精确度无法使用。剪枝后的模型是否能够恢复到原始模型的性能,主要判断利用的剪枝率或剪枝阈值是否和分发的密钥相同,模型恢复算式如下:

(5)

通过剪枝和微调恢复的方式实现对不同用户授权不同精确度的DNN模型。在该方法中特定的密钥作为主要的认定工具,只有拥有密钥的用户才可以使用对应权限的模型。经过微调恢复原始性能的模型,其中剪枝损失的信道只占重要通道总数的很小一部分,所以恢复后的最高等级的模型性能是可以接近原始模型的性能的。剪枝后的模型损失了大量的重要信道,所以非授权用户即使盗取了也会因为准确率低而无法使用。

2.2 两种分级授权方法实现

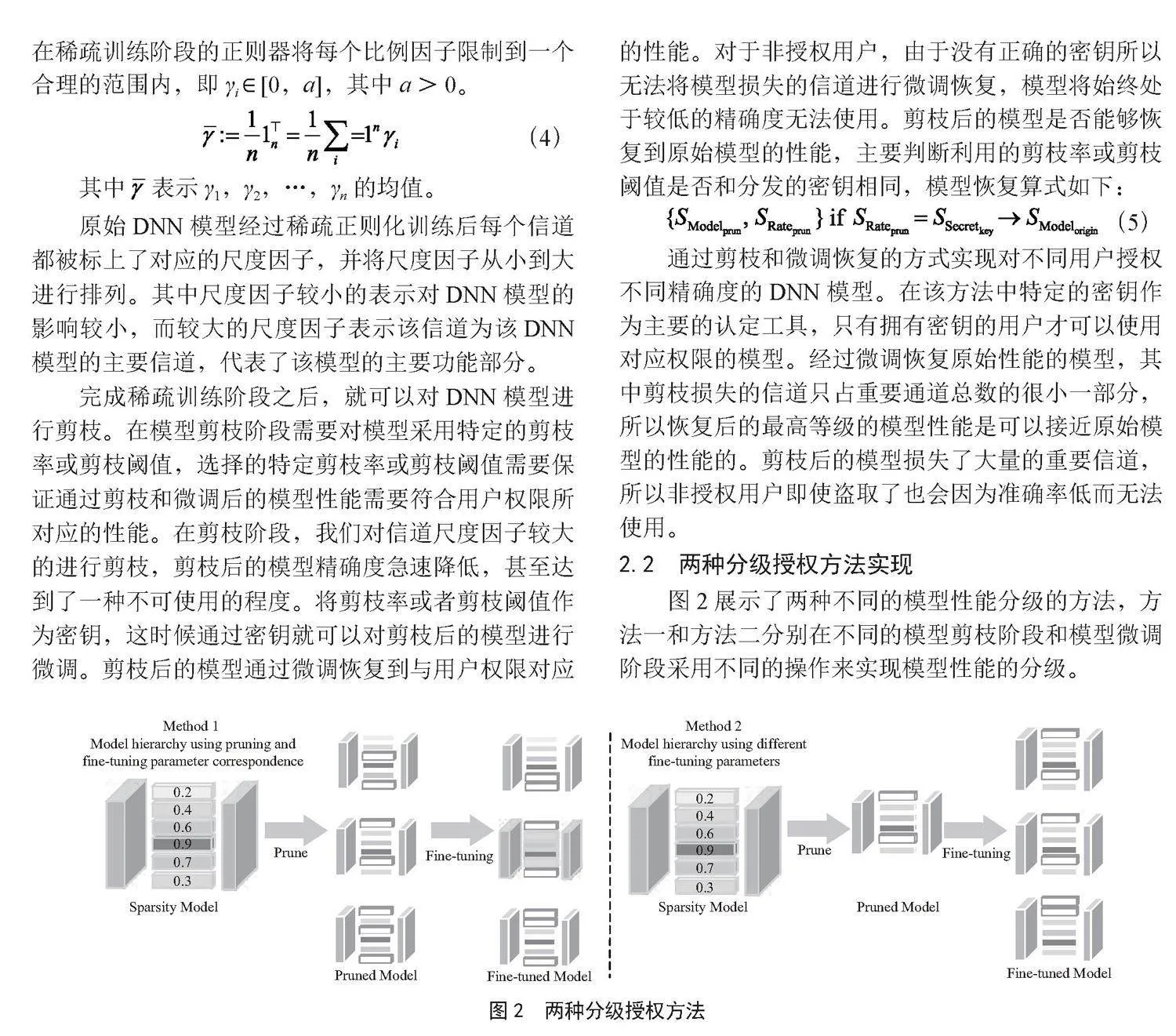

图2展示了两种不同的模型性能分级的方法,方法一和方法二分别在不同的模型剪枝阶段和模型微调阶段采用不同的操作来实现模型性能的分级。

在方法一中,采用不同的剪枝率或剪枝阈值对模型进行剪枝,剪枝后的模型使用与其唯一对应的微调参数进行微调。经过剪枝和微调后的模型会产生不同的性能分级效果。该方法最主要的优点是可以极大程度地保护模型本身的安全,剪枝和微调的参数对应可以实现模型认证功能。由于剪枝后的模型性能很低,所以即使被盗取也无法使用,可以很大程度上避免模型盗取等问题。

在方法二中,对模型采用唯一的剪枝率进行剪枝,剪枝后的模型会利用不同的微调参数进行微调。微调的方法在受到剪枝策略不同、剪枝指标计算以及模型特性等条件的影响下也会产生模型性能分级的效果。模型微调的微调率会因为过度微调而产生下降的现象,依据这一现象本文实现了第二种模型分级的方法。该方法的优点是减少了剪枝过程中的计算量,实现了一个剪枝模型分级出多个不同性能模型的效果。经过剪枝后的模型准确率很低,也极大程度地避免了模型盗取的问题。

DNN模型可以将一个分类问题进行划分,最后的输出会将输入图像划分为m个类。在DNN模型测试过程的最后,DNN模型利用Softmax函数得到概率为m的P。通常我们会根据需要分别将概率值最高的类别或者前几个概率最高的类别作为分类结果。性能越好的模型越可以准确地将输入的图片划分到更高概率的分类中,而性能较差的通常会划分在前几个概率最高的类别中。所以我们根据上述概念将模型的输出精度划分成N个等级:L1,L2,…,Ln。其中L1的输出精度最高,L1相对被模型拥有者授予的权限也是最高的。相反Ln的输出精度最低,对应授予的权限也是最低的。因此,经过分级授权后模型相应的分类概率应该为:P1, P2, …, Pn。

在分级授权的过程中,模型拥有者首先会对用户授予不同的权限,权限的依据为不同的密钥。根据权限的不同,模型会根据所对应的剪枝率或剪枝阈值进行剪枝,然后再根据对应的微调参数进行微调。经过以上操作后模型会被划分为不同性能的模型,即SModel = m1, m2, …, mn。所以在本文中模型与模型性能等级对应算式如下:

(6)

3 实验结果及分析

在本节中主要对本文提出的方法进行实验验证。在实验中,我们主要研究了两个数据集CIFAR-10 [14]和CIFAR-100 [14]和主流的DNN模型,即VGG-16 [15]、VGG-19 [15]和ResNet-56 [16]。在3.1节对实验使用的数据集和实验环境做详细的介绍,在3.2节和3.3节中给出了不同实验的结果和分析。

3.1 数据集及实验环境

CIFAR-10数据集包含了60 000张32×32分辨率的彩色图像,其中训练集50 000张,测试集10 000张。CIFAR-10数据集中的图片被分为了10个不同类别。CIFAR-100数据集包含了60 000张32×32分辨率的彩色图片,其中训练集50 000张,测试集10 000张。CIFAR-100数据集中的图片分为了100个不同类别。

3.2 神经网络性能分级实验结果与分析

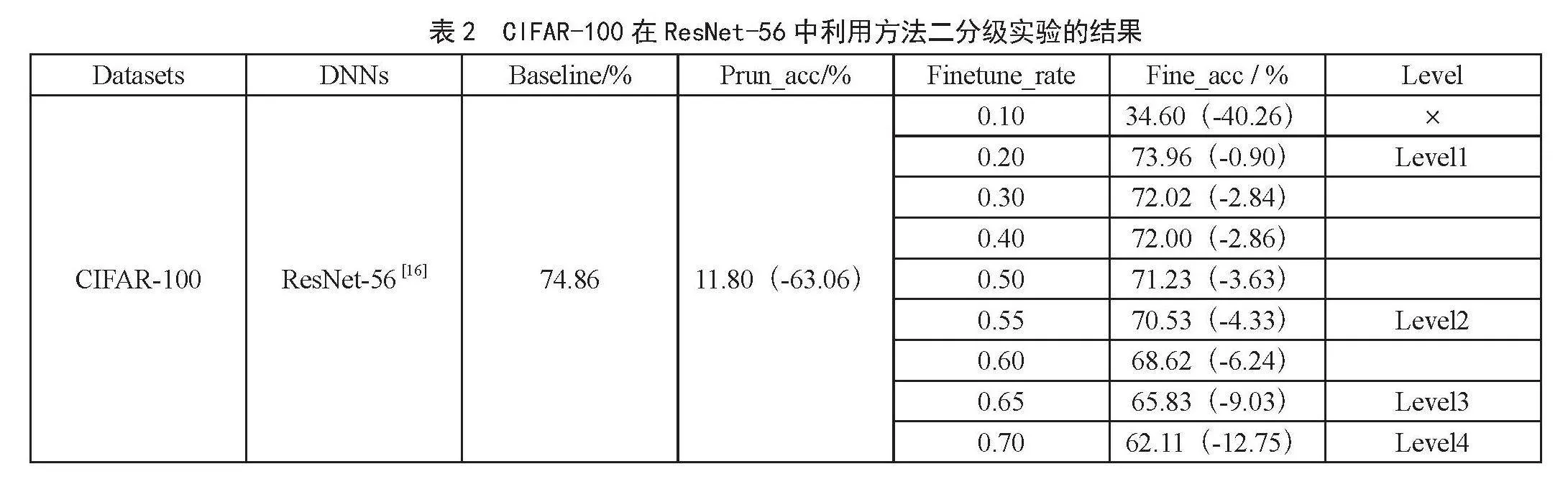

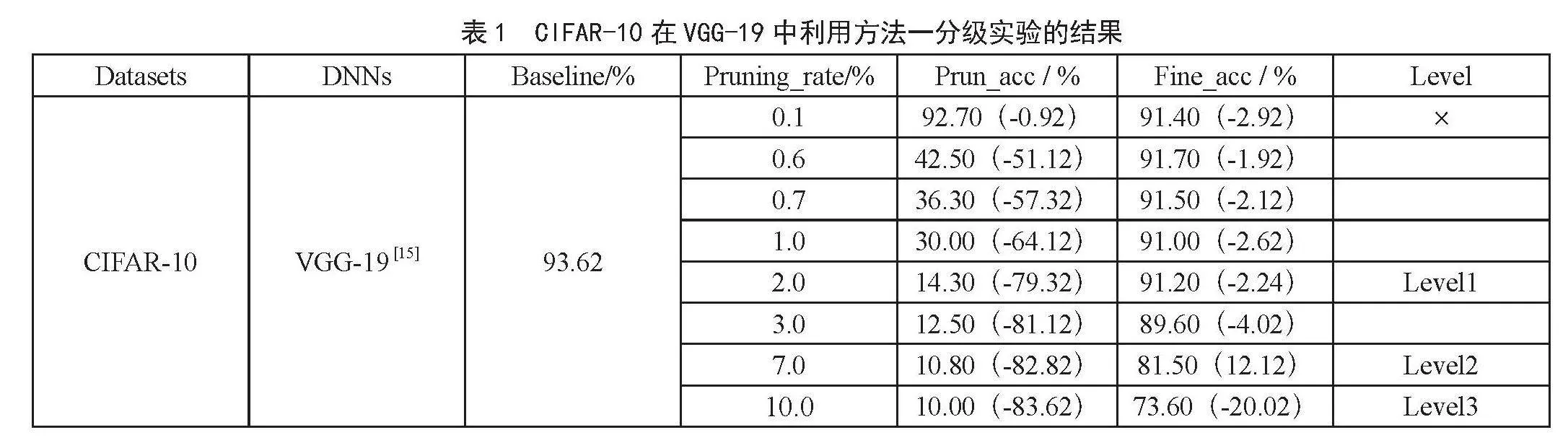

在文中模型未进行修改时的准确率为baseline,剪枝后的模型准确率为Prun_acc,剪枝微调后的模型准确率为Fine_acc。我们将对Fine_acc进行比较并得出不同分级对应的模型准确率,其中Level表示不同的分级等级,对于无法作为分级授权使用的剪枝率或阈值,我们将用×表示。

在VGG-19中,我们使用表1中罗列的不同的剪枝率对模型进行修剪,用CIFAR-10训练获取Prun_acc和Fine_acc。由于在分发过程中我们将对剪枝后的模型进行分发,所以需要要求剪枝后的模型性能下降。剪枝率为0.1%时Prun_acc数值过高,并且微调后的性能出现了下降,所以该剪枝率无法作为分级授权的剪枝率使用。在剪枝率分别为2%、7%和10%的时候,Fine_acc分别为91.20%、81.50%和73.60%。三项中的Prun_acc都在10%左右,符合分发时模型性能低的要求,并且经过微调后模型的性能增长,所以我们根据Fine_acc的高低分别设置Level1到Level3的等级。在分级的选择时,我们发现剪枝率为0.6%、0.7%、1%、2%和3%都符合Prun_acc低并且Fine_acc高的要求,但是分别对这几个剪枝率对应的值比较得出。当剪枝率为0.6%时,虽然Fine_acc数值高但是对应的Prun_acc的数值也高。当剪枝率为3%时,虽然剪枝后的模型Prun_acc较低,但是Fine_acc与剪枝率为2%的Fine_acc比更低。所以综合比较之间这几个剪枝率的效果,选定2%的剪枝率作为level1等级对应的剪枝率。实验中三个等级之间的准确率之差都在10%左右。

在DesNet-40中,使用了固定的剪枝率剪枝并利用不同的微调率对模型微调,同时使用CIFAR-100数据集进行训练获取数据。在表2中模型剪枝后的准确率较低,微调后的模型性能能够产生明显的分级效果。其中微调范围小于0.5时模型的准确率都在70%以上。根据Fine_acc从高到低我们将其以此划分为Level1、Level2、Level3和Level4,这四个等级之间相差的准确率都在5%左右。

3.3 不同分级下的图像分类实验结果与分析

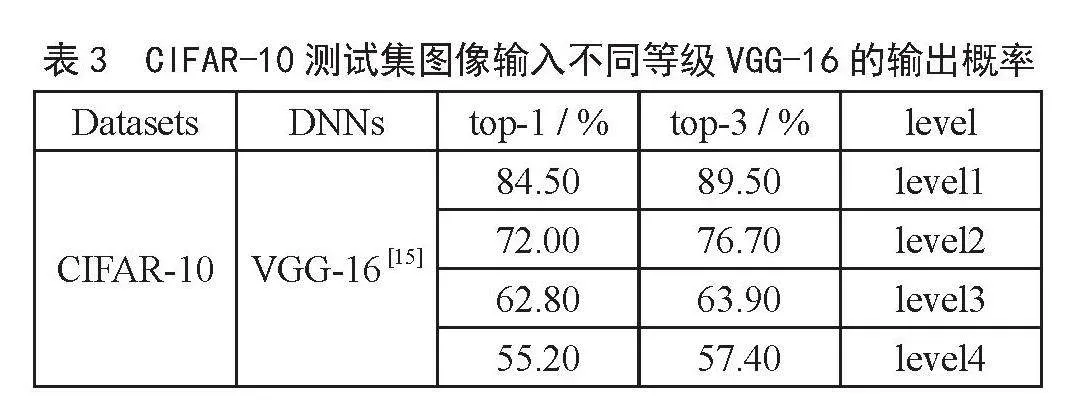

针对不同的level的选择,除了选取不同Fine_acc还需要考虑图片在各类别的输出概率。以CIFAR-10中第8个分类为例,第八类为“马”,对应的标签为“7”。将该分类图像输入到VGG-16中进行分类,分类的结果如表3所示。在该分类中本文采用了两种计算准确率的方式。top-1只选取概率最高的类别作为分类结果,若最高概率的分类标签不是“7”则认为分类错误;top-3选取概率最高的三个类别作为分类结果,若这三个分类的标签中不包含“7”则认为分类错误。

从表3中可以看出,分级等级越低,图片输入到正确的标签概率越低,模型将其错分为其他类别的概率变大,因此,用户级别越低,模型的输出精度越小。在top-1分类情况下,各个等级之间的输出精度具有较大的差距,Level1的输出精度远大于Level2;在top-3分类的情况下,我们可以观测到Level2等级的输出精度大幅提升,但并没有超过Level1的精度。因此可以得出结论,虽然本文提出的方法是作为分级授权,但是当我们选择多个分类类别作为分类结果时,低等级的用户也会有不错的表现。本体提出的方法将不同等级下分类的每一项都实现了划分,低等级的每一项分类概率都比高等级的低。模型拥有者可以根据用户权限分发不同等级的分级模型,而不用考虑模型精度会低到无法使用的地步。

4 结 论

本文提出了一种基于结构化剪枝的深度神经网络模型分级授权框架,有效地解决了DNN模型商业使用中模型拥有者针对不同权限用户提供不同准确率模型的问题。该方法利用结构化剪枝的方法对模型进行控制,并根据模型拥有者的需求将其划分为多个等级。同时本文提出了两种不同的模型性能分级的方法,可以应对不同的场景需求。实验结果表明,该方法可以有效地控制模型并根据所有者的需求将其划分为多个等级,利用不同的阈值或剪枝率对模型剪枝和微调,以实现模型的分级授权。我们在两个数据集和多个流行的DNN模型中实验了该方法,结果表明通过本文提出的方法可以很好地对DNN模型进行分级,在多个DNN模型上都表现出了良好的分级效果。随着DNN的应用,分级授权可以在很大程度上满足模型拥有者对不同权限授权的需求。

参考文献:

[1] LIU H J,MA S,XIA D X,et al. SFANet: A Spectrum-aware Feature Augmentation Network for Visible-infrared Person Reidentification [J].IEEE Transactions on Neural Networks and Learning Systems,2023,34(4):1958-1971.

[2] LIM J H,CHAN C S,NG K W,et al. Protect, Show, Attend and Tell: Empowering Image Captioning Models with Ownership Protection [J].Pattern Recognition,2021,122(8):108285.

[3] RONNEBERGER O,FISCHER P,BROX T. U-Net: Convolutional Networks for Biomedical Image Segmentation [J/OL].arXiv:1505.04597 [cs.CV].(2015-05-18).https://arxiv.org/abs/1505.04597v1.

[4] KRIZHEVSKY A,SUTSKEVER I,HINTON G E. ImageNet Classification with Deep Convolutional Neural Networks [J].Communications of the ACM,2017,60(6):84–90.

[5] ABDEL-HAMID O,MOHAMED A-R,JIANG H,et al. Convolutional Neural Networks for Speech Recognition [J].IEEE/ACM Transactions on Audio,Speech,and Language Processing,2014,22(10):1533-1545.

[6] ABDEL-HAMID O,MOHAMED A-R,JIANG H,et al. Applying Convolutional Neural Networks Concepts to Hybrid NN-HMM model for Speech Recognition [C]//2012 IEEE International Conference on Acoustics,Speech and Signal Processing (ICASSP).Kyoto:IEEE,2012:4277–4280.

[7] SENNRICH R,HADDOW B,BIRCH A. Neural Machine Translation of Rare Words with Subword Units [J/OL].arXiv:1508.07909 [cs.CL].(2015-08-31).https://arxiv.org/abs/1508.07909v5.

[8] WANG L N,SONG Y F,ZHU Y J,et al. A framework for Deep Neural Network Multiuser Authorization Based on Channel Pruning [J].Concurrency and Computation:Practice and Experience,2023,35(21):e7708.

[9] LIU Z,LI J G,SHEN Z Q,et al. Learning Efficient Convolutional Networks through Network Slimming [C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice:IEEE,2017:2755-2763.

[10] HAN S,POOL J,TRAN J,et al. Learning Both Weights and Connections for Efficient Neural Networks [C]//NIPS15:Proceedings of the 28th International Conference on Neural Information Processing Systems.Cambridge:ACM,2015:1135-1143.

[11] HE Y H,ZHANG X Y,SUN J. Channel Pruning for Accelerating very Deep Neural Networks [C]//2017 IEEE International Conference on Computer Vision(ICCV).Venice:IEEE,2017:1398-1406.

[12] TIAN J Y,ZHOU J T,DUAN J. Probabilistic Selective Encryption of Convolutional Neural Networks for Hierarchical Services [C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Nashville:IEEE,2021:2205-2214.

[13] LUO Y,FENG G R,ZHANG X P. Hierarchical Authorization of Convolutional Neural Networks for Multi-user [J].IEEE Signal Processing Letters,2021,28:1560-1564.

[14] KRIZHEVSKY A,HINTON G. Learning Multiple Layers of Features from Tiny Images [EB/OL]. [2024-01-03].https://www.researchgate.net/publication/306218037_Learning_multiple_layers_of_features_from_tiny_images.

[15] SIMONYAN K,ZISSERMAN A. Very Deep Convolutional Networks for Large-scale Image Recognition [J/OL].arXiv:1409.1556 [cs.CV].(2014-09-04).https://arxiv.org/abs/1409.1556.

[16] HE K M,ZHANG X Y,REN S Q,et al. Deep Residual Learning for Image Recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas:IEEE,2016:770-778.

作者简介:宋允飞(1999—),男,汉族,山东枣庄人,硕士在读,研究方向:深度神经网络模型版权保护。

收稿日期:2024-01-25

基金项目:中央引导地方科技发展专项项目(QKZYD〔2022〕4054);贵州省教育厅自然科学研究项目(QJJ〔2023〕011);贵州师范大学学术新秀基金项目(QSXM〔2022〕31)

Implementation of a Hierarchical Authorization Method for Deep Neural Networks Based on Model Pruning

SONG Yunfei

(School of Big Data and Computer Science, Guizhou Normal University, Guizhou 550025, China)

Abstract: Based on the problem that existing Deep Neural Networks models cannot be hierarchically authorized according to the usage authority, a novel hierarchical authorization method for DNN models is designed and proposed, which can distribute different model accuracies according to different model permissions. The method realizes model performance grading based on the model pruning technique, which uses a specific pruning rate or pruning threshold to prune and fine-tune the model. By adjusting the model during the pruning and fine-tuning stages, the model outputs different levels of accuracy. Finally different user privileges are matched with the corresponding level of accuracy. Experiments are conducted on multiple datasets and DNN models and validated by using CIFAR-10 and CIFAR-100 datasets. The experimental results show that the method is effective in grading the performance of the model and works well on several DNN models.

Keywords: Deep Neural Networks; hierarchical authorization; copyright protection; model pruning