摘" 要:针对高分辨率影像的船舶细粒度目标检测分类任务中类内差异大、类间相似性高、物体和场景的尺度变化范围大、特征提取困难、样本小等特点,提出了一种基于YOLOv8为基础的改进算法。首先,在骨干网络中引入SimAM注意力机制,使得模型在复杂背景中更加聚焦船舶对象;其次,在颈部引入SPD-Conv模块,改善复杂背景下船舶尺度变化大和小目标检测的问题;最后针对细粒度船舶目标检测的特点,替换Mish激活函数和Focal-Loss损失函数,加快模型收敛,提高模型精度。经对比实验可知,改进的算法在保证检测速度和模型参数量的同时,在FAIR1M_Ship数据集取得了94.49%的检测精度,与目前流行的目标检测算法相比,在检测精度上有一定的提升。

关键词:船舶;目标识别;遥感图像;细粒度识别;YOLOv8

中图分类号:TP751 文献标识码:A 文章编号:2096-4706(2024)22-0025-06

Ship-YOLOv8: A Lightweight Ship Fine-grained Detection Algorithm of High-resolution Remote Sensing Images

Abstract: Aiming at the characteristics of large intra-class differences, high similarity between classes, large scale changes of objects and scenes, difficulty in feature extraction, and small samples in the ship fine-grained target detection and classification task of high-resolution images, an improved algorithm based on YOLOv8 is proposed. Firstly, the SimAM Attention Mechanism is introduced into the backbone network to make the algorithm model more focused on the ship object when running in the complex background. Secondly, the SPD-Conv module is introduced in the neck to improve the problems of large ship scale changes and small target detection in complex backgrounds. Finally, for the characteristics of fine-grained ship target detection, it replaces the Mish activation function and Focal-Loss loss function to speed up model convergence and improve model accuracy. Comparative experiments show that the improved algorithm achieves a detection accuracy of 94.49% in the FAIR1M_Ship dataset while ensuring the detection speed and number of model parameters. Compared with the currently popular target detection algorithms, the detection accuracy of the improved algorithm has been improved to a certain extent.

Keywords: ship; target recognition; remote sensing image; fine-grained recognition; YOLOv8

0" 引" 言

遥感目标检测是当前学者们关注和研究热点,研究方向有目标检测、弱监督目标检测、细粒度目标检测、高效目标检测、弱小目标检测等[1]。其代表性算法有YOLO[2]、SSD[3]、Retina-Net[4]、Faster R-CNN[5]、R-FCN[6]等算法。以高分辨率遥感影像数据为基础,借助深度学习目标检测算法,已在海上船舶检测领域中取得了广泛应用,Qi等人基于Faster R-CNN进行算法改进,提高了该算法的检测率和准确性[7];Liu等人提出了一种基于卷积神经网络(CNN)的增强改进算法,对小规模船舶检测精度有待优化提高[8];Wu等人基于改进后的YOLOv7设计了一种多尺度特征融合模块,小型船舶识别检测的合适选择[9]。Jiang等人针对在合成孔径雷达(SAR)图像中定位定向船舶目标,提出一种基于长边分解旋转边界框编码的检测方法应用于CenterNet模型后有助于模型的收敛性,极大缓解了漏检问题[10]。李斌等人提出了一种基于YOLOv8的改进算法,构建一种坐标通道注意力机制模块且改进Transformer模块,减少SAR图像噪声对目标检测的干扰,但难以判断船舶目标的种类[11]。以上述学者们的研究成果为基础,本文借助YOLOv8算法的研究,在算法中引入SimAM注意力机制和SPD-Conv模块以及替换激活函数和损失函数的策略,提出一种用于高分辨光学遥感图像船舶目标细粒度检测的轻量改进算法Ship-YOLOv8,在满足模型轻量化的现实需求的同时能够实现高精度的细粒度船舶目标检测。

1" 数据与方法改进

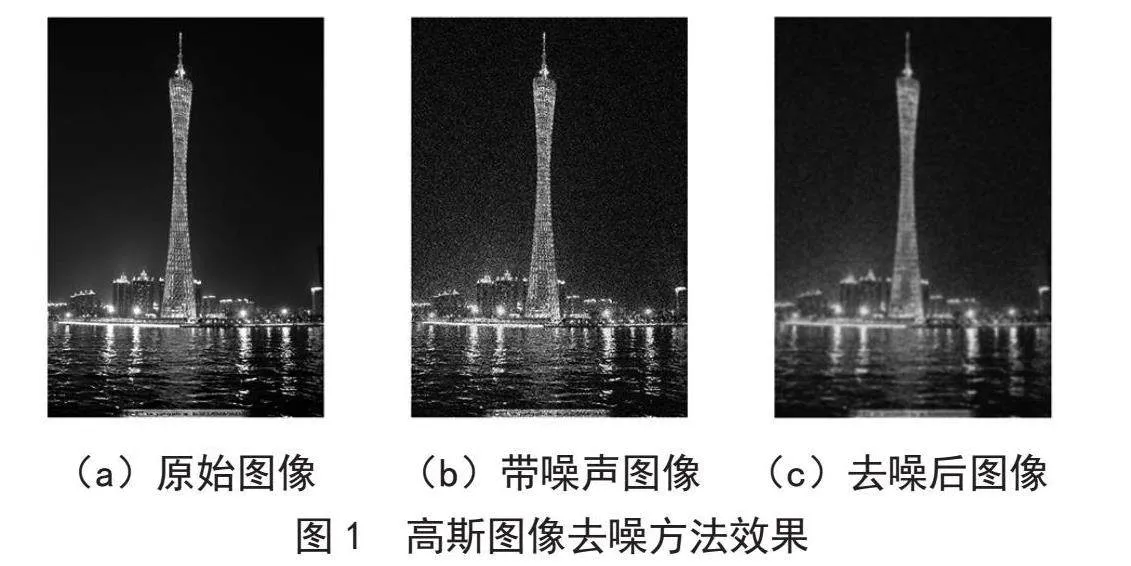

1.1" 数据预处理

通过预处理将含有船舶的数据集部分筛选出来,如表1所示,共9类船舶类型,经数据增强共有37 380张图像,采用HBB水平框的标注方式,图像分辨率在2~0.5 m之间,大小为1 500×15 000,将从FAR1M数据集[12]筛选出来的船舶数据集部分称为FAIR1M_Ship数据集。针对遥感数据的特点及研究需要,采用翻转、风格转换和Mosaic三大类型增强方法;翻转数据增强类采用随机旋转缩放、垂直及水平翻转;采用CycleGAN循环生成对抗网络进行图像风格转换数据增强。

1.2" 模型改进

1.2.1" 融合SimAM注意力机制

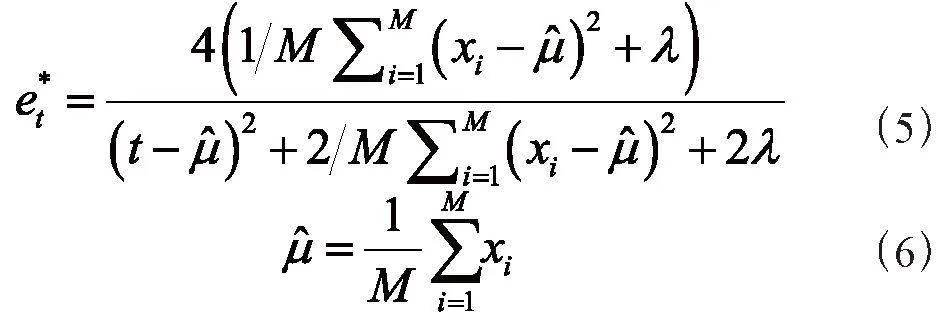

研究采用SimAM注意力机制(A Simple, Parameter-Free Attention Module)[13],将其融入YOLOv8的主干网络中的C2f结构与SPPF结构之间。每个神经元的能量函数表示如下:

式中,t和xi为输入特征X∈RC×H×W,i为空间维度的索引,M = H×W为每个通道的神经元数量,变换权重和偏置wt和bt表示如下:

其中,此处的平均值是计算通道中除了t外的所有神经元的均值,根据式(4)可得最小能量为:

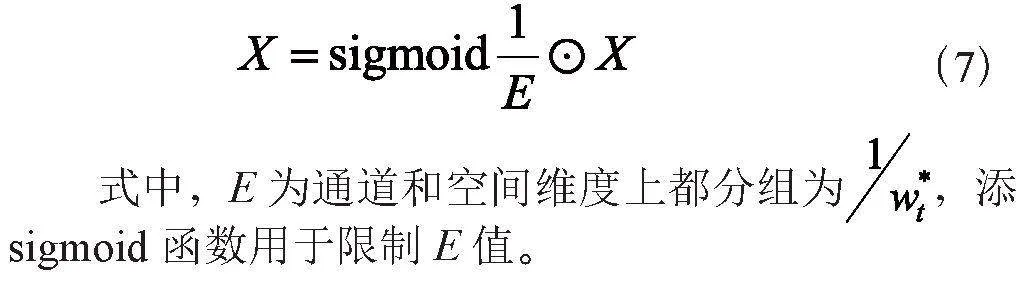

假设特征图的所有像素具有相同的分布,基于式(6),每个神经元的权重为

因此,SimAM注意力机制可表示为:

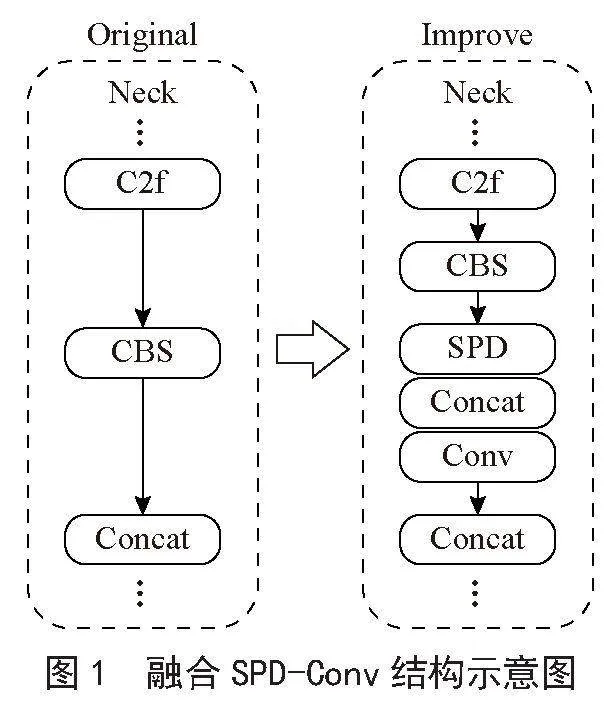

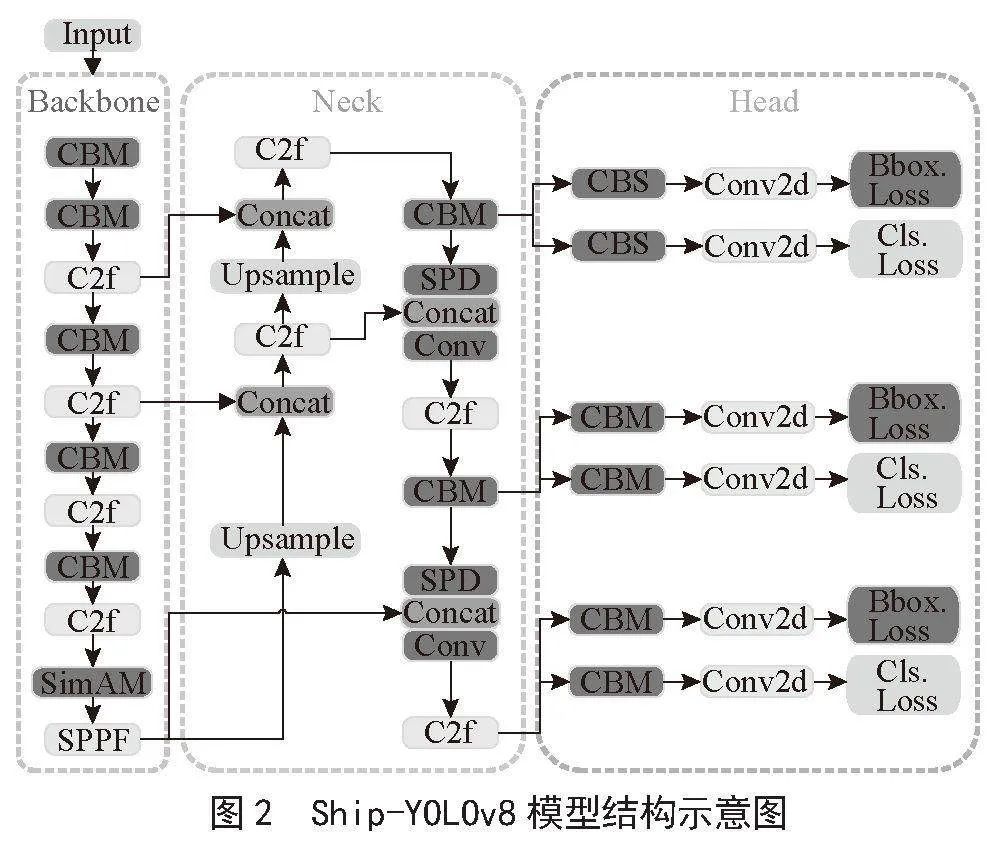

1.2.2" 添加SPD-Conv模块

本研究引入SPD-Conv模块改善高分辨率下的细粒度小目标检测,如图1、图2所示。在YOLOv8的颈部(Neck)中融合SPD-Conv模块[14],SPD-Conv模块是由空间到深度(SPD)层和非跨步卷积(Conv)组成,用于替代现有的CNN结构中的步长卷积和池化层。该层作用是调整特征图的通道数,尽可能地保留所有的判别性特征信息。因此,SPD-Conv模块能够提高模型对中低分辨率图像和小目标的检测性能,并降低对良好质量的图像的输入依赖,可提高模型的鲁棒性和实用性。

1.2.3" Mish激活函数

构成YOLOv8中卷积模块的三个基本层包括:执行卷积运算的二维卷积层(Conv2d),实施数据归一化的批量归一化层(BatchNorm2d),以及引入非线性变换的SiLu激活函数。SiLU(Sigmoid Linear Unit)激活函数[15]是一种非线性的激活函数,对于较大或较小的输入值,SiLU激活函数接近线性,这使得模型能更快的学习线性关系,在模型训练的初始阶段,YOLOv8算法通过使用预训练模型,能够更早地实现收敛,并在较少的epoch内达到最高精度的检测效果。在FAIR1M_Ship数据集进行训练时,基于FAIR1M_Ship数据集中观察到的非线性特征和SiLU函数在处理梯度饱和方面的性能差,采用了Mish激活函数[16]。

1.2.4" Focal-Loss损失函数

样本不均衡是细粒度目标检测任务常见的问题之一,因此在本研究中更换YOLOv8模型的CIoU损失函数[17]为焦点损失函数(Focal-Loss)[18],缓解样本不均衡造成模型性能下降。使用公式表示如下:

式中,FL(pt)为Focal-Loss,(1-pt)γ为调制因子,pt为模型对样本正确类别的预测概率,γ为焦点因子。

2" 结果分析

2.1" 消融实验

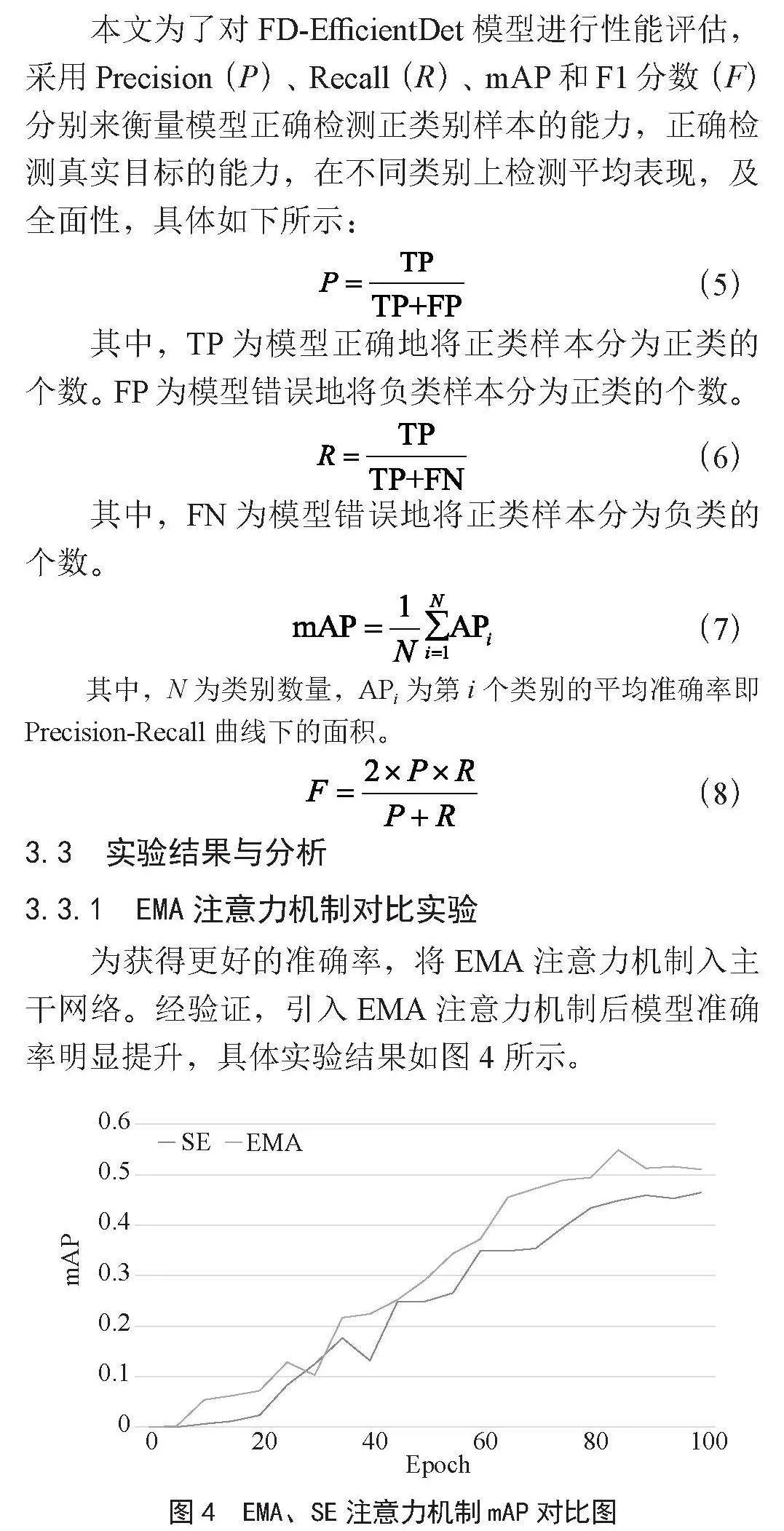

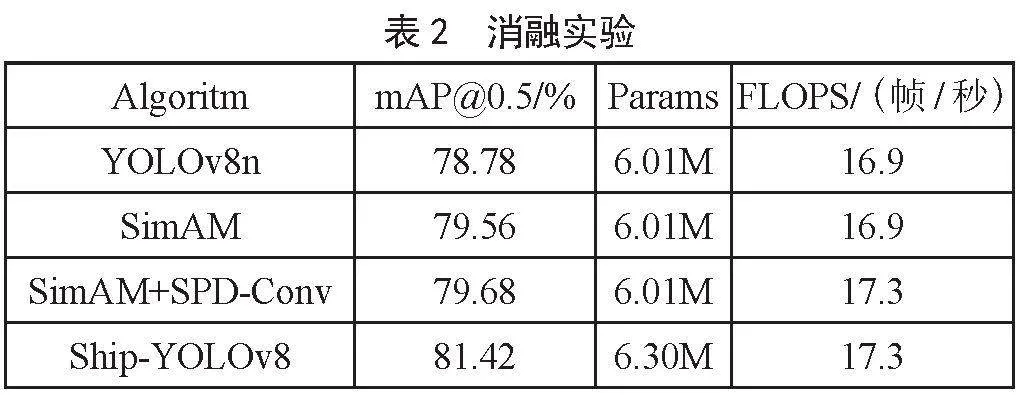

为了检验研究所开发的Ship-YOLOv8模型优化版本的性能,在FAIR1M_Ship数据集上随机抽取10%的数据量作为消融实验的数据集。使用预训练的基础模型和提出的改进各部分,在保持相同的测试环境及模型超参数下,设计了消融实验,消融实验结果如表2所示。

由表2可知,原始未加入任何改进模块的YOLOv8模型在mAP@0.5下的检测精度为78.78%;在原始YOLOv8基础下加入SimAM注意力模块,使得模型更加关注检测对象本身,抑制无效的背景信息。在保持模参数量精度和测试速度的同时,使得检测精度有所提升,其检测精度为79.56%,提高了0.78%;第三组模型则是在第二组加入SimAM注意力模块的基础上,添加SPD-Conv小目标检测模块,该模块提高了模型对中低分辨率和小目标的检测性能。进而使得模型精度提高了0.9%。Ship-YOLOv8则是本文的改进算法,在第三组模型的基础上进行了激活函数和损失函数的替换,其检测精度与原始的YOLOv8相比,提高了2.64%。该结果证明了Ship-YOLOv8模型改进的成功。

2.2" 比较实验

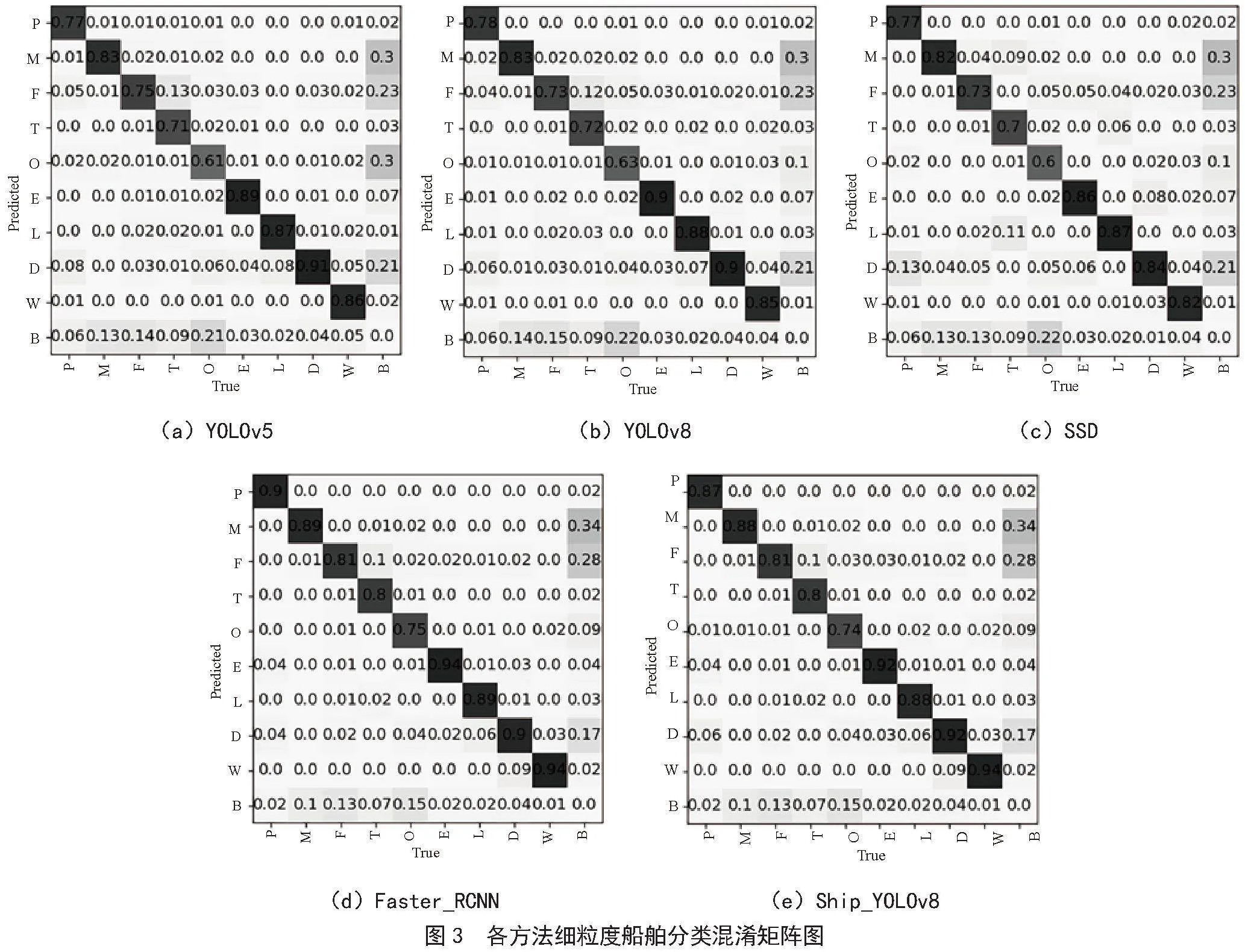

为了探究Ship-YOLOv8模型在高分辨遥感影像舰船目标细粒度分类方面的优势,基于FAIR1M_Ship数据集的测试集部分,选择了目前计算机视觉领域主流的目标检测模型/算法 YOLOv5、YOLOV8、SSD、Faster_RCNN进行比较实验,实验结果如表3所示。

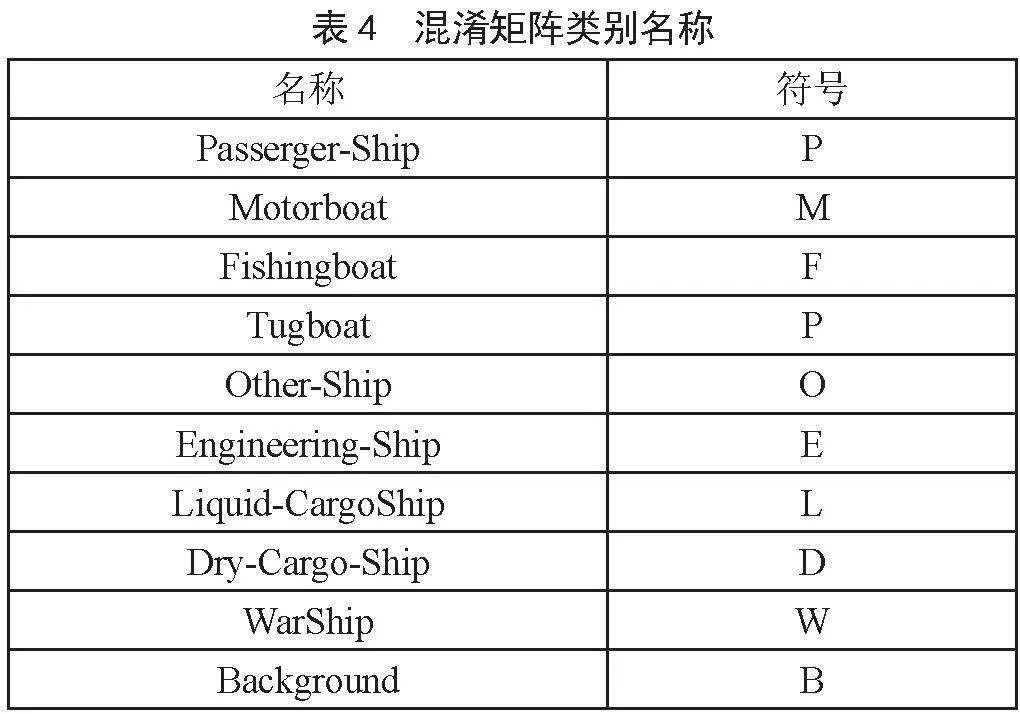

整体而言,Ship_YOLOv8模型在FAIR1M_Ship测试集上的mAP@0.5/%为94.49%,跟其他两阶段YOLOv5、YOLOV8基准模型相比,取得了最高的检测精度,在所有测试模型仅次于Faster_RCNN模型,但Faster_RCNN模型整体参数量较大,达到了335.06 M。Ship_YOLOv8模型能保持较少网络参数的同时实现更快更高的模型精度。各方法细粒度船舶分类混淆矩阵图如图3所示,混淆矩阵类别名称如表4所示。

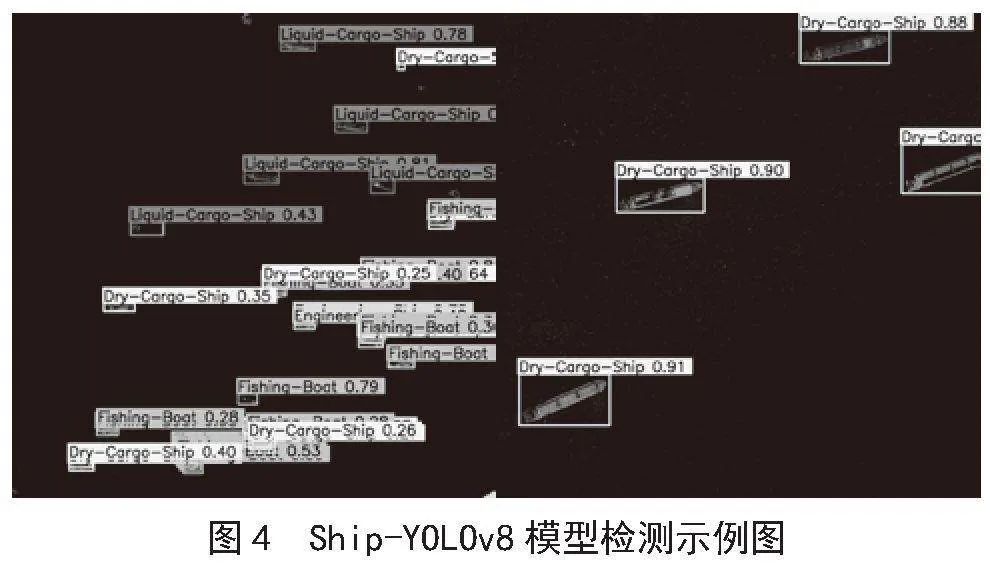

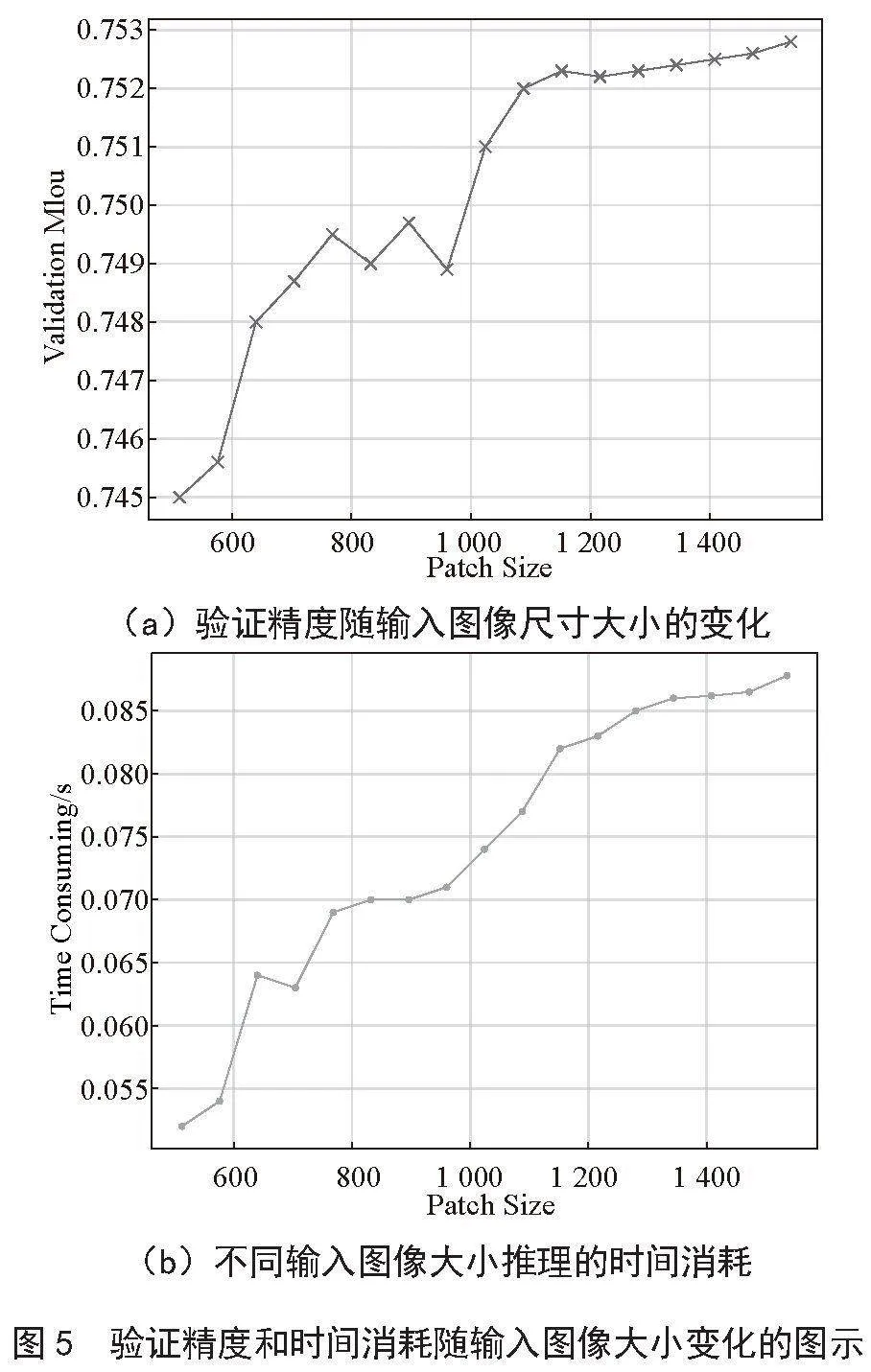

在细粒度船舶分类的评估中,检测精度被划分为三个等级,以反映不同的识别准确度。WarShip、Dry-Cargo-Ship、Liquid-Cargo-Ship、Engineering-Ship和Motorboat属于易检测的类别,各测试模型检测分类精度均能达到80%以上。Passenger-Ship、Fishing-Boat则与易检测类别相比,属于易难检测类别,YOLOv5、YOLOV8和SSD在该类别上检测精度70%~80%间浮动。而Tugboat、Other-Ship是较为难检测的类别,除Faster-RCNN和Ship-YOLOV8模型外,均是60%~70%的检测分类精度,而Ship-YOLOv8该两类的检测精度均能超过75%,进一步证明了算法改进的有效性,检测结果、时间与精度分析图,如图图4、图5所示。

3" 结" 论

与YOLOv5、YOLOv8、SSD和Faster_RCNN算法相比,文章提出的SimAM注意力机制和数据增强方法能更好的处理船舶目标与背景的纹理、边缘和其他信息。其中SPD-Conv模块能增强低质量图像与小目标检测,Mish激活函数在处理非线性特征方面优于SiLU,Focal-Loss激活函数则是针对FAIR1M_Ship数据集各类别样本不均衡而优化的。研究中评估了Ship-YOLOv8模型对输入图像的敏感性,从模型的检测精度和效率出发可知,分析了步长为64从512到1 536图像尺寸。因此迭代模型200次并计算及验证mAP@0.5的值进行分析。如图5评估结果所示,随着输入图像尺寸的增强,mAP@0.5精度也随之增加,检测精度保持在较高水平。

针对目前复杂场景下光学遥感图像船舶目标检测存在的不足进行了分析,并以YOLOv8算法为基础,针对检测难点进行了模型结构的改进,通过在骨干网络上增加SimAM注意力机制,另外在模型的Neck中融合SPD-Conv模块用于改善小目标的检测,再者用Mish激活函数和Focal-Loss损失函数替换了原有的函数,有效加快了模型的收敛速度,并显著提升了检测精度。经对比实验可知,文章所提的Ship-YOLOv8算法可有效提高光学遥感图像船舶目标细粒度检测精度,在FAIR1M_Ship数据集上,mAP达到了94.49%,优于现有同类型的目标检测算法,具有一定泛用性,具有推广应用价值。

参考文献:

[1] 廖育荣,王海宁,林存宝,等.基于深度学习的光学遥感图像目标检测研究进展 [J].通信学报,2022,43(5):190-203.

[2] REDMON J,DIVVALA S,GIRSHICK R,et al. You Only Look Once:Unified, Real-time Object Detection [C]//2015 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE,2015:6517-6525.

[3] LIU W,ANGUELOV D,ERHAN D,et al. SSD: Single Shot Multi-box Detector [C]//14th European Conference on Computer Vision.Cham:Springer,2016:21-37.

[4] LIN T Y,GOYAL P,GIRSHICK R,et al. Focal Loss For Dense Object Detection [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(2):318-327.

[5] GIRSHICK R,DONAHUE J,DARRELL T,et al. Rich Feature Hierarchies For Object Detection and Semantic Segmentation [C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:580-587.

[6] REN S,HE K,GIRSHICK R,et al. Faster R-CNN: Towards Real Time object Detection with Region Proposal Networks [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[7] QI L,LI B Y,CHEN L K,et al. Ship Target Detection Algorithm Based on Improved Faster R-CNN [J/OL].Electronics,2019,8(9):959(2019-08-27).https://www.mdpi.com/2079-9292/8/9/959.

[8] JIANG X Q,XIE H T,CHEN J X,et al. An enhanced CNN-enabled Learning Method for Promoting Ship Detection in Maritime Surveillance System [J/OL].Ocean Engineering,2021,235:109435(2021-07-06).https://doi.org/10.1016/j.oceaneng.2021.109435.

[9] WU W,LI X,HU Z,et al. Ship Detection and Recognition Based on Improved YOLOv7 [J].Computers, Materials amp; Continua,2023,76(1).489-498.

[10] JIANG X,XIE H,CHEN J,et al. Arbitrary-oriented Ship Detection Method based on Long-edge Decomposition Rotated Bounding Box Encoding in SAR Images [J/OL].Remote Sensing,2023,15(3):673(2023-01-23).https://www.mdpi.com/2072-4292/15/3/673.

[11] 李斌,雷钧涵,郭毅.基于CCA和Transformer的YOLOv8船舶目标检测算法 [J].控制工程,2024,31(5):901-911.

[12] SUN X,WANG P,YAN Z,et al. FAIR1M: A Benchmark Dataset for Fine-grained Object Recognition in High-resolution Remote Sensing Imagery [J].ISPRS Journal of Photogrammetry and Remote Sensing,2022,184:116-130.

[13] YANG L,ZHANG R Y,LI L,et al. Simam: A Simple, Parameter-free Attention Module for Convolutional Neural Networks [C]//International Conference on Machine Learning.PMLR,2021:11863-11874.

[14] SUNKARA R,LUO T. No More Strided Convolutions or Pooling: A New CNN Building Block for Low-resolution Images and Small Objects [C]//Joint European Conference on Machine Learning and Knowledge Discovery in Databases.Cham:Springer Nature Switzerland,2022:443-459.

[15] ELFWING S,UCHIBE E,DOYA K. Sigmoid-weighted Linear Units for Neural Network Function Approximation in Reinforcement Learning [J].Neural Networks,2018,107:3-11.

[16] MISRA D. Mish:A Self Regularized Non-monotonic Activation Function [J].arXiv:1908.08681 [cs.LG].(2019-08-23).https://arxiv.org/abs/1908.08681.

[17] ZHENG Z,WANG P,LIU W,et al. Distance-IoU Loss: Faster and Better Learning for Bounding Box Regression [C]//Proceedings of the AAAI Conference on Artificial Intelligence.AAAI,2020:12993-13000.

[18] LIN T Y,GOYAL P,GIRSHICK R,et al. Focal Loss for Dense Object Detection [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,42(2):318-327.