摘" 要:针对口罩佩戴检测中存在的面部交叉遮挡时检测困难、光线明暗目标检测精度低等问题,借助YOLOv5算法,提出了一种能够实时检测是否规范佩戴口罩的检测技术,通过实验验证了该模型在无明显遮挡,光照条件良好条件下,检测准确率较高,验证了方法的有效性,该方法可适用于动物是否佩戴口罩。通过实验给出了口罩可检测与人脸遮挡边界、光强之间的关系。

关键词:深度学习;YOLOv5算法;目标检测;口罩检测

中图分类号:TP391.4" 文献标识码:A" 文章编号:2096-4706(2024)23-0122-06

Mask Detection Method and Implementation in Multi-type Scenarios Based on YOLOv5

HAN Mingwei, HU Bin, WANG Mengyu, LI Ji, CHENG Zijia

(Brunel London School North China University of Technology, Beijing" 100144, China)

Abstract: To address the problems existing in the mask-wearing detection that the detection is difficult with facial cross-occlusion and the object detection accuracy of bright and dark lights is poor, with the help of YOLOv5 algorithm, this paper proposes a detection technology that can detect whether the mask is worn with standardization in real time. Through experiments, it is verified that the model has a relatively high detection accuracy under the conditions of no obvious occlusion and good lighting, which verifies the effectiveness of the method. This method is also applicable for detecting whether animals are wearing masks. Through experiments, the relationships between mask detection and face occlusion boundaries and light intensity are given.

Keywords: Deep Learning; YOLOv5 algorithm; Object Detection; mask detection

0" 引" 言

伴随气温多变,流感、支原体、呼吸道等病毒传播严重危害人民生命安全。面对病毒传播,最简单有效的方法是正确佩戴口罩,检测是否正确佩戴口罩已成为研究的热点和重点。目前,口罩检测主要是通过目标检测方法实现的,它是在图像中准确定位和识别口罩等目标,同时确定目标位置。目标检测方法可以用于快速、准确地检测口罩是否正确佩戴,利用深度学习方法对人脸进行口罩佩戴情况检测,可以极大改善人工检查成本高、效率低、主观差异大等问题。针对传统的口罩检测识别任务,存在以下问题:首先,研究局限于检测是否佩戴口罩,是否规范佩戴口罩研究较少;其次,目标检测过程存在遮挡等情形,导致检测是否佩戴口罩情况成为难点;最后,场景的光强大小严重影响目标检测的准确率。为了解决上述问题,本文在YOLOv5算法基础上进行改进,提出了一种可实时检测是否规范佩戴口罩的口罩检测技术,通过实验确定了准确检测口罩佩戴情况时的遮挡边界及光强范围。

深度学习目标检测算法运用卷积神经网络自动提取目标特征,发展历程可以根据检测过程的不同,分为两阶段(Two-Stage)算法和单阶段(One-Stage)算法[1]。两阶段算法首先提取图像中可能含有目标的候选区域,然后再候选区域内进行回归,得到检测结果。单阶段算法直接通过回归的方式获取待测目标的具体位置和类别信息,输入图像后,检测过程由一个网络完成,直接输出 bounding box 和分类标签。

2012年,卷积神经网络(Convolutional Neural Networks)在ImageNet分类任务上战胜传统视觉方法。2014年Girshick等人[2]提出R-CNN目标检测网络,即区域卷积神经网络,在目标检测领域第一次应用深度学习的算法并实现了质的飞跃,R-CNN(Regions with Convolutional Neural Networks)在VOC2007数据集的平均检测精度(mAP)达到了58.5%,相较于传统方法提高了近25%。然而,该方法的回归过程显著耗费时间和内存资源。5 000张图像训练需要长达84个小时,产生100 GB以上的特征文件。单张图像的检测过程耗时50秒。2015年,Girshick等人[3]改进了该方法,提出了Fast R-CNN目标检测网络,该网络通过对网格结构进行优化及融合优点,实现了目标分类和候选框回归的同步进行。训练时间减少到9.5小时,mAP达到66.9%,检测一张图仅需0.3秒。

为解决目标检测网络顶层特征语义信息丰富但是位置信息缺失的问题,2017年Lin[4]等人提出了特征金字塔网络(Feature Pyramid Network, FPN),FPN通过改变网络连接的方式,在不同层次的特征图上构建特征金字塔,采用了自顶向下和自底向上的特征融合机制。在小目标识别上,FPN直接将目标识别的召回率提高了13%,在大/中型物体上的召回率也提高了4%~5%。

2016年Joseph等人提出了YOLO算法,作为深度学习时代第一个正式的单阶段目标检测器,该方法完全抛弃了两阶段检测中的“区域建议+回归”模式,而是采用一阶段的端到端处理。其最显著的优点是检测速度快,检测速度可以达到45 frame/s,然而,该模型的检测精度会稍有不足。2016年底,为了解决YOLOv1版本中召回率较低的问题,Redmon等人[5]提出了YOLOv2算法。采用了Darknet-19作为骨干网络,引入批量归一化层,简化参数调整过程并产生了正则化效果。2018年,Redmon等人[6]提出的YOLOv3引入了残差网络模块和更强大的Darknet53,采用类似于FPN特征融合策略以更好地适应不同尺度的目标,但YOLOv3在处理小尺寸、低对比度或密集目标时,可能存在检测精度较低的问题。之后YOLOv4,YOLOv5不断推出,性能不断提高,特征提取和融合能力逐步提升,速度快且精度高,适用于实时检测并可部署到移动端。

李雨阳[7]等人基于SSD(Single Shot MultiBox Detector)算法,利用特征金字塔网络与协对算法的分类分数和IoU分数进行合并,在损失函数中引人QFL损失,解决了算法中正负样本不平衡的问题,比原始SSD算法检测速度降低了2.4 frame/s,平均检测速率提高至28.9 frame/s,但对于佩戴口罩的实时性检测效果略差。针对复杂密集场景下口罩佩戴检测对于小目标检测效果差的问题,李小波[8]等人提出了引入注意力机制融合多尺度特征的检测算法,该研究在YOLOv5s模型的Backbone部分分别引入SE(Squeeze-and-Excitation module),CBAM(Convolu-tional Block Attention Module),CA(Coordinate Attention)和NAM(Normalization-based Attention Module)4种注意力机制,这些机制增强了模型对特征图中关键信息的关注,有助于更好地表达特征信息,从而提升了网络模型的mAP指标,但速度有所下降。随着目标检测的不断发展以及各研究之间的互相启发,口罩佩戴情况检测的算法需求越来越高。

1" YOLOv5 架构

1.1" YOLOv5框图

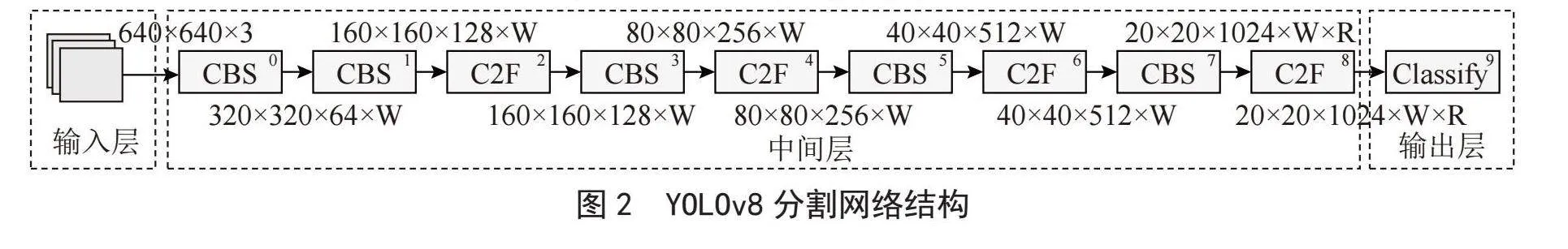

YOLOv5主要由Backbone、Neck和Head三部分组成,网络模型如图1所示[9]。其中Backbone 主要负责对输入图像进行特征提取。Neck负责对特征图进行多尺度特征融合,并把特征传递给预测层。Head进行最终的回归预测。

1.2" 性能指标定义

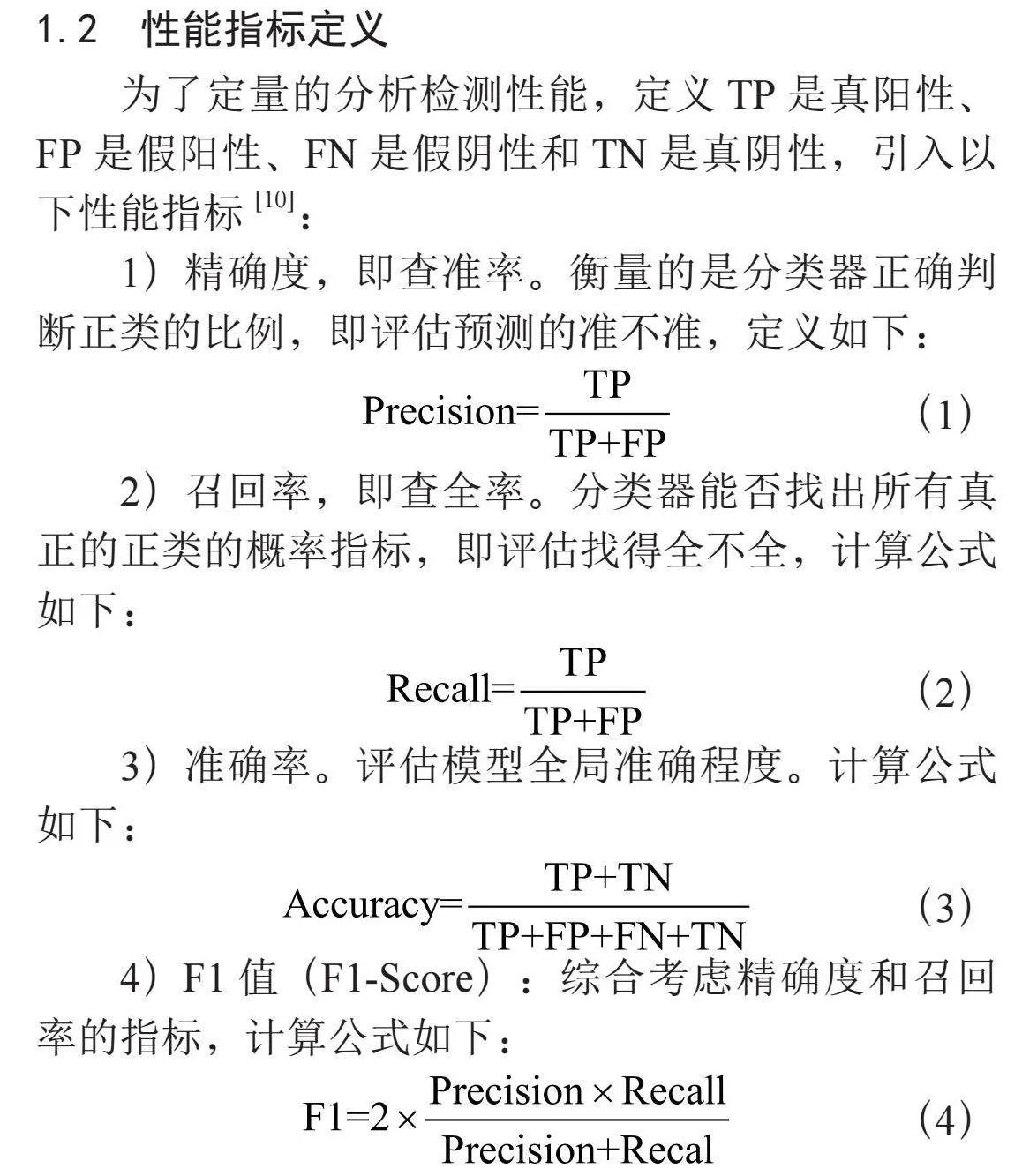

为了定量的分析检测性能,定义TP是真阳性、FP是假阳性、FN是假阴性和TN是真阴性,引入以下性能指标[10]:

1)精确度,即查准率。衡量的是分类器正确判断正类的比例,即评估预测的准不准,定义如下:

(1)

2)召回率,即查全率。分类器能否找出所有真正的正类的概率指标,即评估找得全不全,计算公式如下:

(2)

3)准确率。评估模型全局准确程度。计算公式如下:

(3)

4)F1值(F1-Score):综合考虑精确度和召回率的指标,计算公式如下:

(4)

2" 实验设计与分析

2.1" 数据集介绍

鉴于当前公开数据集关于口罩佩戴检测的样本相对匮乏,存在错误标注或遗漏的问题,且人脸与口罩区域的占比相对较大,降低了检测的精度和模型泛化能力。为了更真实地检测各种场景下的口罩佩戴情况,本文自建了一个口罩检测数据集,包括从MAFA筛选的图像和网络搜索的补充图像,共7 267张。

MAFA是一个遮挡人脸检测数据集,由中国科学院葛等人于2017年开源发布。数据集总共包含30 811张图像,35 806个遮挡人脸,呈现各种朝向和遮挡程度,且每张图像中最少有一个人脸被遮挡。本文共筛选了6 000张口罩遮挡的图像,同时网络搜集图像共计1 267张口罩图像作为数据集补充,其中包括儿童佩戴口罩,多遮挡佩戴口罩等。

2.2" 数据集处理

2.2.1 图片标注

对于数据中部分没有标签的和自行收集的数据,本文使用LabelImg工具对这部分图片进行人工标注。每个标签对应一个序号,序号0代表“佩戴口罩(masked)”,序号1代表“未佩戴口罩(unmasked)”,序号2代表“不规范佩戴口罩(nonstandard-masked)”。标注中将佩戴口罩时露出口、鼻或下巴视为不规范佩戴。在终端输入labelImg相关命令打开标注界面,选择要进行标注的文件,拖动鼠标手动创建图片中人脸口罩佩戴的矩形区块,输入正确的分类标签。按照VOC标注文件存放路径保存至指定文件夹,标注信息为xml文件,标注过程中图形界面如图2所示。

2.2.2" 格式转换

MAFA数据集是以Labelling格式进行类别标注,并以xml文件的形式存储相应的标注信息。但在YOLO算法中,为了便于YOLO算法训练时的输入和处理及提高训练时的调用效率,需要将xml格式的标签文件转换为更为简单的YOLO格式的txt格式。本研究人工标注了2 094张图片,数据集标注完成后,共有7 267张图片,其中佩戴口罩目标数为3 516,未佩戴口罩目标为2 136。不规范佩戴口罩目标数为1 615。同时为了提升模型的训练效果,本文采用8:1:1将整个数据集划分训练集、验证集和测试集。

2.3" 评估模型指标

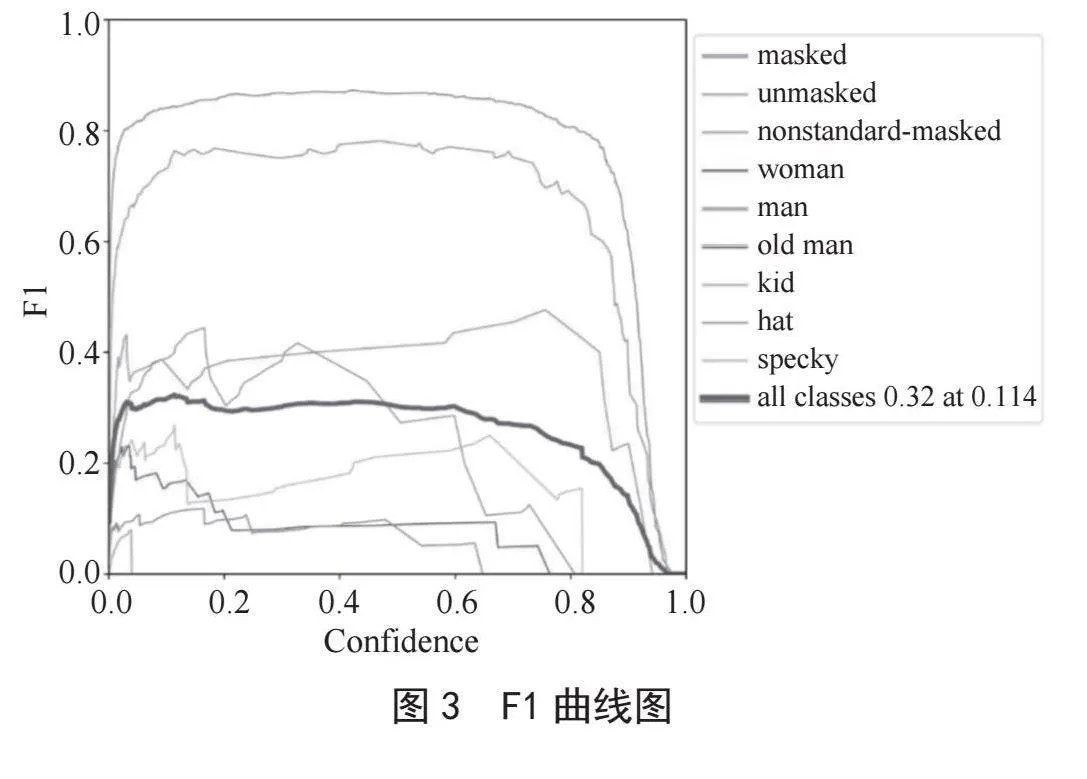

本文使用YOLOv5算法对7 267张图片进行训练150轮次,并绘制F1曲线和PR(Precision-Recall)曲线评估训练出的模型性能好坏,F1分数是精确度和召回率的调和平均值,它提供了模型在正例和负例之间平衡的度量,综合考虑了模型的准确性和全面性。如图3所示,可观察到“masked”“nonstandard-masked”“unmasked”等标签的F1值较为显著,同时曲线的整体趋势更为平稳,表明模型对这些标签的识别效果较为出色。

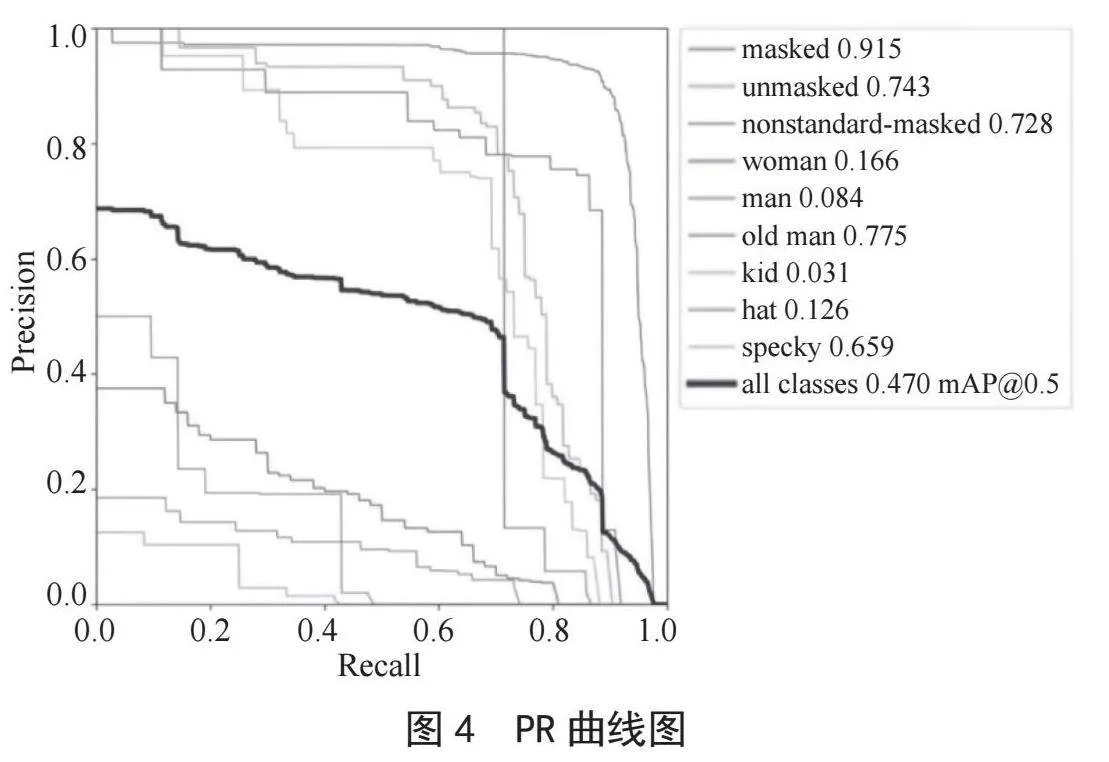

PR曲线是评估分类模型性能的一种常用工具,它以模型的精确度(Precision)和召回率(Recall)为坐标轴绘制出的曲线图,曲线越靠近右上角,表示模型的性能越好,因为此时精确度和召回率都较高。如图4所示,“masked”“nonstandard-masked”“unmasked”等标签的识别效果较为显著。然而,“nonstandard-masked”标签的AP值较高,但其对应的PR曲线并不十分规范。这可能是由于某些类别的样本可能过少,或者被分布在数据集的某些特定部分,或者对于某些类别,模型可能没有捕捉到足够的特征信息,导致出现偏差。

3" 口罩检测实验结果与分析

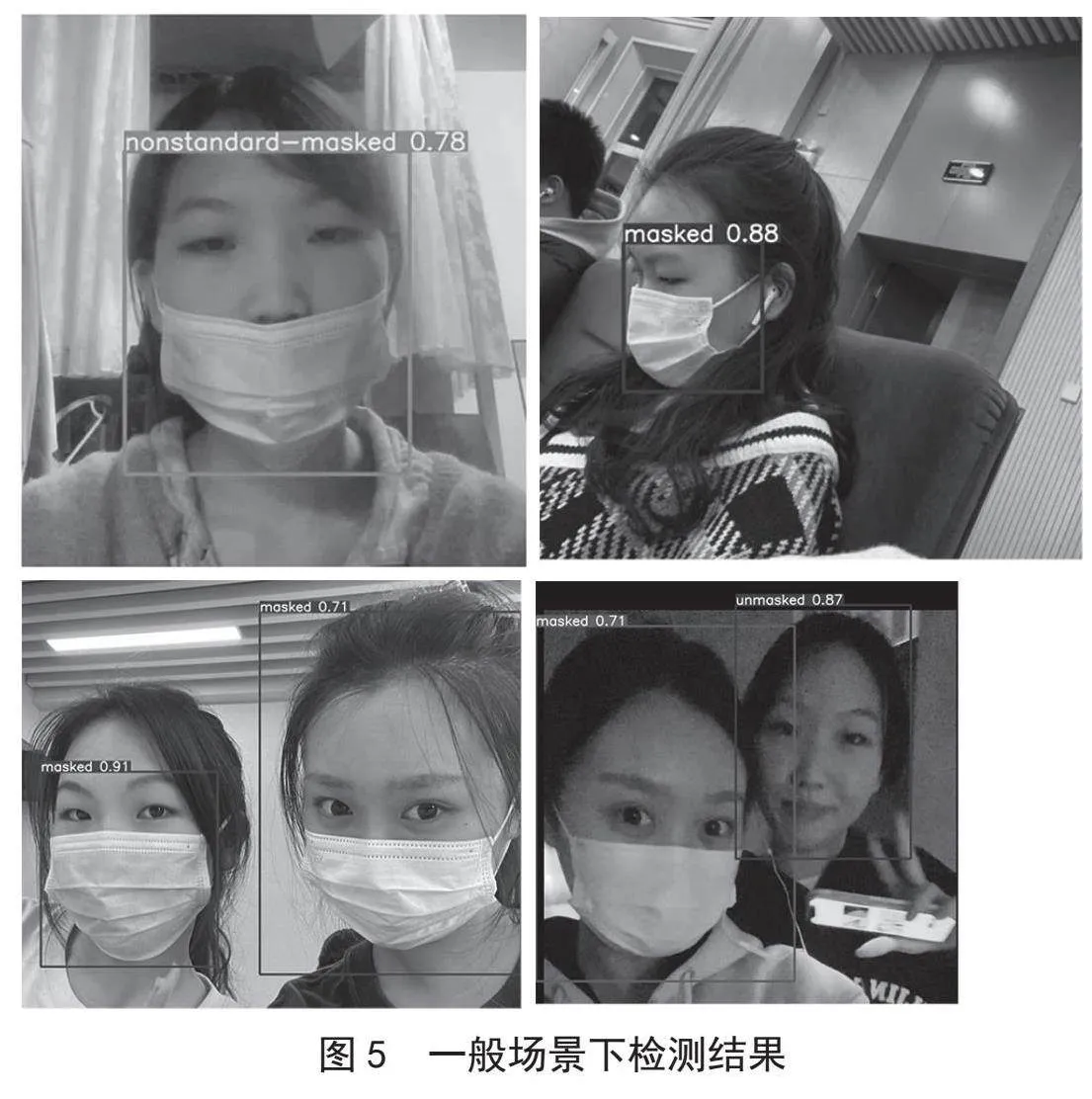

3.1" 无明显遮挡,光照条件良好条件下口罩检测

对于正常环境下,该模型能够清楚地识别目标是否规范佩戴口罩,并给出相应的概率,识别结果如图5所示。

从图中可以明显观察到,YOLOv5模型在口罩佩戴情况的识别方面表现出卓越的准确性和可靠性。其识别能力不仅能够准确判断人们是否佩戴口罩,而且对于佩戴标准的判定也十分精准。实验结果显示,对于清晰的图片和略有模糊的图片,模型的识别概率高达0.70以上,凸显了其在口罩检测任务中的稳健性和可信度。此外,该模型在多人场景下也展现出优异的检测能力,能够有效地应对多类型场景。

3.2" 动物口罩佩戴检测

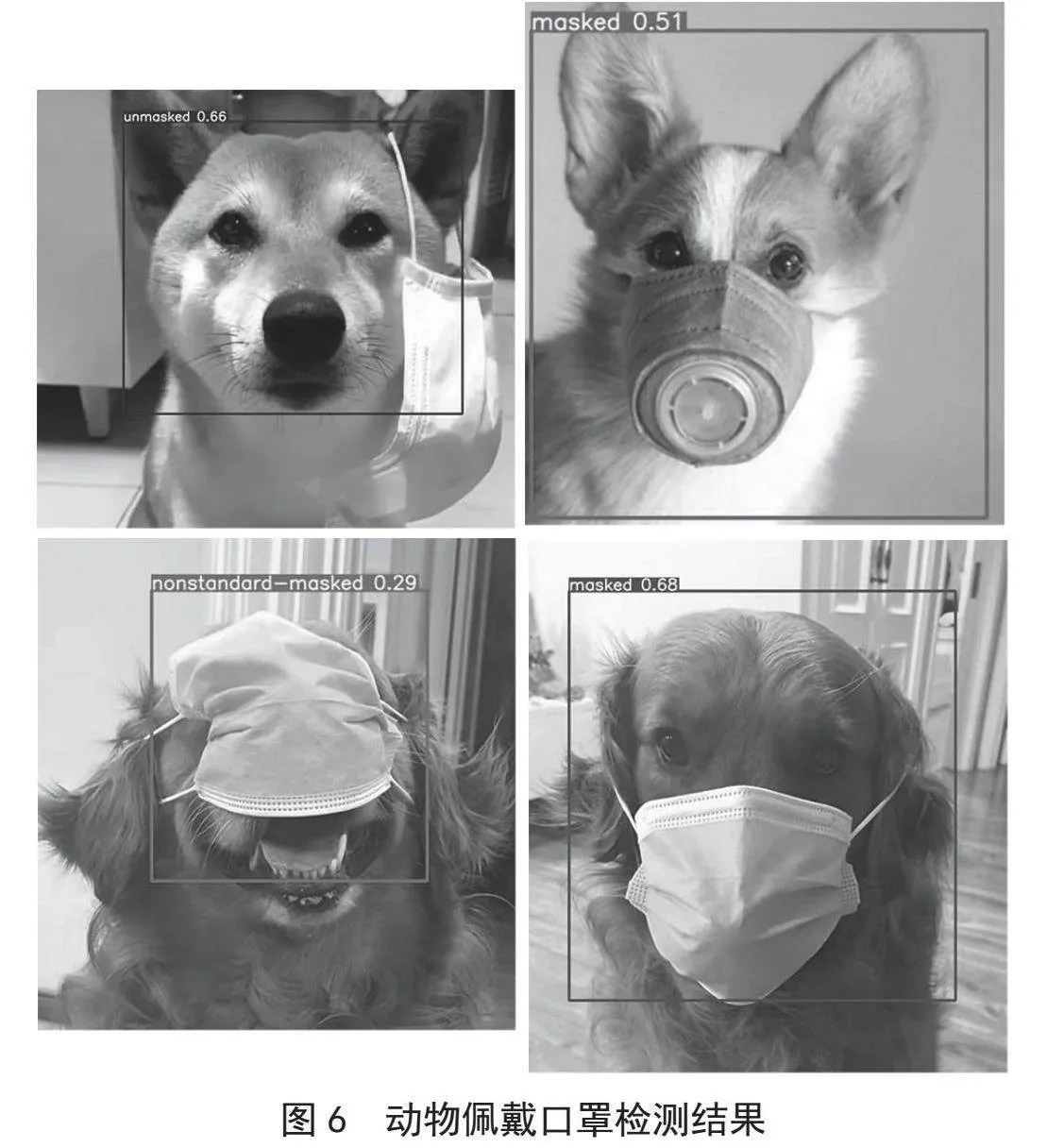

本文将人类口罩检测方法迁移到宠物口罩检测。通过对宠物口罩佩戴情况的检测,可以进一步加强对于宠物健康和安全的关注,针对宠物医疗机构或公共场所等特定,宠物口罩的佩戴可能具有重要意义。具体检测结果如图6所示。

可以看出,相较于识别人佩戴口罩,该模型识别动物的概率相对较低,左上图检测出0.66的概率该动物未佩戴口罩,右上图检测出有0.51的概率该动物佩戴了口罩,左下图该动物不规范佩戴口罩的概率为0.29,而右下图该动物佩戴口罩的概率为0.68,但其也能基本识别动物是否标准佩戴口罩,对于特定的动物口罩也有一定的识别能力。

3.3" 人脸部分遮挡情形下的口罩检测

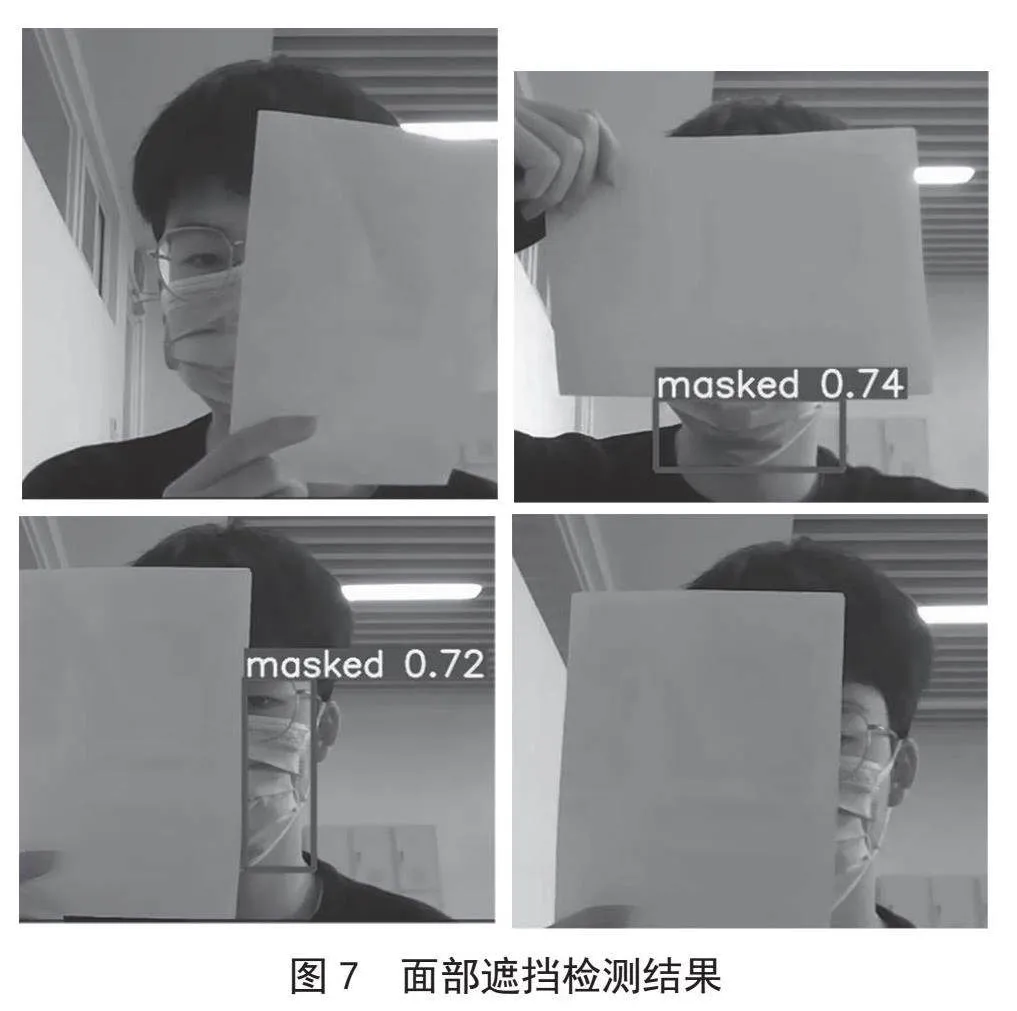

考虑到口罩佩戴存在人脸部分遮挡情况,重点研究确定遮挡边界与口罩检测关系上。本文使用白纸遮挡不同面积以及从不同角度的遮挡,以探索模型在遮挡边界方面的表现,检测结果如图7所示。

右上图当遮挡面积为头像面积的60%时,检测出佩戴口罩的概率为0.74,左下图表示当遮挡面积为头像面积的25%时,检测出佩戴口罩的概率为0.72,而当右下图遮挡面积为80%时,该模型无法检测出是否佩戴口罩。研究结果显示,遮挡边界在头像面积的80%以上时,模型将无法准确判断是否佩戴口罩。

3.4" 多类型光照条件下的口罩检测

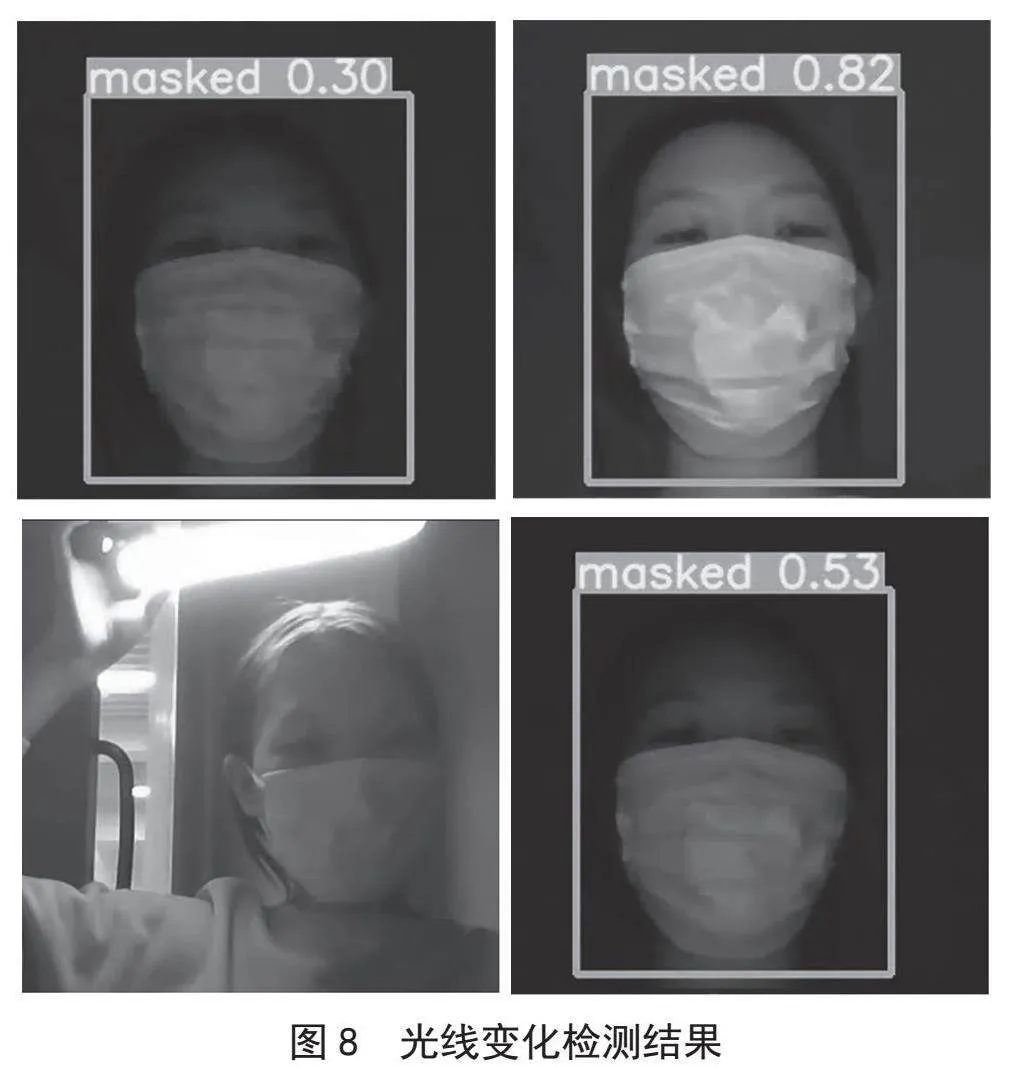

为探究不同光线强度对该模型检测准确性的影响,借助可变强度光源和光强测试软件,在光强变化的开展口罩佩戴情况检测,包括3类光照条件:弱光(0~50 Lux)、正常光(50~1 000 Lux)和强光(大于1 000 Lux),判断模型检测的光照边界范围,具体结果如图8所示。

在光线由弱到强的过程中,当光强达到11 Lux时,屏幕中开始能够检测到佩戴口罩,如左上图概率为0.3;当光强达到1 297 Lux时,能够检测到口罩佩戴情况,如右上图;但当光强超过1 297 Lux时,该模型无法检测到是否佩戴口罩,如左下图;在光线由强到弱的过程中,当光强为62 Lux时,检测到佩戴口罩的概率为0.53。因此,在小于弱光11 Lux和大于强光1 297 Lux情况下,该模型基本识别不出人是否佩戴口罩,而在11~1 297 Lux之间,该模型具有很好地识别口罩的能力。

4" 结" 论

针对口罩佩戴中存在的面部交叉遮挡时检测困难、光线明暗目标检测精度低等问题,借助YOLOv5算法开展了实时检测口罩规范佩戴研究,提出了一种能够实时检测是否规范佩戴口罩的检测技术,通过实验验证了该模型对于无明显遮挡,光照条件良好条件下,检测准确率高达0.70以上。对于动物是否佩戴口罩的情况有一定的检测能力。确定了口罩可检测与人脸遮挡边界、光强之间的关系。通过实验表明,当人脸遮挡面积小于80%时,该模型可检测出口罩佩戴情况,当光照强度为11~1 297 Lux之间,该模型有很好的口罩识别能力。

参考文献:

[1] 郭庆梅,刘宁波,王中训,等.基于深度学习的目标检测算法综述 [J].探测与控制学报,2023,45(6):10-20+26.

[2] GIRSHICK R,DONAHUE J,DARRELL T,et al. Rich Feature Hierarchies For Accurate Object Detection and Semantic Segmentation [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern recognition.Columbus:IEEE,2014:580-587.

[3] GIRSHICK R. Fast R-CNN [C]//Proceedings of the IEEE International Conference on Computer Vision.Santiago:IEEE,2015:1440-1448.

[4] LIN T Y,DOLLÁR P,GIRSHICK R,et al. Feature Pyramid Networks for Object Detection [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Honolulu:lEEE,2017:2117-2125.

[5] REDMON J,FARHADI A. YOLO9000: Better, Faster, Stronger [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Honolulul:IEEE,2017:7263-7271.

[6] REDMON J,FARHADI A. YOLOv3: An Incremental Improvement [J/OL].arXiv:1804.02767 [cs.CV].(2018-04-08).https://doi.org/10.48550/arXiv.1804.02767.

[7] LI Y Y,SHEN J Q,ZHAI H X,et al. Mask Wearing Detection Algorithm Based on Improved SSD [J].Computer Engineering,2022,48(8):173-179.

[8] LI X B,LI Y G,GUO N,et al. Mask Detection Algorithm based on YOLOv5 Integrating Attention Mechanism [J].Journal of Graphics,2023,44(1):16-25.

[9] Ultralytics. YOLOv5 [EB/OL].[2024-03-20].https://github.com/ultralytics/yolov5.

[10] ZHANG D Y,LUO H S,WANG D Y,et al. Assessment of the Levels of Damage Caused by Fusarium Head Blight in Wheat Using an Improved YOLOV5 Method [J/OL]. Computers and Electronics in Agriculture,2022:107086(2022-06-09).https://doi.org/10.1016/j.compag.2022.107086.

作者简介:韩铭伟(2003—),女,汉族,山东德州人,本科在读,研究方向:大数据;胡斌(2003—),男,汉族,福建莆田人,本科在读,研究方向:大数据;王孟瑜(2003—),女,汉族,北京人,本科在读,研究方向:大数据;李继(2003—),男,汉族,重庆人,本科在读,研究方向:大数据;程子嘉(2003—),女,汉族,四川南充人,本科在读,研究方向:大数据。