关键词:车辆目标跟踪;YOLOv8;DeepSORT;Ghost卷积;轻量型;CBAM;损失函数中图分类号:TP391.4;TP301.6 文献标识码:A 文章编号:2096-4706(2025)07-0052-06

Abstract:Aiming at the issues that vehicle tracking algorithms are highlycomplex and computationally intensive in practical traficscenarios,making it diffcult toapplythem todevices withlimited resources,this paper proposesamultitargetvehicletrackingalgorithmbasedonimproved YOLOv8 + DeepSORT.AlightweightGhostNet ConvolutionalNeural Network is introduced intothe backbone network,and the Conv is replaced with GhostConv.This replacement not only ensures the lightweight natureof themodel but also improves its performance.Subsequently,by introducing the CBAMand integrating it with the Ghost convolution technology,anew GC-C2ffeature fusion module is constructed to further enhance the featureextractionability.Finallyanewlossunction,WIoU,isadoptedtoimprovethmodelsegreionacacyand convergence speed.The detectionresults ofthe improved YOLOv8 modelare usedasthe input ofthe DepSORTalgorithm toachievemulti-targetvehicletracking incomplexsituations.Experimentalresultsdemonstratethaton theKITTItraffic dataset, withoutsacrificing detection accuracy,compared with theoriginal YOLOv8+DeepSORT,the parametercountof GCWYOLO+DeepSORT is reduced by 3 5 . 9 4 % and the computational load is decreased by 2 0 . 2 5 % .This makes it more suitable for deployment on devices with limited resources and endows it with practical value.

KeyWords:vehicle target tracking; YOLOv8; DeepSORT; Ghost convolution; Lightweight type; CBAM; Loss Functic

0 引言

在国家政策的引导和大力支持下,我国计算机视觉技术迎来了快速发展的黄金时期。特别是在智能交通系统、公共安全监控、自动驾驶等领域中,基于视觉技术的多目标车辆跟踪算法成为研究的热点和重点。

在深度学习领域,多目标跟踪(MOT)方法通常可以分为两大类别,联合单目标跟踪方法和结合目标检测算法和数据关联优化算法。联合单目标跟踪器方法,即将多个单目标跟踪器集成到一个系统中。另一类方法则结合了目标检测算法和数据关联优化算法的优势,成为基于深度学习的主流多目标跟踪方法。目标检测算法(如YOLO和R-CNN)利用深度学习技术从图像中提取丰富的视觉特征,进行目标的检测和分类。随后,数据关联优化算法(如卡尔曼滤波和匈牙利算法)[2]在连续帧中进行目标的匹配和跟踪。在交通监控中,目标数量较多且目标之间可能存在交互或者遮挡的复杂场景,使得结合目标检测和数据关联优化算法的方法成为主流。Ren等人[3针对目标检测跟踪实时性和准确性的平衡问题,提出了FasterR-CNN,其结合了区域提议网络(RPN)和区域卷积神经网络(R-CNN),使用RPN生成候选区域,并通过卷积神经网络对这些区域进行分类和边框回归,显著提高了检测速度和准确性。Bochkovskiy 等人[4]对YOLOv4进行优化,结合了跨阶段部分聚合(CSP)、自适应锚点框(AA)等多种技术,有效改善了实时目标检测中的速度和准确性问题。张信等人通过改进YOLOv5+DeepSORT算法,模型通过增加注意力模块CBAM来增强特征提取能力,快速分析复杂场景中的信息,在DeepSORT算法中采用SIoULoss损失函数改进边界框定位精度,提升了模型的追踪精确度和实时性。

综合来看,以上目标跟踪算法通过在目标检测阶段增加注意力模块来增强特征提取能力,或者通过将骨干网络替换为其他复杂网络来提升目标检测的精度,从而提升目标跟踪的效果[5]。但如今不同地区交通监控设备配置不同,上述模型的复杂度较高且参数量较大,无法满足在资源有限的设备上实时性的要求。因此,本文基于上述问题,提出了YOLOv8的优化算法GCW-YOLO,使原始模型轻量化的同时,增强其特征识别和提取能力。并采用改进YOLOv8作为车辆检测算法,结合DeepSORT跟踪算法,提出一种基于改进YOLOv8+DeepSORT多目标车辆跟踪算法。相较于原始YOLOv8+DeepSORT,模型更轻量化,在减少参数和计算量的同时,保证检测精度。

1 YOL0v8模型

在深度学习的目标检测算法中YOLO(You OnlyLookOnce)是一种广泛使用的目标检测算法,在该算法提出以来经历了多个版本的改进和优化,它的检测能力和应用范围也逐步提升。YOLOv8是YOLO系列在2023年新发布的目标检测模型[,沿用该系列以往的实时处理优势,并在架构、多尺度检测能力、灵活性与可扩展性等方面进行了改进。以YOLOv8n为基线模型,其架构设计分为四个部分:输入端、骨干网络(Backbone)、颈部特征融合网络(Neck)和输出端(Head)。

输入端采用Mosaic数据增强方法,将多张输入图像进行翻转、随机缩放和色域变化等操作。这种数据增强方法扩展了训练的数据集,增加了模型的泛化能力,提升模型对小目标的检测能力,还能随机增加小目标的数量,使得模型在面对多种尺寸的目标时更具鲁棒性,能够适应实际应用中的多变场景[7]。骨干网络(Backbone)由CBS模块、C2f模块和SPPF模块组成。CBS负责从输入图像中提取基本特征,为后面的分类和定位任务提供信息。C2f模块通过跨阶段的特征连接来增强梯度流,使得模型在反向传播时可以更有效地传播信息。SPPF模块通过依次连接三个最大池化层,降低计算复杂度并保持输入特征图的空间信息。在此基础上,特征融合网络(Neck)负责对Backbone提取到的特征进行融合,使用了FPN(FeaturePyramidNetwork)和PAN(PathAggregationNetwork)结构。FPN有助于多尺度特征的有效利用,确保不同层次上提取的特征能够传递和结合,而PAN进一步增强了信息的传递能力,为头部(Head)提供了更丰富的上下文信息。输出端(Head)部分采用了解耦头结构,以缓解分类与定位任务之间的冲突。通过分别处理分类和回归任务,使模型能够更独立地优化这两项任务,提高整体性能。

2 YOL0v8改进模型

YOLOv8相较于前几个版本有显著的改进与优化,但在实际的交通环境中,设备性能或算力资源参差不齐,在一些配置较低的设备上的表现不如预期,且在复杂场景中,如车辆密集或相似目标的情况下,准确性可能受到影响。针对上述问题,对YOLOv8模型结构进行改进,将改进后的网络模型命名为GCW-YOLOv8.

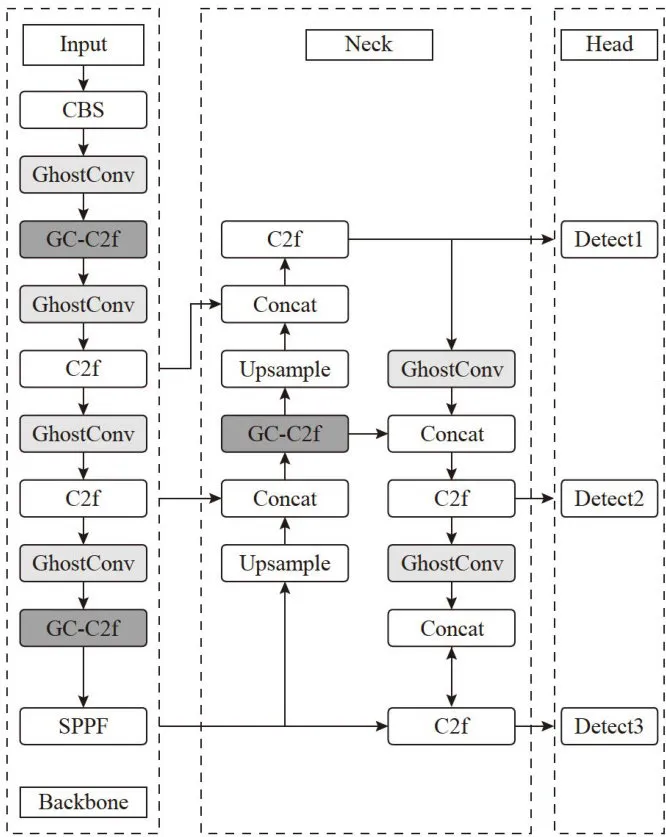

首先,针对原YOLO模型参数量大、复杂度高等问题,使用基于轻量化的卷积神经网络GhostNet,将YOLOv8n模型中普通卷积模块替换为GhostNet网络中的GhostConv模块。此举在显著降低网络的计算负担的同时保证网络的检测精度,更好地适应实际应用环境。其次,构建一种新的GC-2f模块,即使用GhostBottleneck对C2f模块中的Bottleneck模块进行替换,然后在C2f尾部加入CBAM注意力机制,记为GC-C2f模块。GC-C2f模块相较于原模块增强了模型性能,提高了对重点区域小目标检测的能力,同时降低了模型的复杂度和参数量。最后,将采用WIoU损失函数替换原本的CIoU,以提升对车辆的模型定位精度,增强模型的泛化能力,加快模型收敛,使其在硬件设备较差的环境下减轻低质量样本对训练结果的影响。GCW-YOLO的整体网络结构如图1所示。

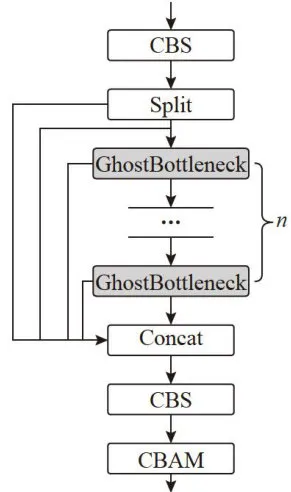

2.1 GC-C2f模块

在实际交通环境中,监控设备参差不齐且应用场景复杂,这些都会对车辆目标跟踪的实时性造成影响。然而原YOLOv8模型需要计算力较大,效率较低,不能很好地适应现实的应用场景。因此,本文设计出了一种GC-C2f特征提取模块,其具有高效且轻量的特点,在保证特征提取能力前提下能够有效降低计算复杂度。GC-C2f的结构如图2所示。

图1GCW-YOLO网络结构

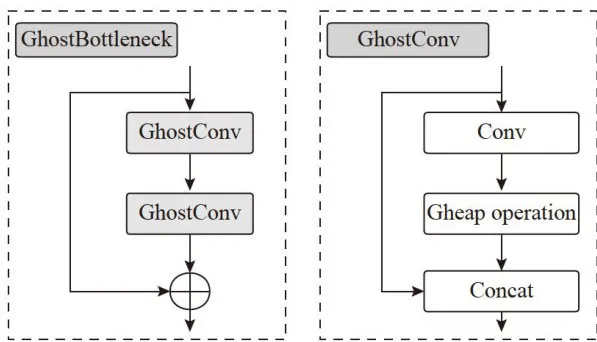

图1GCW-YOLO网络结构进行元素加法实现特征融合,增加了特征的多样性以及提高了对不同尺度物体的检测能力。原模型的C2f模块是一个较为复杂且精细的神经网络模块,它的结构由Conv卷积层、Split操作、Bottleneck模块、Concat拼接以及最终卷积层构成。因此将C2f中的Bottleneck替换为GhostBottleneck可以有效地降低卷积参数的同时获得更多的特征信息,在保证特征提取能力的情况下,使模型更轻量化。GhostBottleneck的结构如图3所示。

图3GhostBottleneck结构

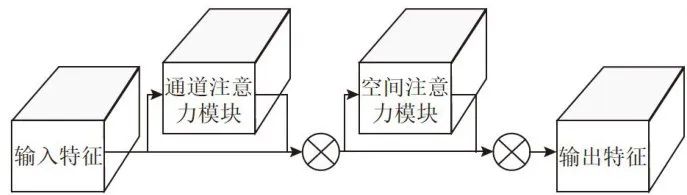

图3GhostBottleneck结构CBAM注意力机制由通道注意力模块(ChannelAttentionModule)和空间注意力模块(SpatialAttentionModule)这两个独立但串联的模块组成,使其能够在通道和空间维度对特征进行增强。首先,输入特征图通过通道注意力模块的全局最大池化和全局平均池化操作提取每个通道的最大值和平均值,然后送入全连接层学习权重,加权输入特征图的每个通道。空间注意力模块对特征图进行基于通道的全局最大池化和全局平均池化操作,提取不同上下文尺度的特征,经过卷积处理生成空间注意力权重。经过两个模块的共同作用,增强了模型对关键特征的识别能力和对重要图像区域的关注能力。综上,CBAM通过结合通道注意力机制和空间注意力机制,有效地提升特征表示能力,更好地捕捉全局和局部的重要特征,降低GhostConv生成“幽灵”特征以减少参数和计算量带来的负面影响。CBAM具体结构如图4所示。

图2GC-C2f模块

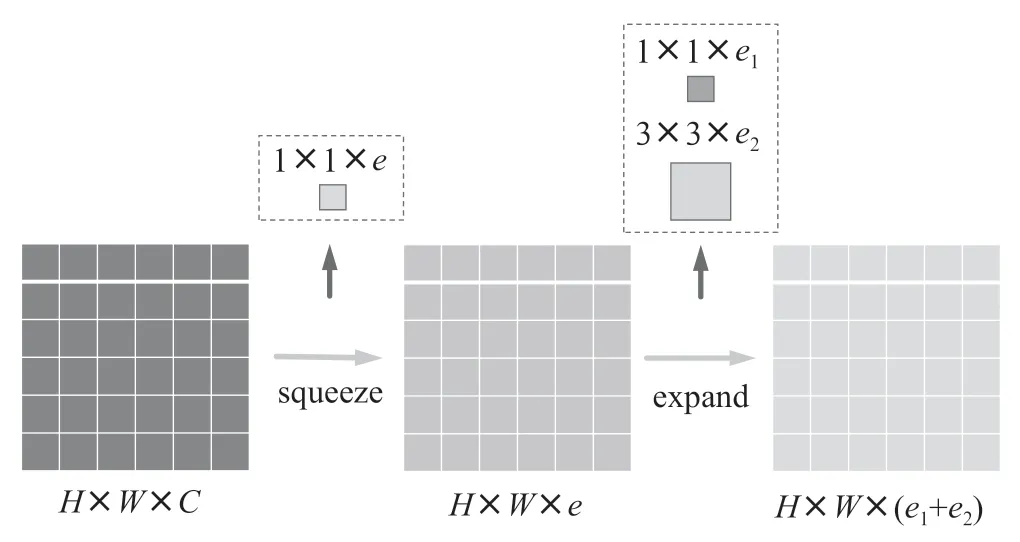

图2GC-C2f模块Ghost卷积结构是华为诺亚方舟实验室在2019年提出的轻量化卷积模块[8],它旨在利用特征图中的冗余信息通过低成本的线性变换来生成更多的特征图,使模型的计算量和参数数量能够显著地降低,从而提高模型的性能。GhostBottleneck结构是一种特殊的残差模块,它由两个GhostConv模块组成。第一个GhostConv模块作为扩展层主要是增加通道数,为后续提供更多特征信息。第二个GhostConv模块是线性变换层,它通过廉价的线性变换(如深度可分离卷积)来减少通道数,进而减少计算量。最后进行特征融合将两个GhostConv模块的通过shortcut链接

图4CBAM注意力机制

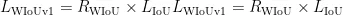

图4CBAM注意力机制2.2 WloU损失函数

CIoU损失函数在YOLOv8中广泛使用,它引入中心点距离和宽高比等因素,使在预测框与真实框不相交的情况下,仍然可以提供有效的梯度信息。但在复杂场景中,CIoU并未直接考虑对不同样本的差异化情况,在处理不同难度和大小的目标时缺乏自适应的调整机制。因此,本文使用WIoU(Wise-IoU)作为损失函数,以应对训练数据中低质量示例的影响,并减轻几何因素对模型泛化性能的负面影响[0]。WIoUv3通过引入动态非单调注意机制,利用“离群度”评估锚框质量,并设计实施梯度增益分配策略,降低了高质量锚框的竞争力,削弱了低质量样本产生的有害梯度。该策略使WIoU能够优先考虑普通质量的锚框,提高了网络模型的性能和泛化能力。通过距离度量构建距离注意力,得到具有两层注意力机制的WIoUv1,计算公式为:

其中,  ,

,  为最小的封闭框的大小。在通过引入动态非单调聚焦系数(FM)并将其应用于WIoUv1,WIoUv3实现了性能的显著提升。这种策略利用β 值来动态调整梯度增益,使得模型在训练过程中能够更加关注普通质量的锚框,同时减少低质量样本对模型训练的负面影响。其公式如下:

为最小的封闭框的大小。在通过引入动态非单调聚焦系数(FM)并将其应用于WIoUv1,WIoUv3实现了性能的显著提升。这种策略利用β 值来动态调整梯度增益,使得模型在训练过程中能够更加关注普通质量的锚框,同时减少低质量样本对模型训练的负面影响。其公式如下:

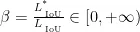

3 DeepSORT目标跟踪算法

DeepSORT算法的前身是Sort算法[1],DeepSORT算法在延续Sort算法实时多目标跟踪优势的基础上,引入了新轨迹确认和级联匹配。这使得DeepSORT不仅极大地改善了原Sort算法在处理遮挡、目标消失和重新出现等表现不佳的问题,还提高了跟踪的准确性,进而能够更准确地匹配自标和轨迹,减少ID频繁切换的情况,增强在复杂情况下跟踪的鲁棒性。

DeepSORT的匹配级联流程如下:其输入为检测结果(Detections)和跟踪轨迹(Tracks),输出涵盖确认的(Confirmed)、未确认的(Unconfirmed)、删除的(Deleted)、新的暂定(NewTracks(Tentative))等跟踪轨迹。流程上,检测结果首先进入匹配级联,借助匈牙利算法(门控余弦距离)进行匹配,从而输出匹配轨迹、未匹配检测结果以及未匹配轨迹;接着,未匹配检测结果进入IU匹配(运用匈牙利算法和IoU距离),再次输出匹配轨迹及未匹配结果;同时,跟踪轨迹会经由卡尔曼滤波来预测下一时刻的状态,而匹配轨迹则进行卡尔曼滤波更新状态估计。在状态更新方面,未确认轨迹若在一定时间内未被匹配则标记为Deleted,若连续三次被匹配到则从暂定状态变为确认状态,新的未匹配检测结果将成为新的暂定轨迹。DeepSORT匹配级联流程图[12]如图5所示。

图5DeepSORT匹配级联流程图

图5DeepSORT匹配级联流程图4实验结果与分析

4.1实验环境与数据集

为验证本文的改进算法在车辆目标跟踪场景上的性能和有效性,本实验在Windows10操作系统上进行,CPU 为 XeonPlatinum8474C,GPU 为 NVIDIACeForceRTX  ,使用Python3.9版本,CUDA11.8,PyTorch2.0深度学习框架。采用KITTI车辆相关的公开交通数据集来训练YOLOv8n网络。在模型训练阶段,设置初始学习率为0.01,输入的图片尺寸为 6 4 0 × 6 4 0 ,采用的动量参数为0.937,训练轮数为200轮,采用batchsize64。其中引入动量可以使SGD平滑参数更新过程,减少震荡,并且还可以帮助优化器在相关方向上加速收敛,突破局部最优。

,使用Python3.9版本,CUDA11.8,PyTorch2.0深度学习框架。采用KITTI车辆相关的公开交通数据集来训练YOLOv8n网络。在模型训练阶段,设置初始学习率为0.01,输入的图片尺寸为 6 4 0 × 6 4 0 ,采用的动量参数为0.937,训练轮数为200轮,采用batchsize64。其中引入动量可以使SGD平滑参数更新过程,减少震荡,并且还可以帮助优化器在相关方向上加速收敛,突破局部最优。

本文所采用的数据集来自KITTI公开交通数据集[13],它由德国卡尔斯鲁厄理工学院携手美国芝加哥丰田技术研究院构建,数据集涵盖了市区、乡村和高速公路。但由于KITTI数据集中信息数量繁多,其中一些相似度过高的视频图片容易导致训练结果出现过拟合现象。因此本文对原始的数据集进行了数据处理和重新分类,最终得到了7000多张图像作为本文的数据集,用于训练YOLOv8网络。

4.2 评价指标

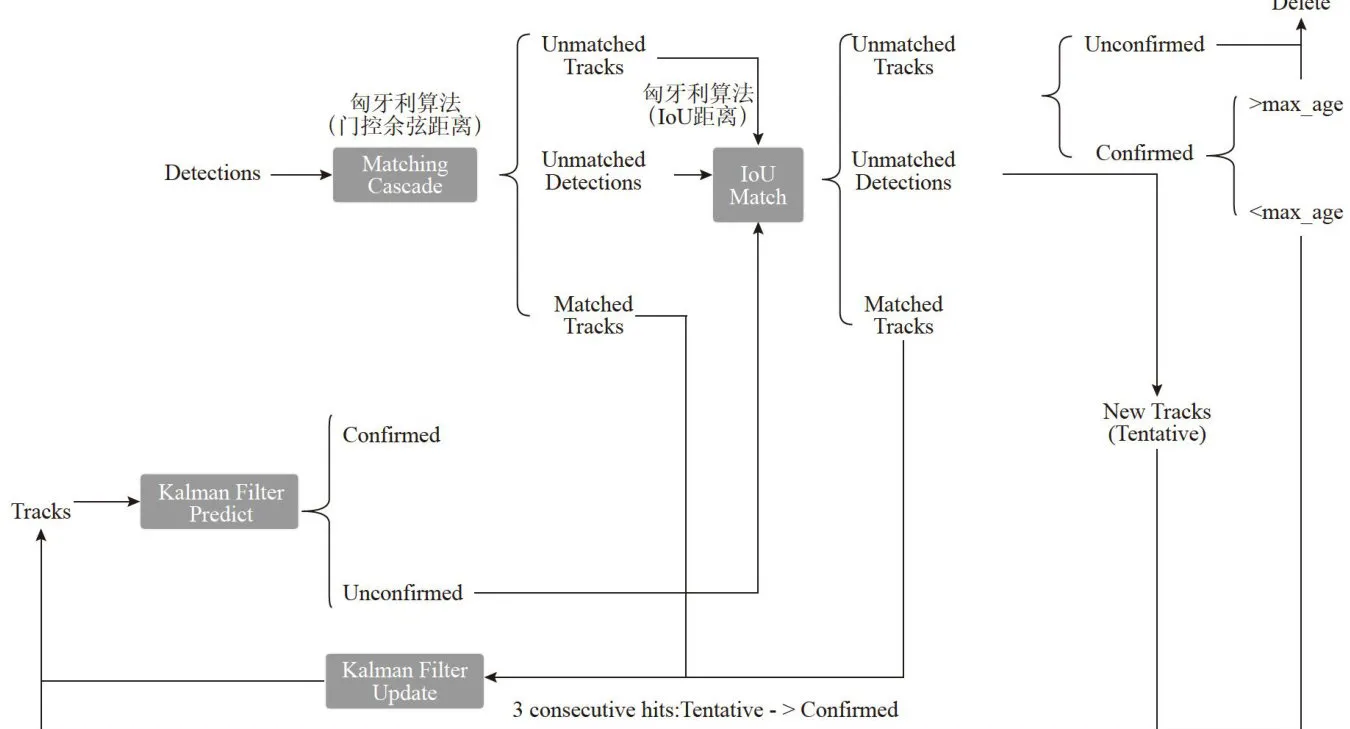

本文的评价指标有:精准率 ( P / % ) ,召回率 ( R % ) !总平均精度 ( m A P@ 0 . 5 / % )来评估模型均值,参数量(Parameters)和模型复杂度(GFLOPs)来评估模型大小和计算复杂度。消融实验结果如表1所示。

表1GCW-YOL0消融实验结果

表1GCW-YOL0消融实验结果由上述消融实验结果可知,引入Ghost卷积以及GC-C2f模块替换原始的C2f模块后,GhostConv通过常规卷积生成少量的固有特征图,然后基于固有特征图,通过线性操作生成更多的Ghost特征图,从而在损失较少信息的情况下,大大减少了卷积核的数量,进而降低了参数量和模型复杂度,CBAM通过结合通道注意力机制和空间注意力机制,有效地提升特征表示能力,更好地捕捉全局和局部的重要特征,降低由GhostConv减少参数和计算量带来的负面影响,从而提高模型精准度。使模型相较于原始YOLOv8n参数量下降 3 5 . 9 4 % 、模型复杂度下降 2 0 . 2 5 % ,且精准率、召回率分别仅下降了 0 . 1 1 % 和 0 . 0 2 % ,总平均精度上升了 0 . 0 7 % ,说明GC-C2f和Ghost卷积在保证特征提取能力的前提下,显著地降低了参数数量以及模型复杂度。最后引入WIoU损失函数,其实施梯度增益分配策略,降低高质量锚框的竞争力,削弱低质量样本产生的有害梯度,使模型的损失值更小、收敛更快,使模型的精准度进一步提高。GCW-YOLO相较于原始YOLOv8n,参数量下降 3 5 . 9 4 % 、模型复杂度下降 2 0 . 2 5 % ,模型的平均精度提高 0 . 8 % ,证明了本文改进模型的有效性。

4.3改进YOL0v8和DeepS0RT目标跟踪算法结果

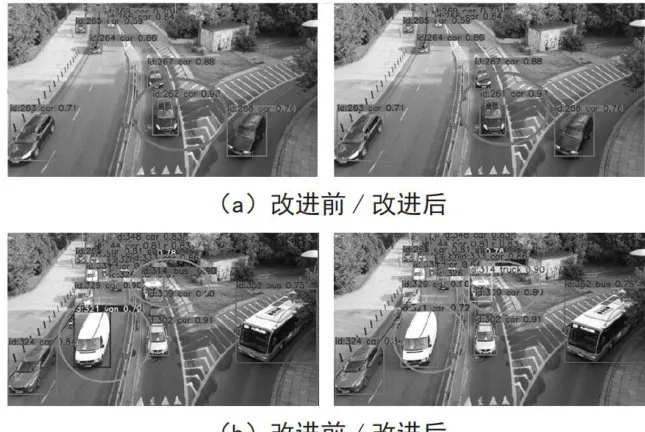

在原YOLOv8和DeepSORT目标跟踪算法中,由于多种原因如:光线、物体遮挡等导致误检。如图6(a)为视频第4秒因光照原因车辆从光线较亮处进入阴影处导致车辆ID改变,改进前红圈中的车辆id为262,改进后id为261。图6(b)为视频第11秒改进前左下角红圈中的车辆因速度较快且车辆外观较大类型识别为van,中部的红圈里的卡车因其他车辆的遮挡导致的车辆类型识别为bus,改进后红圈内的车辆类型均识别正确。可以得出改进的YOLOv8+DeepSORT算法通过引入更强大的GC-C2f特征提取模块来增强对遮挡情况下车辆特征的提取能力,能够很好的应对复杂环境下因背景噪声,遮挡等负面因素影响,减少了车辆ID的变化,有效解决车辆跟踪过程中的实时性与跟踪准确率问题,在车辆升了车辆跟踪效果,具备良好的实用性。跟踪实验对比如图6所示。

(b)改进前/改进后图6跟踪实验对比图

(b)改进前/改进后图6跟踪实验对比图5结论

本文采用改进的YOLOv8与DeepSORT算法相结合,对道路上行驶的车辆进行实时的检测和跟踪,首先将YOLOv8的骨干网络中的普通卷积网络替换为轻量级的Ghost卷积网络,降低了模型的复杂度和计算量,其次将C2f模块中Bottleneck部分替换为GhostBottleneck,并在GhostBottleneck尾部引入CBAM注意力机制,使其在保证效率的同时可以更精确地识别目标车辆,并采用WIoU损失函数,该函数能够减少低质量样本对模型训练的负面影响。最后,将改进的YOLOv8检测算法和DeepSORT跟踪算法结合来完成多目标车辆跟踪。根据实验结果可知,该方法能够提高车辆跟踪的效果,保证精度的同时实现车辆目标跟踪的轻量化。

参考文献:

[1]GIRSHICKR,DONAHUEJ,DARRELLT,etal.Rich FeatureHierarchiesforAccurateObjectDetectionandSemanticSegmentation[C]//2014IEEEConferenceon ComputerVision and Pattern Recognition.Columbus:IEEE,2014:580-587.

[2]蔡秀梅,王妍,卞静伟,等.多目标跟踪数据关联算法综述[J].西安邮电大学学报,2021,26(2):77-86.

[3]RENS,HEK,GIRSHICKR,etal.FasterR-CNN:Towards Real-Time Object Detection with Region ProposalNetworks[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2017,39(6):1137-1149.

[4] BOCHKOVSKIY A,WANG C-Y,LIAO H-Y M.YOLOv4:Optimal Speed and Accuracy of Object Detection[J/OL].arXiv:2004.10934 [cs.CV].[2024-12-03].https://arxiv.org/abs/2004.10934.

[5]蒲玲玲,杨柳.改进YOLOv5的多车辆目标实时检测及跟踪算法[J].科学技术与工程,2023,23(28):12159-12167.

[6]李猛坤,袁晨,王琪,等.基于改进YOLOv8算法的在线听课行为识别模型研究[J].计算机工程,2025,51(1):287-294.

[7]张利丰,田莹.改进YOLOv8的多尺度轻量型车辆目标检测算法[J].计算机工程与应用,2024,60(3):129-137.

[8]HANK,WANGY,TIANQ,etal.GhostNet:More Features from Cheap Operations[C]//Proceedings of the IEEE/ CVF Conference on Computer Vision and Pattern Recognition. Seattle:IEEE,2020:1580-1589.

[9]WOO S,PARKJ,LEEJY,et al.CBAM: ConvolutionalBlockAttentionModule[C]//Proceedingsofthe European Conference on ComputerVision(ECCV).Munich: Springer,2018:3-19.

[10]TONG Z,CHENY,XUZ,etal.Wise-IoU: Bounding Box Regression Loss with Dynamic Focusing Mechanism[J/OL].arXiv:2301.10051[cs.CV].[2024-12-05]. https://arxiv.org/abs/2301.10051.

[11]REDMONJ,FARHADI A.YOLOv3:An Incremental Improvement [J/OL].arXiv:1804.02767 [cs.CV].[2024-12-03]. https://arxiv.org/pdf/1804.02767.

[12]ZHANGY,WANGC,WANGX,etal.FairMOT: OntheFairnessofDetection and Re-Identification in Multiple Object Tracking[J].International JournalofComputerVision, 2021,129:3069-3087.

[13]GEIGERA,LENZP,STILLERC,etal.VisionMeetsRobotics:The KITTI Dataset[J].The International JournalofRoboticsResearch,2013,32(11):1231-1237.

作者简介:徐英卓(1964—),女,汉族,陕西西安人,二级教授,研究生导师,硕士,研究方向:深度学习与人工智能、程序设计;通信作者:张渊博(1998一),男,汉族,河南洛阳人,硕士研究生在读,研究方向:计算机视觉、深度学习;刘晓天(1999一),男,汉族,山东济南人,硕士研究生在读,研究方向:计算机视觉、深度学习。