摘 要:【目的】使用机器视觉对绿辣椒的精准识别是实现辣椒智能化采摘的重要前提,研究自然条件下辣椒遮挡情况、绿色辣椒及准确识别的方法,为辣椒智能化采摘机器人的精准识别提供技术支持。

【方法】提出一种基于改进YOLOv5辣椒目标检测模型,在YOLOv5主干网络加入CA(Coordinate Attention)注意力机制,以增强辣椒特征信息的提取,进一步增强对目标位置信息的提取;同时在特征融合网络中使用Bi-FPN结构,提高模型对遮挡辣椒的识别能力。

【结果】通过在自建辣椒数据集上进行训练,改进后的模型平均准确率达到91%,相比于研究其他所对比模型,改进模型的平均准确率更高。

【结论】基于改进YOLOv5的遮挡绿色辣椒的识别具有较高的准确性。

关键词:YOLOv5;CA注意力机制;Bi-FPN;绿辣椒检测;遮挡

中图分类号:S24"" 文献标志码:A"" 文章编号:1001-4330(2024)12-3032-10

0 引 言

【研究意义】中国辣椒种植面积和产量约占全球的40%和50%[1]。辣椒属于劳动密集型作物,其种植模式复杂,从育苗、移栽、定植、打杈、采收、分级等环节均需要人工。在辣椒的收获环节中,不同种植模式对收获机械的要求亦有差异。收获主要是以整株进行切割、打捆,之后再由人工去把、分级,仅辣椒采摘的人工成本便接近总成本的50%[2]。需提高辣椒的采收效率,减少损伤和降低人工成本[3]。

在引入深度学习理论之前,蔬菜、药材、水果检测方法大多使用基于传统机器学习方法[4],例如通过特征提取算法提取物体的颜色、形状、纹理等特征,利用机器学习算法对构成图像特征的特征向量进行分类,从而达到检测物体的目的。然而,这些方法通常缺乏通用性和鲁棒性[5]。

深度学习技术也广泛应用于目标检测领域[6]。与传统的机器学习方法相比,深度学习方法能够从数据集中提取深层次目标的特征,在解决目标检测等问题中具有优势。【前人研究进展】高云茜等[7]提出了一种基于YOLOv5的草莓采摘机器人的目标检测技术,使用CBAM注意力并结合优化K-means等方法提高对小目标的检测效果,在实际场景下该方法准确率可达94.36%。Tian等[8]提出一种改进的YOLOv3模型,用于检测不同阶段的苹果,以适应果园的复杂环境。结果表明,新模型优于原始YOLOv3模型和基于区域的快速卷积神经网络模型(Fast R-CNN)。段洁利等[9]基于YOLOv5提出一种检测蕉穗的算法,通过对蕉穗底部果轴定位,其平均精度值(mAP)达到99.29%。Wang等[10]提出了一种基于YOLOv5s模型在复杂环境下对小米辣进行检测算法,实现在自然条件下小米辣的检测与识别,平均准确度达到95.46%,该模型参数量减少,但整体识别仍然存在漏检。【本研究切入点】深度学习算法具有较强的提取图像特征的能力,受环境干扰程度较低。相较于传统方法,深度学习算法在自然环境下对果实的识别效果有较好的提升,但是由于自然环境下背景复杂,提高遮挡果实的检测[11]性能仍然是目前研究的重点。YOLOv5是一种较为先进和流行的对象检测模型,是YOLO模型系列的一部分。需针对自然环境下辣椒遮挡以及背景环境相近等问题,设计一种改进YOLOv5的绿辣椒目标检测模型。

【拟解决的关键问题】在模型骨干网络中添加CA注意力机制模块,通过在信道注意力中嵌入位置信息,使得移动网络能够在大范围内关注,同时避免产生大量的计算开销[12];在颈部网络中,将原始网络的特征金字塔替换为加权的双向金字塔的Bi-FPN结构,使网络能够方便、快速的进行多尺度特征融合[13]。通过对自然条件下的绿辣椒进行精准检测,从而实现辣椒采摘机器人的自动化操作。

1 材料与方法

1.1 材 料

1.1.1 辣椒图像

以绿色辣椒作为目标检测对象,数据采集于新疆昌吉市新疆华兴投资集团有限公司下华兴农场拍摄制作,原始图像数量共1 057张,通过数据处理及扩增最终得到1 683张辣椒图像。数据采集均为人工拍摄,采集的图像为720×1 280分辨率,保存格式为JPG图像格式。采集时间段为09:00~13:00,晴天天气情况。采集时手机镜头距离辣椒藤20~80 cm,俯仰角0°~20°,包含逆光、辣椒遮荫、树叶遮挡等多种情况。图像预处理后首先在图像中随机选取1 495张作为训练集,143张作为验证集,按照8∶1∶1的比例进行划分训练。

1.1.2 数据预处理及标注

对遮挡超过辣椒整体90%的进行删除操作,图像数量从原始1 057张减至784张图片。通过对原始图像进行增加对比度、亮度等数据增强方法,减少光照环境变化和采集设备的差异造成的影响。将辣椒图像扩增到1 683张。按照PASCAL VOC2007标准对辣椒目标进行标注,采用labelme软件对辣椒图片进行标注。标注文件存储为xml格式,标注文件包含辣椒目标所在图像的坐标位置、辣椒图像的大小以及标签名papper,使用Python将格式转化为txt格式。将辣椒图片和标注好的文件按照YOLO数据集格式分别放在images和labels文件夹,组成本研究所使用的辣椒数据集。图1

1.2 方 法

1.2.1 YOLOv5模型

YOLOv5共5个版本,5个版本中的子模块采用了不同的深度和宽度,且随着模型深度的加深,检测精度会得到提升,检测速度也会降低。图2

YOLOv5网络结构主要由输入端(Input)、骨干网络(Backbone)、颈部(Neck)、检测头(Head)四部分组成。Input部分分别为提高数据集复杂度的Mosaic数据增强[14]、自适应的计算不同训练集中的最佳锚框值的自适应锚框计算、实现图像尺寸大小统一的自适应图片缩放。Backbone主要由卷积模块(Conv)、C3模块、SPPF模块[15]构成,用来提取目标特征信息,并且不断缩小特征图。Neck由协同工作的特征金字塔(Feature Pyramid Networks, FPN)[16]和路径聚合网络(Path Aggregation Networks, PAN)[17]2部分构成。其中,FPN是实现自顶向下的特征金字塔,PAN是实现自底向上的路径聚合网络。两个模块用来增强网络特征整合能力,将浅层的图形特征和深层的语义特征相结合,丰富上下文语义特征,以获取更为完整的特征。Head层为Detect模块,包括3个head,拥有不同的预测尺度,预测结果,并生成对应类别预测框[18]。

1.2.2 改进YOLOv5模型

YOLOv5的网络结构主要由骨干网络(Backbone)、颈部网络(Neck)以及检测头部分(Head)组成。根据模型大小,YOLOv5网络模型可以分为YOLOv5n、YOLOv5s、YOLOv5m、YOLOv5l以及YOLOv5x,选择较轻量级的YOLOv5s模型进行改进。图3

(1)在Backone网络中加入CA(Coordinate Attention)注意力机制模块,在SPPF模块之前加入CA注意力机制模块,加强对目标的位置信息和通道信息的提取,提高目标的位置信息。

(2)在Neck网络中替换Bi-FPN特征金字塔结构,充分结合浅层与深层的特征信息,进行特征信息的快速融合,提高对遮挡目标的检测效果。

1.2.3 CA注意力模块

CA(Coordinate Attention)注意力模块相比于其他注意力模块,其将位置信息嵌入到通道注意力中,获取更大区域信息,强化辣椒特征信息并且弱化背景信息[19-21]。

CA注意力模块的实现分为全局信息嵌入和坐标注意力生成。图4

CA注意力模块首先进行坐标注意力对输入特征图沿着水平和垂直两个方向进行全局池化操作,具体而言,对输入特征张量X=[x1,x2,…xe]∈Rc×Hxw,先使用尺寸(H,1)和(1,W)的池化核分别沿水平方向和竖直方向对每个通道进行编码,从而得到高度h处的第C通道的输出和宽度w处的第c通道的两个特征映射zh和zw,输出可以公式化为:

zhc(h)=1w0≤i≤wxc(h,i). (1)

zwc(w)=1H0≤j≤Hxc(j,w). (2)

2个变换沿着两个空间方向进行特征聚合,随后级联生成的两个特征图,然后使用1×1卷积变换函数F1形成中间特征图:

F=(F1([zh,zw])).(3)

式(3)中,F∈RC/r*(H+W) ,接着,沿着空间维度将瘙楋切分为两个单独的张量fh∈RC/rH 和fw∈RC/rW ,再利用两个1×1卷积Fh和Fw将特征图gh和gw变换到和原始输入X同样的通道数的特征张量,得到下式的结果:

gh=σ(Fh(fh)).(4)

gW=σ(Fw(fw)).(5)

式(4)(5)中,σ为sigmoid激活函数。将gh和gw进行拓展,作为注意力权重,最后在原始特征图X上通过乘法加权计算,即可得到CA注意力机制的模块输出Y=[y1,y2,…yc]为:

yc(i,j)=xc(i,j)ghc(i)gwc(j).(6)

1.2.4 Bi-FPN双向特征融合网络

原始YOLOv5网络中,采用FPN和PANet网络结构进行特征融合,特征金字塔网络(Feature Pyramid Network, FPN)具有一条自上而下的通路,其目的是融合浅层的位置信息和深层的语义信息。路径聚合网络(Path Aggregation Network, PANet)网络基于FPN进行改进,不仅自上向下进行特征融合,不仅自上向下进行特征融合,还额外增加了自底向上的路径聚合通路,可提取更多的浅层特征与高级特征,从而达到减少信息丢失的目的[12,22]。使用Bi-FPN特征融合网络来替换,能够将来自不同层级的特征图融合成更加丰富的特征,提供更全面的信息给检测头Bi-FPN是一种加权双向特征金字塔网络结构,通过引入可学习的权值来学习不同输入特征,同时重复应用自顶向下和自底向上的多尺度特征融合,对不同的分辨率的输入图像进行快速有效的特征信息融合。双向跨尺度连接:首先,剔除单一输入的结点;其次是引入跳跃连接机制,增加一条特征融合路径,利用3个不同尺度的特征图将浅层特征图位置信息和深层次特征图位置信息融合,利用加权特征融合使得网络更侧重关键特征信息得融合,从而提高网络提取特征能力[23-24]。图5

Bi-FPN加权特征融合计算方式为:

Out=i=0wi*Ii+∑j=0wj. (7)

式(7)中,w表示可学习权重;Ii表示输入特征。

Bi-FPN相当于给各个层赋予不同权重去进行融合,让网络更加关注重要的层次,而且还减少一些不必要的层的结点连接。通过引入双向加权特征融合结构Bi-FPN,来加强特征融合,从而提取到更多遮挡目标的细节信息,提高检测效率。

1.2.5 试验环境及模型参数

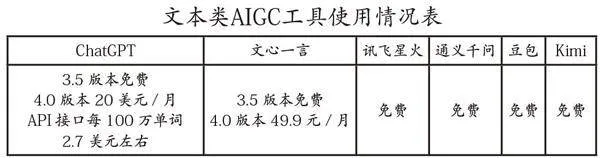

使用Ubuntu16.3操作系统,显卡型号为Nvidia GeForce RTX 3090 24 GB,处理器型号为Xeon(R) Platinum 8336C,深度学习框架为PyTorch,编程平台为PyCharm,编程语言为Python3.8,使用以上试验环境对模型进行训练和测试,所有对比模型均在相同试验环境下运行。表1

1.2.6 模型评价指标

评价模型性能和有效性的相关指标为精确率(Precision, P)、召回率(Recall, R)、以及平均精度均值(mean Average precision, mAP)。

P=TPTP+FP×100%.(8)

R=TPTP+FN×100%.(9)

AP=∫01P(r)dr.(10)

mAP=1n∑ni=1AP.(11)

式中,TP指预测为正类的正样本(真正例);FN指预测为负类的正样本(假反例);FP 指预测为正类的负样本(假正例);P指在图像中所有预测的样本为正类的比例;召回率R 指预测正类的样本与所有正样本的比例;AP指P和R所围成地面积定义,用于衡量某一类精度,所有的检测类别AP地均值为mAP,通常mAP越大,模型的性能越好,是衡量目标检测模型性能的重要指标。由于仅针对辣椒单一类进行检测,故使用mAP@0.5作为评估模型精度的指标,mAP@0.5表示IoU为0.5时的mAP值,更加适合快速检测。

2 结果与分析

2.1 模型对比

研究表明,研究模型在平均精确率上为最高,虽然相较于YOLOv5s模型参数和权重大小略微增加,但是其平均精确率比YOLOv5s提高了1.5个百分点,提高了检测效果。 Faster-RCNN置信度为最高,但是存在误检的情况;与YOLOv7、原始YOLOv5s相比,本模型置信度整体相对较高,尤其是对遮挡严重目标,高于上述2个模型,进一步提高对遮挡目标的检测;与YOLOv8s相比,出现其模型漏检情况。在相同复杂背景条件下,改进模型各项指标未达到最优,改进后的模型检测效果提升明显,验证了改进模型的有效性。

在相同条件下,相比于Faster-RCNN模型来说,改进后的YOLOv5模型对遮挡目标的置信度低于Faster-RCNN模型,但是不存在误检问题,且模型的参数量远小于Faster-RCNN模型,有利于在采摘机器人上的使用。改进后YOLOv5模型在参数量远小于YOLOv7模型的情况下,对于一些遮挡严重的绿辣椒,其置信度高于YOLOv7模型。模型在对于遮挡绿辣椒检测方面的性能高于原始YOLOv5s模型和YOLOv8模型,对绿辣椒的检测效果更加优越,提高了检测性能,且对于遮挡辣椒的检测精度有所提升,更适合在自然条件下进行应用。改进后模型提高了精准度,并且参数量远小于Faster-RCNN、YOLOv7、YOLOv8s模型,从而对实现辣椒采摘机器人的自动化操作提供了前提条件。表2,图6

2.2 不同注意力模块性能对比

研究表明,使用CA注意力机制模块可更好的关注目标位置,提高检测效率。添加CA注意力模块相较于其他两个注意力模块,可以更加快速收敛并持续降低损失值。

在骨干网络分别添加注意力模块均能提高模型检测精度。由于CA注意力机制使用全局平均池化来获取通道维数的特征信息,在几乎不带来额外计算开销的情况下获取更大区域信息,强化辣椒特征信息并且弱化背景信息。CA注意力模块与其他注意力模块相比平均精度更高,更适合自然条件下绿色辣椒的采摘,选择在骨干网络中加入CA注意力模块的优越性。表3,图7

2.3 消融试验

研究表明,添加CA模块的YOLOv5s模型,其召回率提升1.5%,精确率稍微下降,平均精确率略微提升。添加Bi-FPN模块的YOLOv5s模型,其召回率提升0.6%,精确率稍微下降,但是其mAP@0.5从89.5%提升至90.7%,提升了1.2%,Bi-FPN模块能融合更多不同特征,实现双向特征信息融合。通过Bi-FPN双向特征融合模块和CA注意力模块的结合,其精确率及mAP@0.5分别提升0.9%、1.5%,两者结合是能提高模型的检测准确率。所改进模型有效的提高了检测性能,使模型检测绿辣椒的准确度进一步增强。

当IOU=0.5时的平均精度,性能逐步稳定增强。在改进之初,模型损失初值最高,在改进后,模型的收敛速度加快,损失值越来越小,模型收敛能力加强。表4,图8

3 讨 论

3.1 将在原始的YOLOv5s骨干中分别添加GAM(Global Attention Mechanism)注意力模块[25]、EMA(Efficient Multi-Scale Attention)注意力模块[26]以及CA注意力模块。

在与其他目标检测模型(如Faster-RCNN、YOLOv8等)相比,在自建数据集上,改进后YOLOv5的网络结构具有更高的准确度和计算效率。在数据集上,改进的YOLOv5相较于原始模型在mAP上有较大提升,能够较好地平衡精度和模型体积之间的关系。然而,改进后的模型也存在局限性,例如对遮挡严重的目标存在置信度较低的问题。改进模型的过程中增加了参数量以及计算量,虽然导致模型体积略微提升,但是在一定程度上降低了背景对检测效果影响,提高检测准确率不高的问题,改进后的模型能够完成任务。

3.2 在试验过程中部分辣椒未被识别,出现漏检问题,经过分析,主要原因为拍摄角度问题,不同的拍摄角度,图像中的辣椒的形态会有差别,部分被叶片遮挡严重的辣椒以及辣椒相互遮挡的情况,造成无法识别的问题。后续研究,可以拍摄更加丰富的数据集,进一步提高辣椒检测的准确率和鲁棒性。

4 结 论

通过在自建辣椒数据集上进行训练,改进后的模型平均准确率达到91%,相比于研究其他所对比模型,改进模型的平均准确率更高。改进YOLOv5的遮挡绿色辣椒的识别具有较高的准确性。

参考文献(References)

[1]张子峰. 我国辣椒产业发展现状、主要挑战与应对之策[J]. 北方园艺, 2023,(14): 153-158.

ZHANG Zifeng. Current development situation, main challenges and its countermeasures of the pepper industry in China[J]. Northern Horticulture, 2023,(14): 153-158.

[2] 段洁利, 王昭锐, 叶磊, 等. 水果采摘机械臂运动规划研究进展与发展趋势[J]. Journal of Intelligent Agricultural Mechanization(in Chinese and English), 2021, (2): 7-17.

DUAN Jieli, WANG Zhaorui, YE Lei, et al. Research progress and development trend of motion planning of fruit picking robot arm[J]. Journal of Intelligent Agricultural Mechanization, 2021, (2): 7-17.

[3] 金晶, 张小明, 付浩. 贵州省辣椒产业发展现状及建议[J]. 北方园艺, 2021,(21): 152-156.

JIN Jing, ZHANG Xiaoming, FU Hao. Status and suggestions of chili industry development in Guizhou Province[J]. Northern Horticulture, 2021,(21): 152-156.

[4] Kang D, Benipal S S, Gopal D L, et al. Hybrid pixel-level concrete crack segmentation and quantification across complex backgrounds using deep learning[J]. Automation in Construction, 2020, 118: 103291.

[5] 韩文霆, 崔家伟, 崔欣, 等. 基于特征优选与机器学习的农田土壤含盐量估算研究[J]. 农业机械学报, 2023, 54(3): 328-337.

HAN Wenting, CUI Jiawei, CUI Xin, et al. Estimation of farmland soil salinity content based on feature optimization and machine learning algorithms[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(3): 328-337.

[6] 陈小毛, 王立成, 张健, 等. 融合YOLOv5与ASFF算法的海产品目标检测算法研究[J]. 无线电工程, 2023, 53(4): 824-830.

CHEN Xiaomao, WANG Licheng, ZHANG Jian, et al. Research on seafood object detection algorithm integrating YOLOv5 and ASFF algorithm[J]. Radio Engineering, 2023, 53(4): 824-830.

[7] 周岳淮, 李震, 左嘉明, 等. 基于改进YOLOv5s模型的山地果园单轨运输机搭载柑橘的检测[J]. 湖南农业大学学报(自然科学版), 2023, 49(4): 491-496.

ZHOU Yuehuai, LI Zhen, ZUO Jiaming, et al. Detection of Citrus carried by mountainous orchard monorail transporter based on improved YOLOv5s[J]. Journal of Hunan Agricultural University (Natural Sciences), 2023, 49(4): 491-496.

[8] Tian Y N, Yang G D, Wang Z, et al. Apple detection during different growth stages in orchards using the improved YOLO-V3 model[J]. Computers and Electronics in Agriculture, 2019, 157: 417-426.

[9] 段洁利, 王昭锐, 邹湘军, 等. 采用改进YOLOv5的蕉穗识别及其底部果轴定位[J]. 农业工程学报, 2022, 38(19): 122-130.

DUAN Jieli, WANG Zhaorui, ZOU Xiangjun, et al. Recognition of bananas to locate bottom fruit axis using improved YOLOv5[J]. Transactions of the Chinese Society of Agricultural Engineering, 2022, 38(19): 122-130.

[10] Wang F H, Sun Z X, Chen Y, et al. Xiaomila green pepper target detection method under complex environment based on improved YOLOv5s[J]. Agronomy, 2022, 12(6): 1477.

[11] 王圆圆, 林建, 王姗. 基于YOLOv4-tiny模型的水稻早期病害识别方法[J]. 江苏农业科学, 2023, 51(16): 147-154.

WANG Yuanyuan, LIN Jian, WANG Shan. An early rice disease recognition method based on YOLOv4-tiny model[J]. Jiangsu Agricultural Sciences, 2023, 51(16): 147-154.

[12] Tang Z, Zhou L, Qi F, et al. An improved lightweight and real-time YOLOv5 network for detection of surface defects on Indocalamus leaves[J]. Journal of Real-Time Image Processing, 2023, 20(1): 14.

[13] 高芳征, 汤文俊, 陈光明, 等. 基于改进YOLOv3的复杂环境下西红柿成熟果实快速识别[J]. 中国农机化学报, 2023, 44(8): 174-183.

GAO Fangzheng, TANG Wenjun, CHEN Guangming, et al. Fast recognition of ripe tomato fruits in complex environment based on improved YOLOv3[J]. Journal of Chinese Agricultural Mechanization, 2023, 44(8): 174-183.

[14] 朱立成, 韩振浩, 赵博, 等. 基于VINS-MONO和改进YOLO v4-Tiny的果园自主寻筐方法[J]. 农业机械学报, 2023, 54(8): 97-109.

ZHU Licheng, HAN Zhenhao, ZHAO Bo, et al. Autonomous basket searching method for orchards transporter based on VINS-MONO and improved YOLO v4-tiny[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(8): 97-109.

[15] He K M, Zhang X Y, Ren S Q, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[16] 汤文虎, 吴龙, 黎尧, 等. 基于改进Faster RCNN的钢线圈头部小目标检测算法[J]. 现代制造工程, 2023, (8): 127-133, 147.

TANG Wenhu, WU Long, LI Yao, et al. Improved faster RCNN based steel coil head detection algorithm for small objects[J]. Modern Manufacturing Engineering, 2023, (8): 127-133, 147.

[17] 吕宗旺, 邱帅欣, 孙福艳, 等. 基于改进YOLOv5s的轻量化储粮害虫检测方法[J]. 中国粮油学报, 2023, 38(8): 221-228.

LYU Zongwang, QIU Shuaixin, SUN Fuyan, et al. Lightweight grain storage pest detection method based on improved YOLOv5s[J]. Journal of the Chinese Cereals and Oils Association, 2023, 38(8): 221-228.

[18] 李淑菲, 李凯雨, 乔岩, 等. 基于可见光光谱和改进YOLOv5的自然场景下黄瓜病害检测方法[J]. 光谱学与光谱分析, 2023, 43(8): 2596-2600.

LI Shufei, LI Kaiyu, QIAO Yan, et al. Cucumber disease detection method based on visible light spectrum and improved YOLOv5 in natural scenes[J]. Spectroscopy and Spectral Analysis, 2023, 43(8): 2596-2600.

[19] Hong W W, Ma Z H, Ye B L, et al. Detection of green Asparagus in complex environments based on the improved YOLOv5 algorithm[J]. Sensors, 2023, 23(3): 1562.

[20] 杨国亮, 王吉祥, 聂子玲. 基于改进型YOLOv5s的番茄实时识别方法[J]. 江苏农业科学, 2023, 51(15): 187-193.

YANG Guoliang, WANG Jixiang, NIE Ziling. A real-time tomato recognition method based on improved YOLOv5s[J]. Jiangsu Agricultural Sciences, 2023, 51(15): 187-193.

[21] 李尚平, 郑创锐, 文春明, 等. 基于改进YOLO v5s的甘蔗切种茎节特征识别定位技术[J]. 农业机械学报, 2023, 54(10): 234-245,293.

LI Shangping, ZHENG Chuangrui, WEN Chunming, et al. Stem node feature recognition and positioning technology for transverse cutting of sugarcane based on improved YOLO v5s[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(10): 234-245,293.

[22] 姜国权, 杨正元, 霍占强, 等. 基于改进YOLOv5网络的疏果前苹果检测方法[J]. 江苏农业科学, 2023, 51(14): 205-215.

JIANG Guoquan, YANG Zhengyuan, HUO Zhanqiang, et al. Apple detection method before thinning fruit based on improved YOLOv5 model[J]. Jiangsu Agricultural Sciences, 2023, 51(14): 205-215.

[23] Zhe T,Lin Z,Fang Q, et al. An improved lightweight and real-time YOLOv5 network for detection of surface defects on indocalamus leaves[J]. Journal of Real-Time Image Processing,2023,20(1).

[24] 杨永闯, 王昊, 王新良. 基于改进SSD的食物浪费行为识别方法[J]. 计算机工程与设计, 2023, 44(8): 2523-2530.

YANG Yongchuang, WANG Hao, WANG Xinliang. Food waste behavior recognition method based on improved SSD[J]. Computer Engineering and Design, 2023, 44(8): 2523-2530.

[25] 郭殿鹏, 柯海森, 李孝禄, 等. 基于改进YOLOv7的织物疵点检测算法[J]. 棉纺织技术, 2023, 51(12): 5-11.

GUO Dianpeng, KE Haisen, LI Xiaolu, et al. Fabric defect detection algorithm based on improved YOLOv7[J]. Cotton Textile Technology, 2023, 51(12): 5-11.

[26] 崔海彬, 蒲东兵, 陆云凤, 等. 基于CA-YOLO的安全帽佩戴检测[J]. 东北师大学报(自然科学版), 2023, 55(3): 94-100.

CUI Haibin, PU Dongbing, LU Yunfeng, et al. Helmet wearing detection based on CA-YOLO[J]. Journal of Northeast Normal University (Natural Science Edition), 2023, 55(3): 94-100.

Green chili pepper target detection method based on improved YOLOv5

WANG Zhenlu1, BAI Tao1,2, LI Dongya1, DAI Shuo1, CHEN Zhen1

(1. College of Computer and Information Engineering, Xinjiang Agricultural University, Urumqi 830052, China; 2. Engineering Research Center for Intelligent Agriculture of Ministry of Education/Xinjiang Research Center for Agricultural Information Technology, Urumqi 830052, China)

Abstract:【Objective】 Accurate recognition of green chili peppers using machine vision is an important prerequisite for realizing intelligent picking of chili peppers, so in view of the natural conditions of pepper occlusion, this study aims to accurately identify the problem.

【Methods】 A chili pepper target detection model based on improved YOLOv5 was proposed, CA (Coordinate Attention) was added in YOLOv5 backbone network Attention mechanism in the YOLOv5 backbone network to enhance the extraction of chili pepper feature information and further enhance the extraction of target location information; meanwhile, a Bi-FPN structure was used in the feature fusion network to improve the models ability to recognize occluded chili peppers.

【Results】 By training on the self-constructed chili pepper dataset, the results showed that the improved model achieved an average accuracy of 91%, which was higher compared to the other models.

【Conclusion】" The method proposed in this paper has high accuracy in recognizing occluded green chili peppers in natural environments, which can provide technical support for the accurate recognition of chili pepper intelligent picking robots.

Key words:YOLOv5; CA attention mechanism; Bi-FPN; green chili pepper detection; shading

Fund projects: S amp;T Innovation 2030 Major Project of Ministry of Science and Technology \"Group Intelligent Independent Operation of Intelligent Farm\" (2022ZD0115800);Major Scientific R amp; D Program Project of Xinjiang Uygur Autonomous Region \"Research on Key Technologies of Farm Intelligent Platform\" (2022A02011-4); Central Government Guiding the Local Science and Technology Development Special Fund Project (ZYYD2022B14); Basic Scientific Research Project for Universities in Xinjiang Uygur Autonomous Region \"Agricultural Big Data Exchange, Sharing and Visualization Platform\" (XJEDU2022J009)

Correspondence author:BAI Tao (1979-), male, from Urumqi, Xinjiang, masters degree, associate professor, research direction: agricultural big data, data mining,(E-mail)bt@xjau.edu.cn

基金项目:科技部科技创新2030重大项目“群体智能自主作业智慧农场”(2022ZD0115800);新疆维吾尔自治区重大科技专项“农场智能平台关键技术研究”(2022A02011-4);中央引导地方科技发展专项“智慧农业创新平台建设”(ZYYD2022B12);新疆维吾尔自治区高校基本科研业务费科研项目“农业大数据交换共享与可视化平台”(XJEDU2022J009)

作者简介:王震鲁(2000-),男,山东济宁人,硕士研究生,研究方向为计算机视觉、物联网,(E-mail)2425387367@qq.com

通讯作者:白涛(1979-),男,新疆乌鲁木齐人,副教授,硕士生导师,研究方向为农业大数据、数据挖掘,(E-mail)bt@xjau.edu.cn